blog's People

blog's Issues

高性能缓存库risterio

risterio code reading

risterio是一个基于内存的高性能KV存储,具有较高的读写性能和可靠性。它采用了多种技术来优化性能,分析代码可以看看具体的实现。

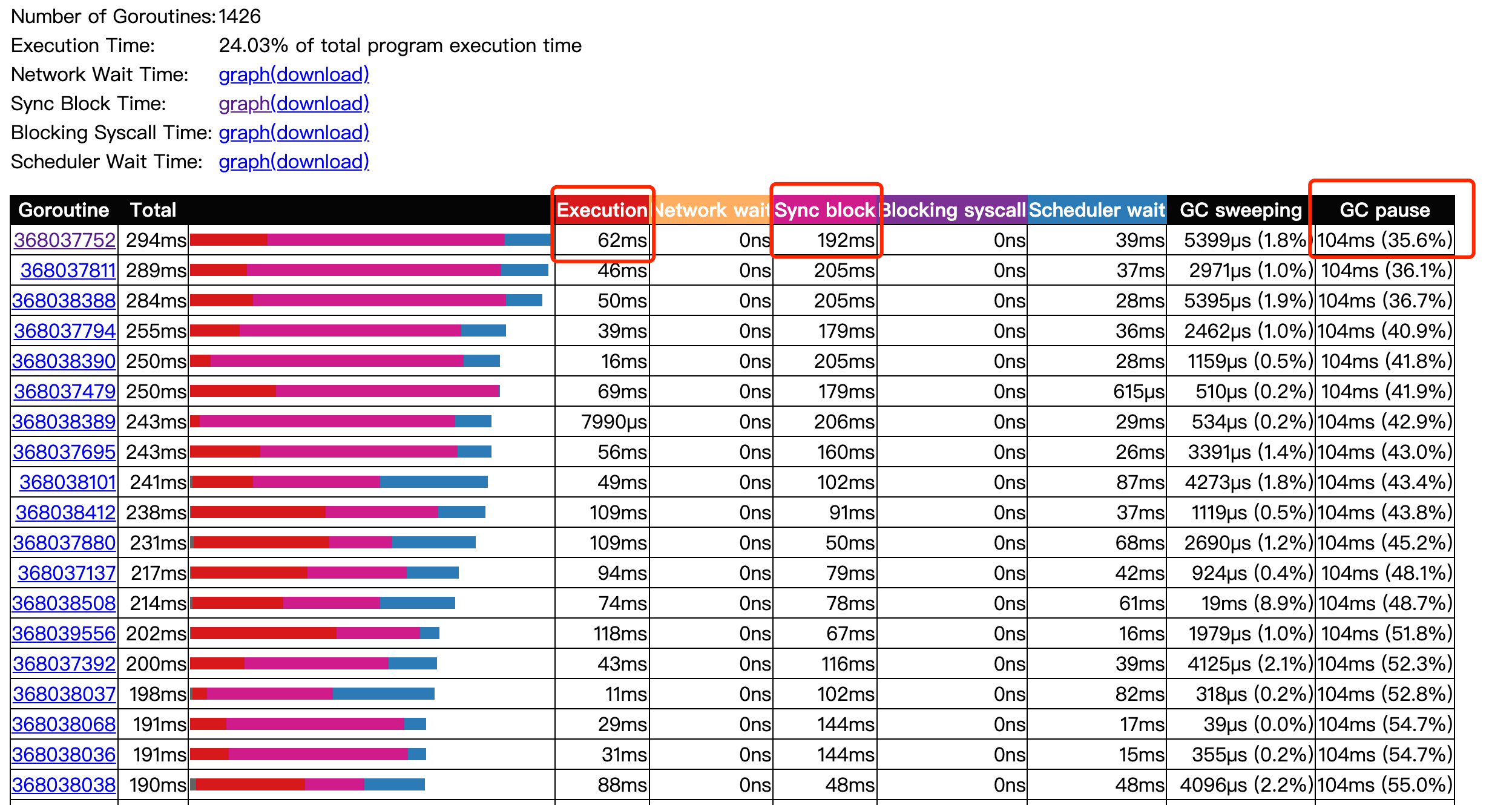

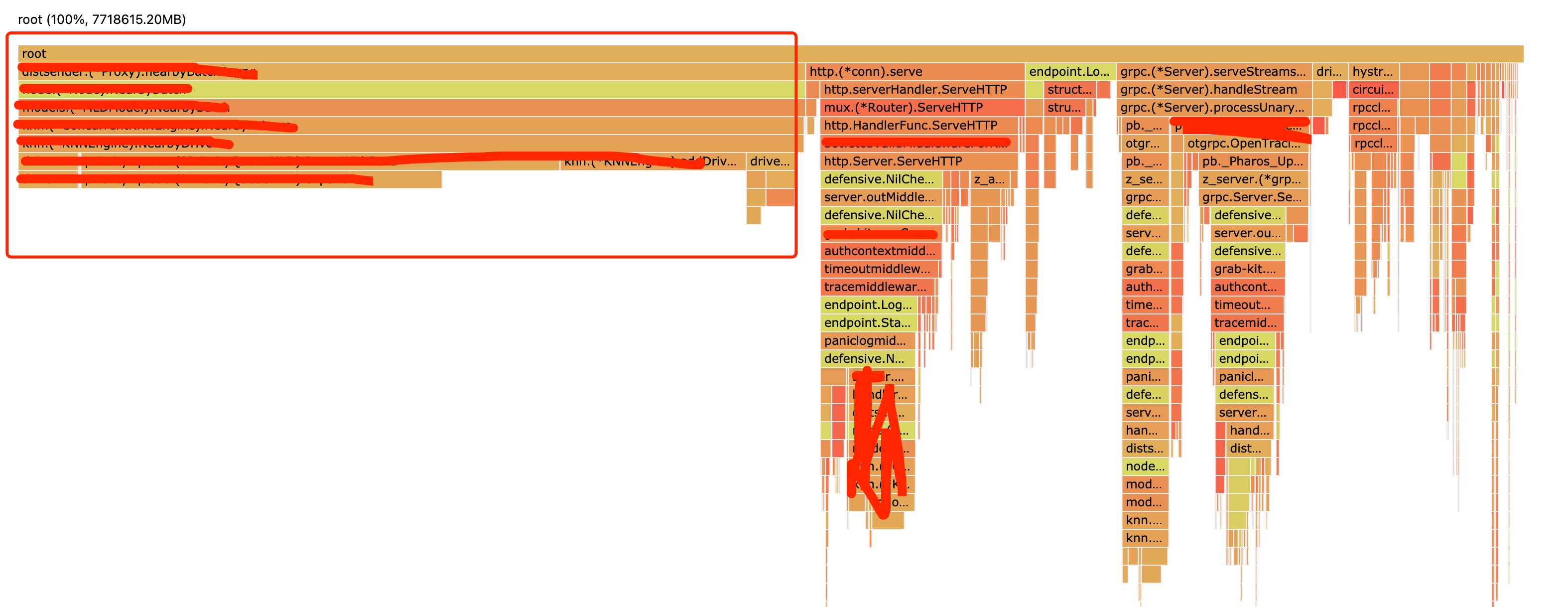

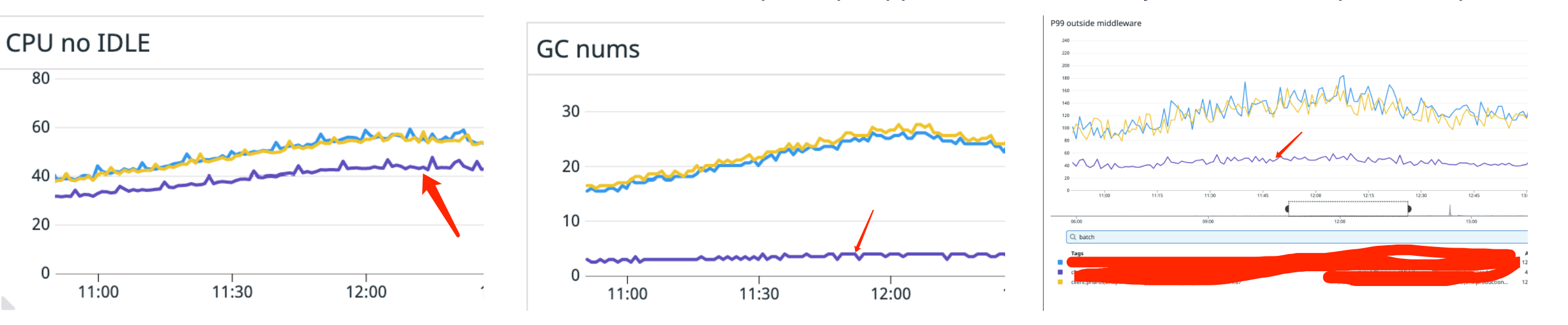

sync.Pool 实现BP-Wrapper

BP-Wrapper是一种无锁算法,BP代表的是batching和prefetching的缩写,在risterio中主要使用了batching的**。

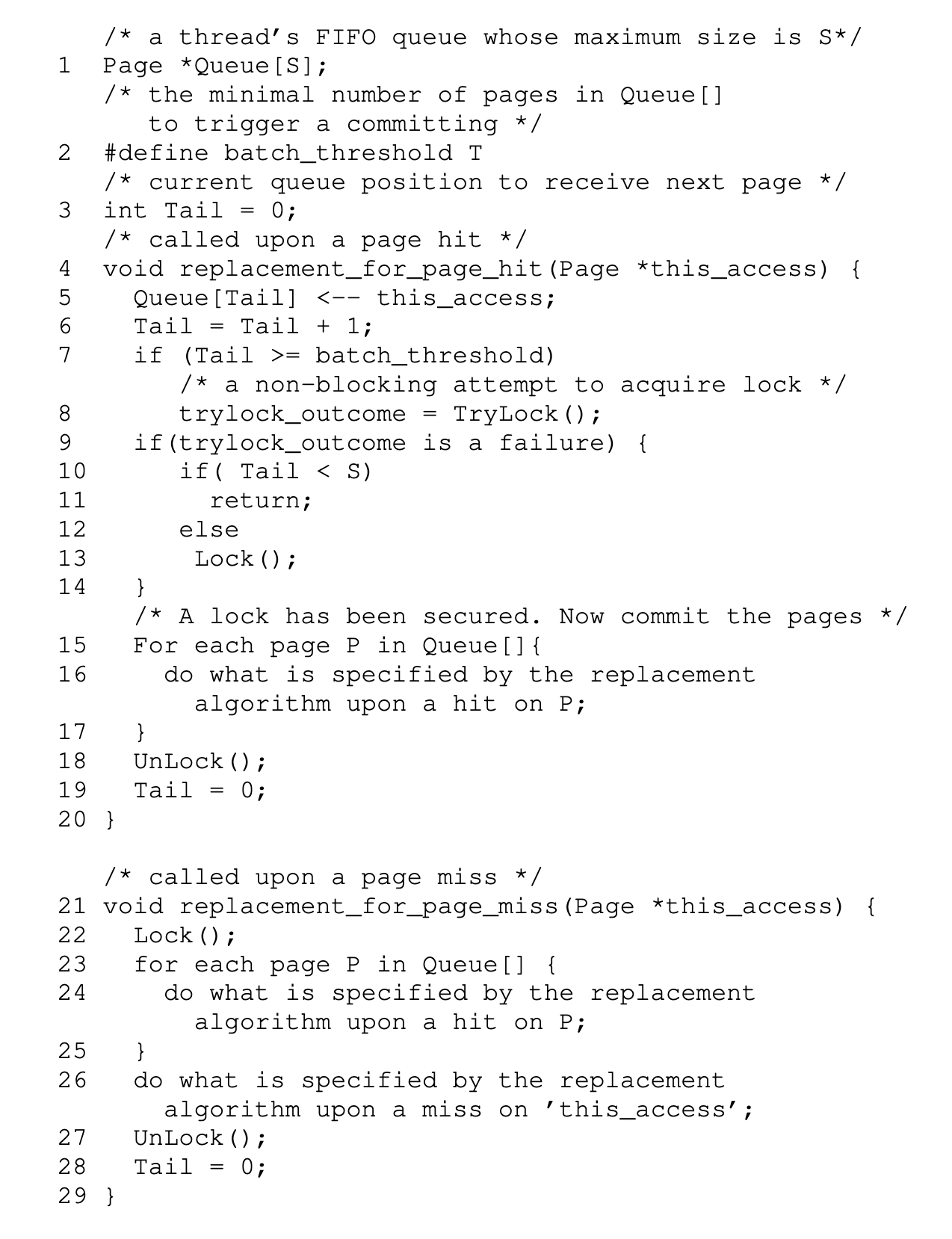

Batching

batching比较容易理解,论文中为每个线程设置了一个FIFO队列,每个页面请求都会先进入队列,当队列满或符合特定条件后再获取锁进行后续操作。这样会有一定的延迟,是否需要使用batching也取决于业务场景是否能够接受。

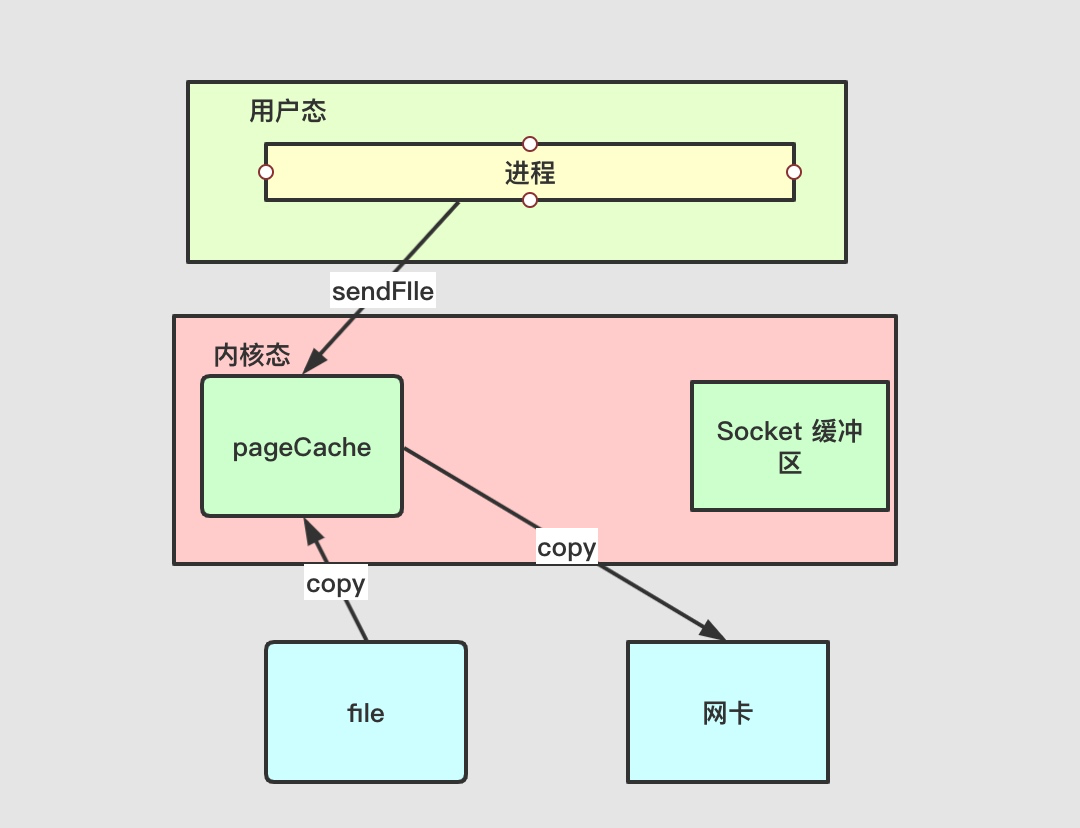

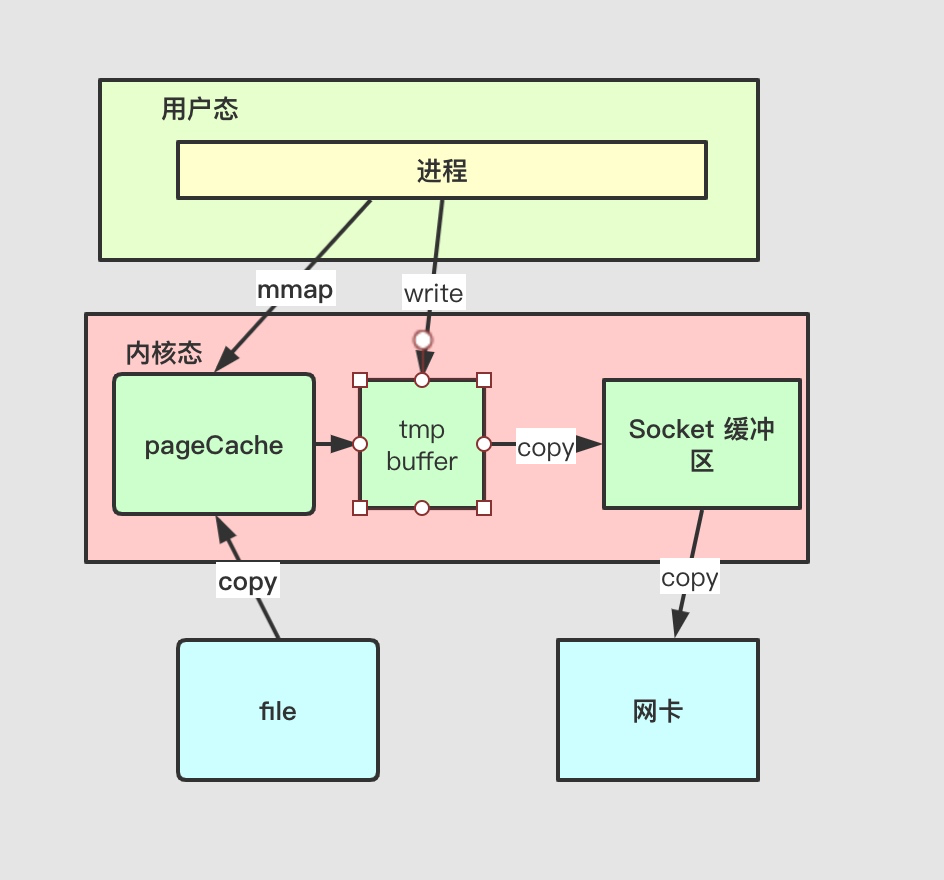

Batching的**在很多场景中都有应用,比如TCP的缓冲区,以及一些数据处理任务中的批处理操作。将一些操作缓存下来,通过一定的时间或者数量的积累后再批量处理,可以有效地减少系统调用和网络传输的开销,提高系统的吞吐量和性能表现。在使用Redis或Kafka等系统时,通过缓冲一些操作再进行批量处理,也可以降低连接数,减轻系统负载,提高整体性能。

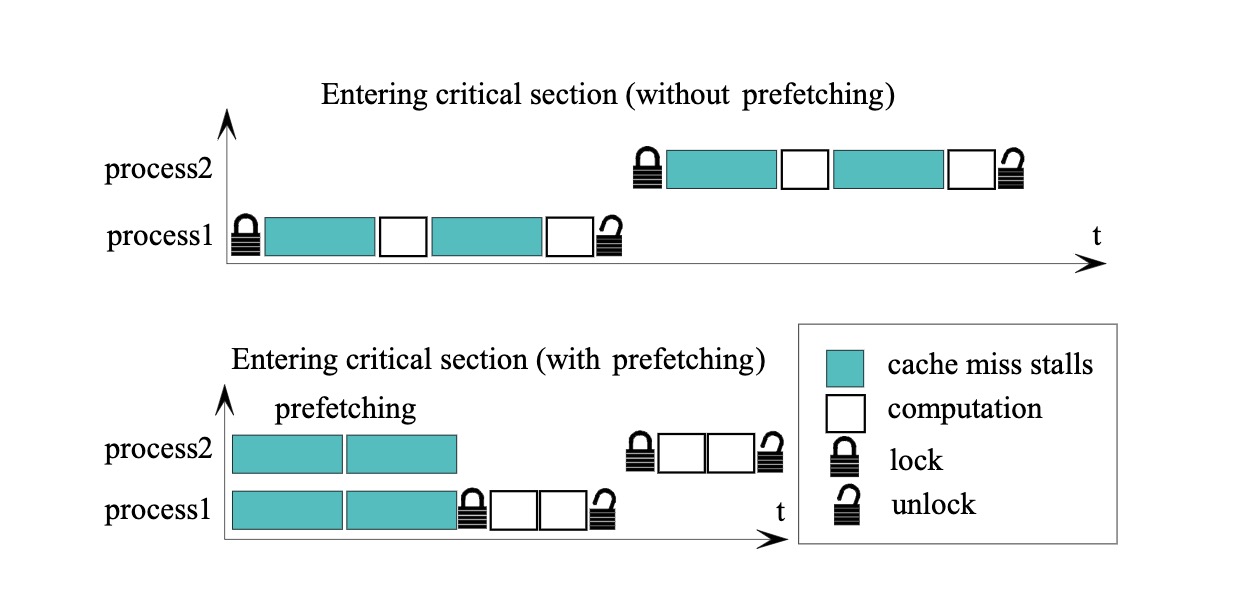

Prefetching

Prefetching在论文中没有详细描述,但通过图示可以比较清楚地了解其作用,简单来说就是为了避免在锁定并发访问的情况下发生cache miss并需要进行I/O操作。因此,Prefetching可以在进行计算之前提前获取数据,只有在实际进行计算时才需要对数据进行加锁。

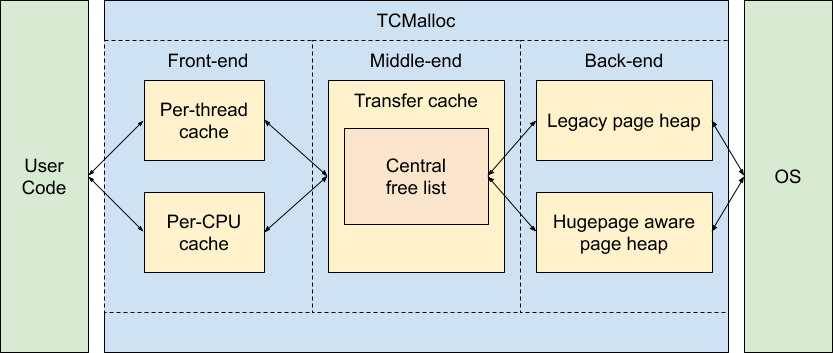

Sync.Pool 实现

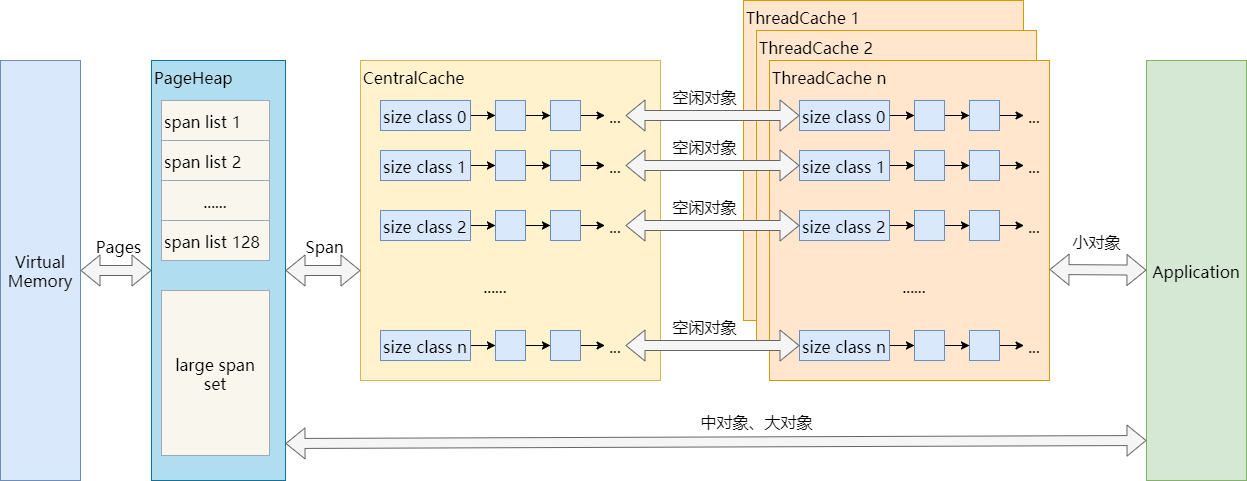

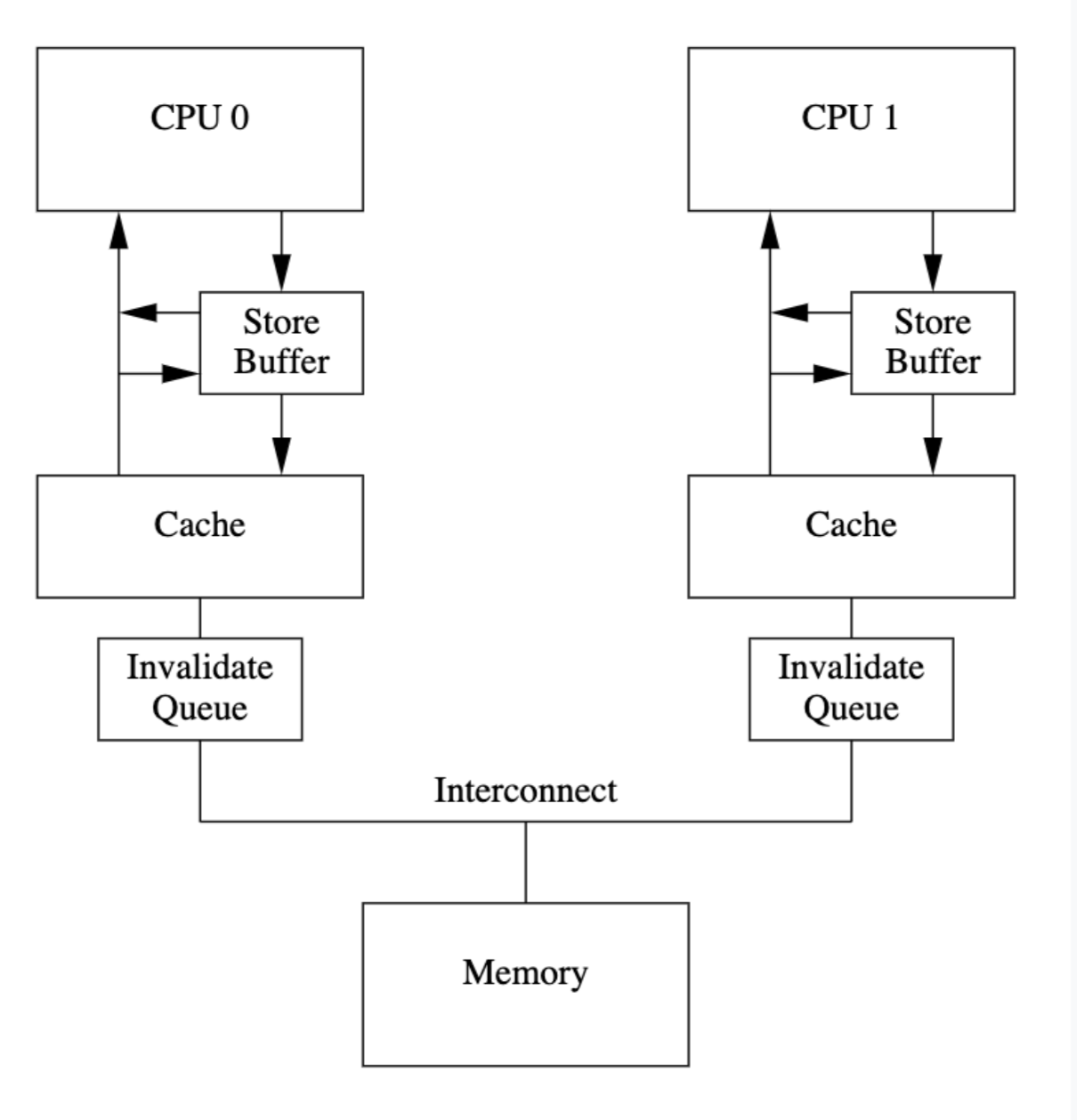

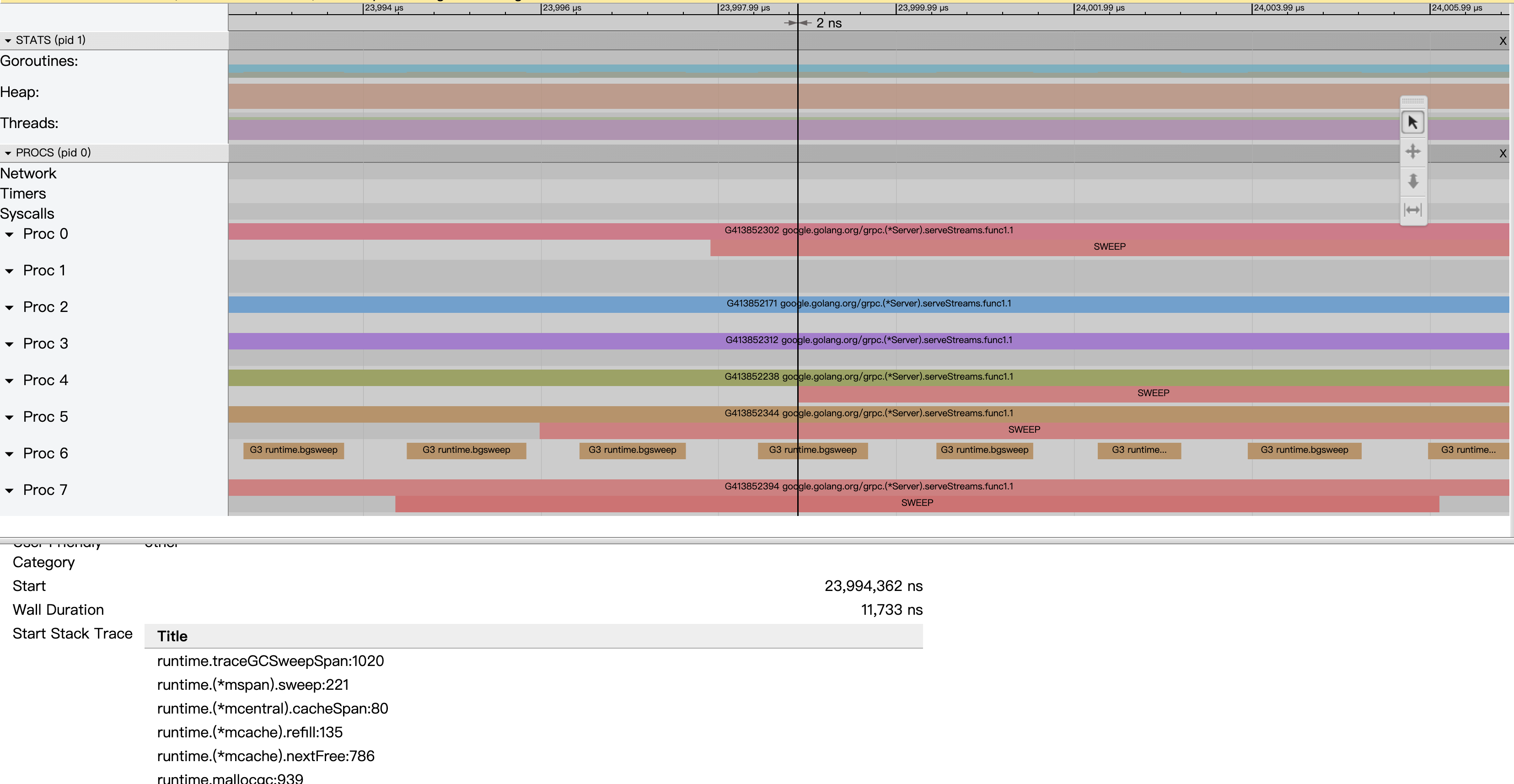

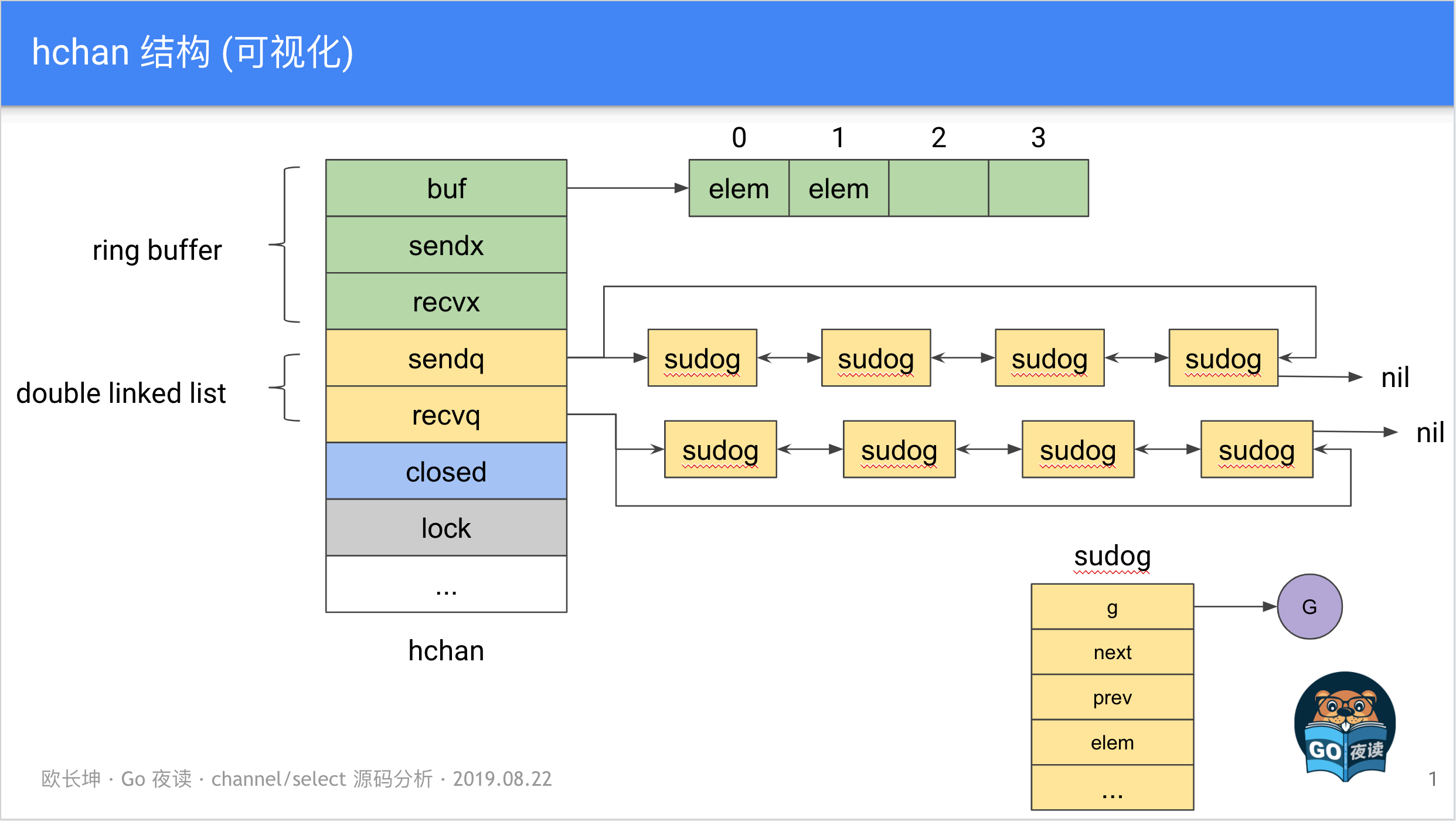

他们的blog提到过实现批处理的功能,但也有提到使用channel的方式,不过通道的性能并没有sync.Pool表现得那么好。这是因为sync.Pool底层对于P做了一些优化,相当于实现了一层本地TLS(thread-local storage),将数据存储在poolLocal中,每个P都有自己的数据,可以大大减少竞争。

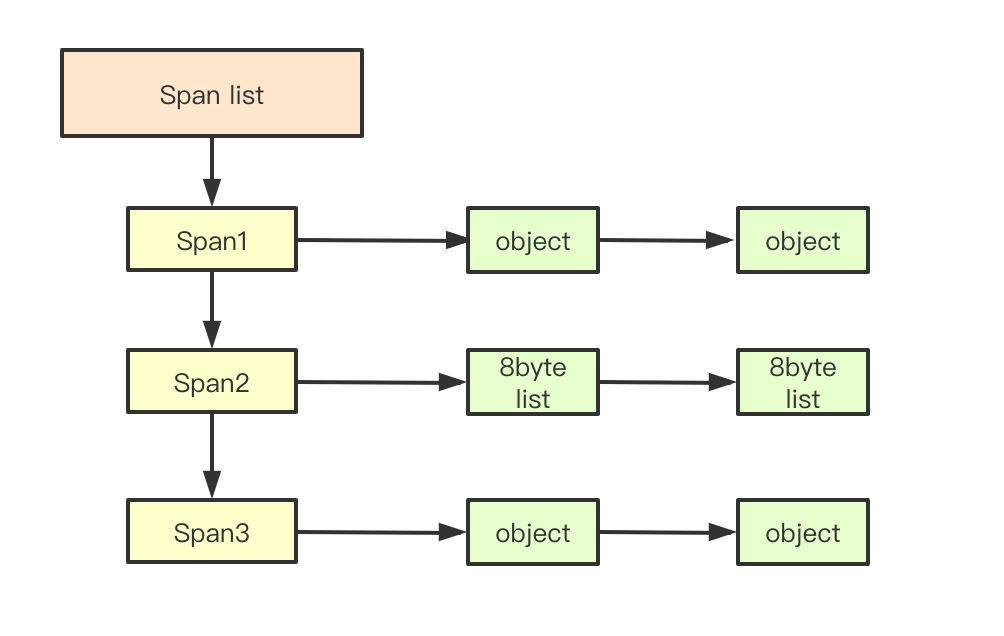

去看下risterio里面的代码实现,sync.Pool是在ringBuffer里定义的。其中核心**就是当ringbuffer满了之后再去统计LFU里面的一些metrics信息。

type ringBuffer struct {

pool *sync.Pool

}

// Push adds an element to one of the internal stripes and possibly drains if

// the stripe becomes full.

func (b *ringBuffer) Push(item uint64) {

// Reuse or create a new stripe.

stripe := b.pool.Get().(*ringStripe)

stripe.Push(item)

b.pool.Put(stripe)

}stripe会先把数据写入到s.data里面,这个操作是无锁的。当目前的data数据超过cap之后会让ringConsumer 去进行消费。

func (s *ringStripe) Push(item uint64) {

s.data = append(s.data, item)

// Decide if the ring buffer should be drained.

if len(s.data) >= s.capa {

// Send elements to consumer and create a new ring stripe.

if s.cons.Push(s.data) {

s.data = make([]uint64, 0, s.capa)

} else {

s.data = s.data[:0]

}

}

}上面的代码关键点就在于每次操作前都是从pool里面拿到的ringStripe对象,所以就无需进行加锁操作,在还回pool之前就不会有并发的一些问题,这也是比较巧妙的一点。

后续的操作因为已经没有pool来保证并发,所以在processItem的时候还是需要lock来进行并发保护的。

func (p *defaultPolicy) processItems() {

for {

select {

case items := <-p.itemsCh:

p.Lock()

p.admit.Push(items)

p.Unlock()

case <-p.stop:

return

}

}

}memory bouding

过期策略

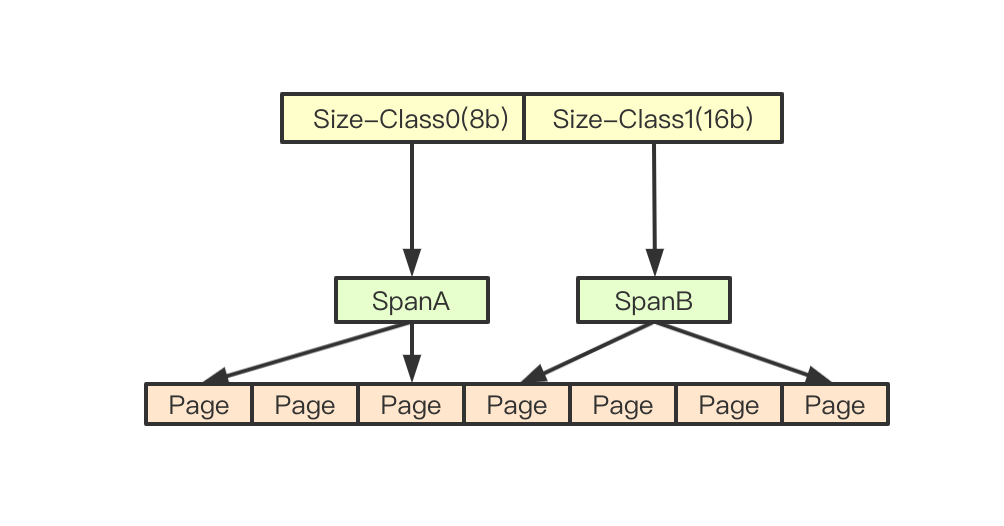

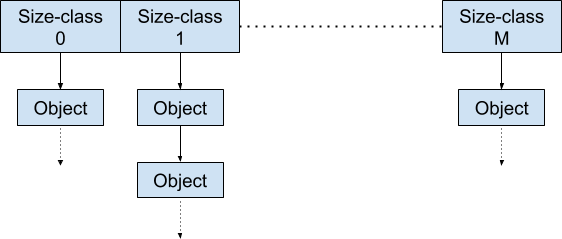

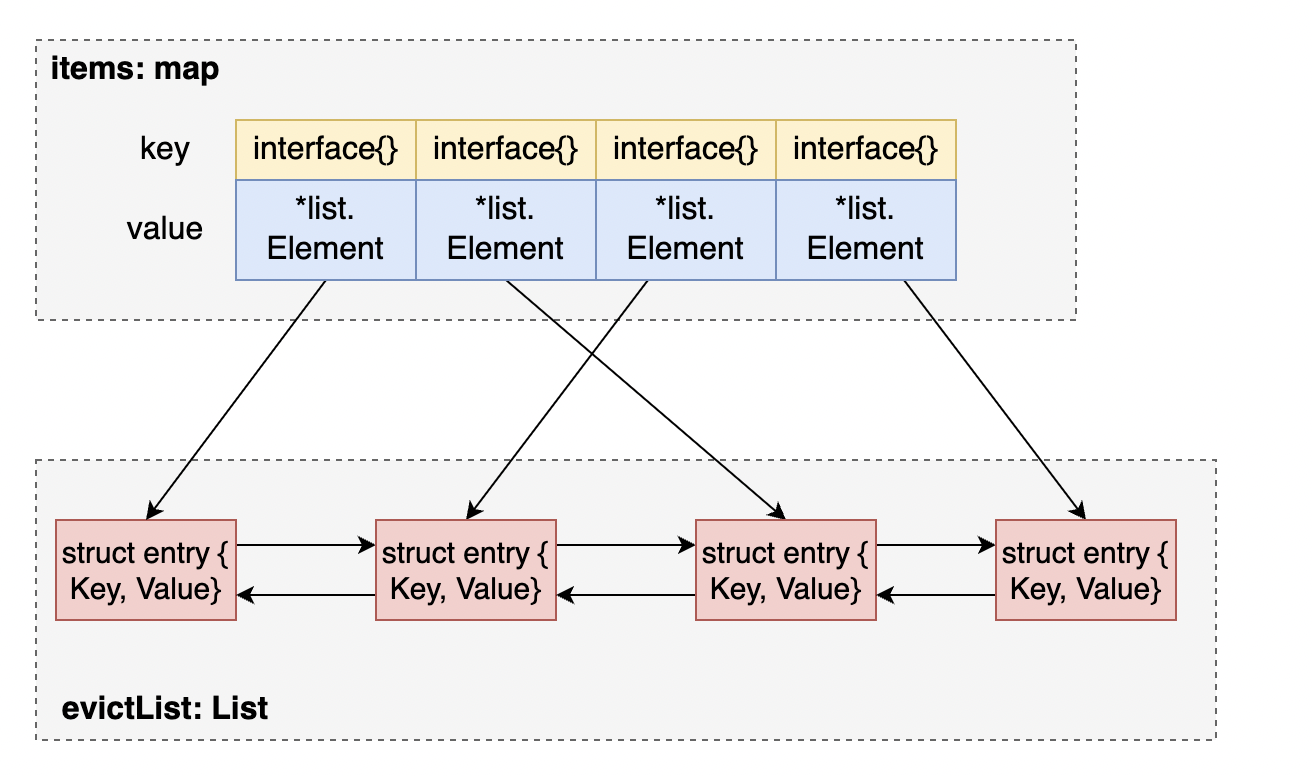

risterio的内存管理方式不同于freecache等其他缓存库,它引入了一个"cost"概念。每次调用set函数时,会为每个key附加一个cost值,通过计算maxCost来控制整个缓存中存储的key数量。与其他库根据key的使用量来决定哪些key需要被删除不同,risterio使用cost作为标准来管理内存。

LRU(Least Recently Used), 算法根据数据的访问时间来决定其生命周期,最近访问的存活时间越长。然而,这种算法的缺点也很明显,即短时间内有大量的冷数据访问时,会刷掉热数据,导致缓存的命中率下降。以golang里面的LRU cache实现来讲的话,一般都是基于map以及linkedlist来实现的。这样GET和SET的时间复杂度都可以到O(1)。

LFU(Least Frequently Used)是根据数据访问的频率来决定key是否会被缓存在cache里面,访问频率越高的key生命周期越长。相比于LRU,LFU的缓存命中率一般情况下会更好,但是在突发流量的情况下表现不佳,因为它是根据访问频率来决定的。此外,LFU的实现相对复杂,需要考虑如何精确统计每个key的访问频率以及如何控制cache中的key数量。

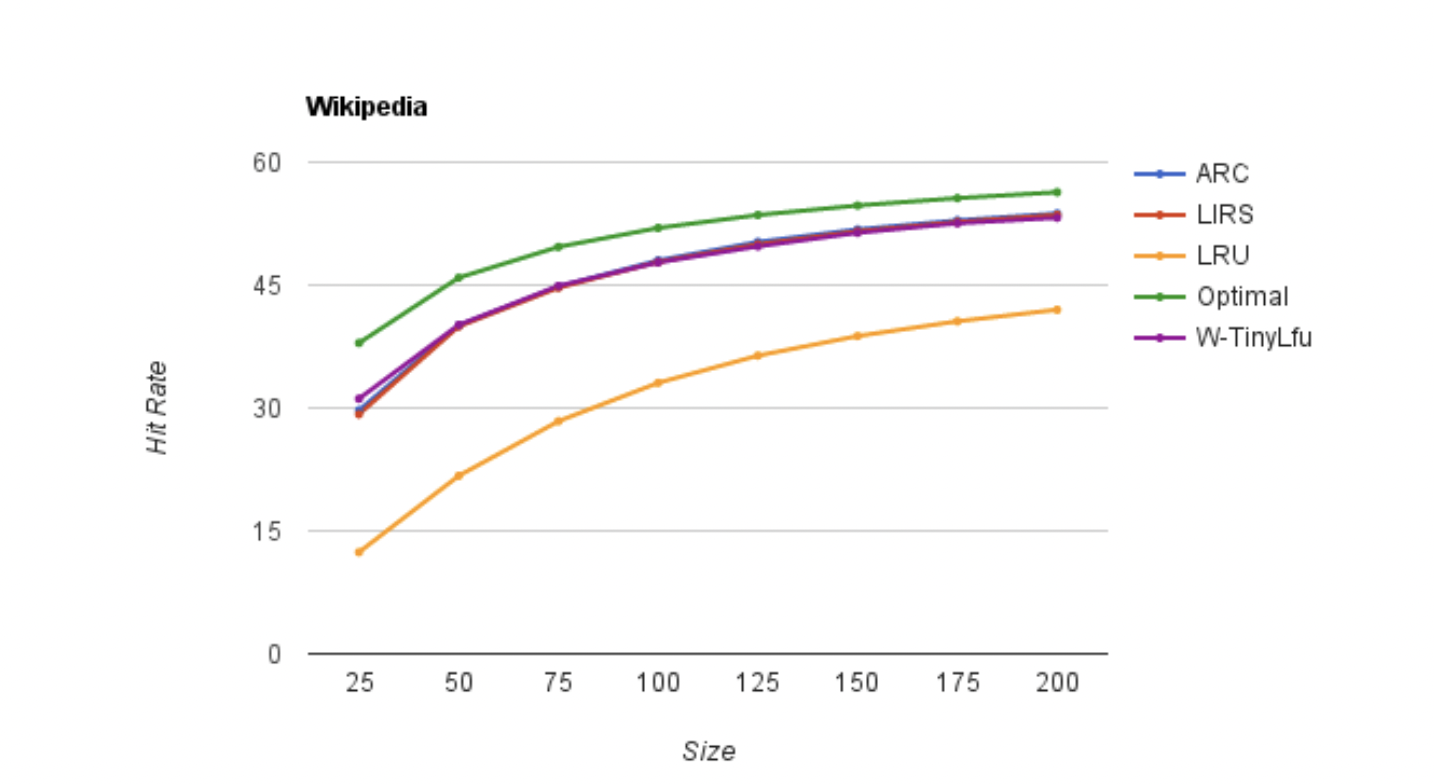

risterio 里面使用tinyLFU还是受到了Caffeine的影响,TinyLFU是一种适用于大型数据库的高效缓存淘汰策略,它通过维护最近访问的项目的访问频率的近似表示来实现。相比之下,LRU和LFU是两种传统的缓存淘汰策略。LRU会优先淘汰最近最少使用的项目,而LFU会优先淘汰最不经常使用的项目。TinyLFU基于Count-Min Sketch策略并且可以在非常小的内存开销下实现高效率的统计,命中率也十分可观。

Count-Min sketch的**来自于bloomfilter,通过hash后的key来映射到位图上,在尽可能少的使用内存的情况下去进行过滤。但是在发生hash冲突的时候,可能不同的key会出现在位图的同一个位置,这就是为什么bloomfilter里面无法准确判断key是否存在(false postive)。

在Count-Min Sketch中,对于每一个值,写入时用n个独立的hash函数映射到每一行的一列中。每个位置上存储一个计数器,用于记录该位置上已经被映射到的元素的频率count。

查询时取最小的count作为element出现的次数,故名count-min。为了降低Count-Min Sketch表格的空间占用,TinyLFU会定期将Count-Min Sketch中的计数器减半。

+-----+-----+-----+-----+-----+-----+-----+

|key 0|key 1|key 2|key 3|key 4|key 5|key 6|

+---+-----+-----+-----+-----+-----+-----+-----+

| | | | | | | | |

|h0 | 0 | 0 | 0 | 0 | 0 | 0 | 0 |

| | | | | | | | |

+---+-----+-----+-----+-----+-----+-----+-----+

| | | | | | | | |

|h1 | 0 | 0 | 0 | 0 | 0 | 0 | 0 |

| | | | | | | | |

+---+-----+-----+-----+-----+-----+-----+-----+

| | | | | | | | |

|h2 | 0 | 0 | 0 | 0 | 0 | 0 | 0 |

| | | | | | | | |

+---+-----+-----+-----+-----+-----+-----+-----+

| | | | | | | | |

|h3 | 0 | 0 | 0 | 0 | 0 | 0 | 0 |

| | | | | | | | |

+---+-----+-----+-----+-----+-----+-----+-----+

除了上面的CM-Sketch, tinyLFU 前面还加了一层bloomFilter可以用来提高缓存命中率以及误判率。

type tinyLFU struct {

freq *cmSketch

door *z.Bloom

incrs int64

resetAt int64

}cmSketch以及Bloomfilter具体实现的代码就不展示,整个tinyLFU的实现还是比较好理解的。写入的时候由于是batch写,所以对外提供的接口是Push,另外查询的时候因为不是准确的频率,所以是p.freq.Estimate。

func (p *tinyLFU) Push(keys []uint64) {

for _, key := range keys {

p.Increment(key)

}

}

func (p *tinyLFU) Estimate(key uint64) int64 {

hits := p.freq.Estimate(key)

if p.door.Has(key) {

hits++

}

return hits

}还有个tinyLFU有意思的点就是当counter计数到一定的数量时,会去将counter里面的数目减半,进而减少记录访问频率的开支。

func (p *tinyLFU) Increment(key uint64) {

// Flip doorkeeper bit if not already done.

if added := p.door.AddIfNotHas(key); !added {

// Increment count-min counter if doorkeeper bit is already set.

p.freq.Increment(key)

}

p.incrs++

if p.incrs >= p.resetAt {

p.reset()

}

}

func (r cmRow) reset() {

// Halve each counter.

for i := range r {

r[i] = (r[i] >> 1) & 0x77

}

}时间片管理TTL

TTL的管理在risterio里的实现也比较简单,基于时间戳来划分不同的桶,定期回收过期的桶。

以5秒为一个时间片,数据结构是map[bucketNum]keys,每间隔2.5秒就会循环清理一次所有的桶。时间片的计算是基于Unix时间戳,使用time.Now()/5 + 1来定位到对应的时间片。

func storageBucket(t time.Time) int64 {

return (t.Unix() / bucketDurationSecs) + 1

}clean的tick到了后会去清除上一轮已经过期掉的的时间片, 新的写入操作只会写入当前5s的时间片。

这点设计跟kafka里的时间轮有点不一样,kafka的时间轮是一个环形的多层时间轮,这里的实现比较简单,就相当于是一个顺序展开的时间片。

其他的一些优化

Hash加速

通过go link直接调用底层的汇编函数,目前是比较快的。

//go:noescape

//go:linkname memhash runtime.memhash

func memhash(p unsafe.Pointer, h, s uintptr) uintptrMap分片,减少锁力度

这个优化手段比较常见了,通过声明多个map,每个map单独持有锁进而减少锁的粒度

type shardedMap struct {

shards []*lockedMap

expiryMap *expirationMap

}atomic padding

在高并发场景下,多个goroutine同时访问共享变量可能会导致false sharing的问题,即一个goroutine修改了共享变量的一部分,导致其他goroutine需要重新加载整个变量的情况,从而影响性能。

padding是在结构体中添加一些无用的字段,使得不同的字段位于不同的cache line中,从而避免了false sharing的问题。

atomic计数器在多核情况下的false sharing可通过padding解决。

valp := p.all[t]

// Avoid false sharing by padding at least 64 bytes of space between two

// atomic counters which would be incremented.

idx := (hash % 25) * 10

atomic.AddUint64(valp[idx], delta)Ref

分布式ID

分布式ID

BackGround

分布式ID在许多场景都是十分有用的,比如分布式数据库里面的MVCC实现(需要单调递增性), 比如支付场景的支付ID(需要唯一性)。一个高可用的分布式ID必须满足以下几个特征:

- 唯一性

- 单调递增

- 高可用

业内常见的解决方案可以参考如下几种解决方案:

UUID

UUID是一种比较常见的解决方案,全称Universally Unique Identifier,是由一组32位数的16进制数字所构成, 比如550e8400-e29b-41d4-a716-446655440000。大多数标准库都集成了UUID算法。常用的版本有以下5种:

- 版本1 - UUID 是根据时间和节点 ID(通常是MAC地址)生成;

- 版本2 - UUID是根据标识符(通常是组或用户ID)、时间和节点ID生成;

- 版本3、版本5 - 确定性UUID 通过散列(hashing)名字空间(namespace)标识符和名称生成;

- 版本4 - UUID 使用随机性或伪随机性生成。

通常情况下如果只是需要一个随机的ID,可以选择1或者4版本,1版本的可读性更强一点,4是完全基于随机数生成的,大多数情况下我们用到的都是基于版本1的实现。

如果需要指定名称每次生成相同的UUID则可以考虑版本3或者5,两者的不同是一个基于MD5 hash,一个基于SHA-1 hash。

使用也比较简单,用golang的satori/go.uuid这个库作为例子,可以很方便的得到一个UUID。

package main

import (

"fmt"

"github.com/satori/go.uuid"

)

func main() {

u1 := uuid.Must(uuid.NewV4())

fmt.Printf("UUIDv4: %s\n", u1)

}优点:

- 生成简单,大多数语言都有基础库集成,没有网络调用消耗

缺点;

- 字符串占据空间较大

- 无序字符串

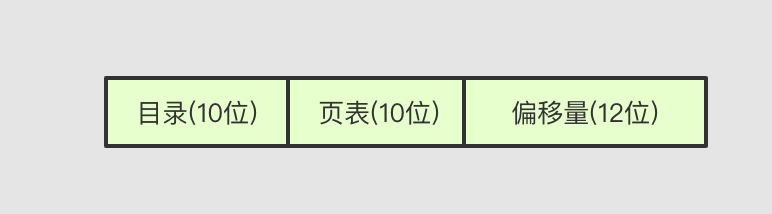

雪花算法Snowflake

雪花算法将64bit的整数按位划分

+--------------------------------------------------------------------------+

| 1 Bit Unused | 41 Bit Timestamp | 10 Bit NodeID | 12 Bit Sequence ID |

+--------------------------------------------------------------------------+

- 1 Bit 保留位

- 41 Bit 时间戳,毫秒级别。

- 10 Bit 机器ID

- 12 Bit 序列号,用来记录同毫秒内产生的不同id。12位序列号表示每毫秒能产生4096个ID,如果超过此范围,需要等到下一个毫秒。

Golang中可以使用bwmarrin/snowflake来生成ID,整个代码也十分简单,指定唯一的机器ID即可。

package main

import (

"fmt"

"github.com/bwmarrin/snowflake"

)

func main() {

// Create a new Node with a Node number of 1

node, err := snowflake.NewNode(1)

if err != nil {

fmt.Println(err)

return

}

// Generate a snowflake ID.

id := node.Generate()

// Print out the ID in a few different ways.

fmt.Printf("Int64 ID: %d\n", id)

}优点:

- 序列自增

- 生成容易,不依赖外部存储,没有网络调用消耗

- Bit位调整灵活,可以适用于不同的场景

缺点:

- 强依赖系统时钟,可能会有时钟回拨的问题发生

数据库主键

Mysql

可以基于Mysql生成自增ID,每次需要相应ID的时候直接Insert一条语句即可。

CREATE TABLE `t` (

`id` int(11) NOT NULL AUTO_INCREMENT,

`c` int(11) DEFAULT NULL,

PRIMARY KEY (`id`)

) ENGINE=InnoDB;

插入一条数据然后取出ID即可,需要额外注意的是Mysql并不能保证自增ID的连续性(事务失败或者回滚/自增锁的设置级别)。

insert into t values(null, 1);

SELECT LAST_INSERT_ID();

上面是一个典型的语句,每次生成之后需要再select取一下,有时候会对Mysql压力比较大。

idgo是一个基于Redis和Mysql的批号ID生成器, 每次取都是基于offset取出一批数据。具体可以参考实现

优点:

- 集成简单

- 数据递增

缺点:

- 引用了数据库依赖,需要一次调用

- 性能吞吐取决于Mysql

Etcd/Zookeeper

由于Etcd和Zookeeper是线性一致性的数据库,里面的ID不依赖同步时钟,没有时钟回拨的问题。

以Etcd举例,只考虑最简单的场景:每次从Etcd GET完之后在本地将value自增然后放回Etcd。

func generateID() uint64{

value, _ := etcdutil.GetValue(client, key)

current := util.BytesToUint64(value)

current += 1

_, err := etcdutil.PutValue(client, key, value)

if err != nil {

return 0

}

return value

}上面的代码跑跑demo可以用,但是在实际生产环境中会有几个问题:

1.每次Allocate都需要进行两次Etcd操作(Get/Put), 流量大了之后对Etcd的压力是十分恐怖的。

2.在高并发的情况下,我们无法保证我们Put进去的值是最新的,可能会出现ID覆盖的问题,这时候就需要用到Etcd原生的事务。

解决上面问题1的方法是每次Get时候使用号段模式,在提交的时候预分配1000个ID,使用完了再去Etcd里面Get和Put。问题2使用Etcd原生的Txn可以解决。

下面是简单的代码示例:

const (

step = 1000

)

var base, end uint64

func getID() uint64 {

// 号段用完,去generate一批

if base == end {

res := generateID()

// got error

if res == 0 {

return 0

}

end = res

base = end - step

}

base ++

return base

}

func generateID() uint64{

value, _ := etcdutil.GetValue(client, key)

current := util.BytesToUint64(value)

current += step

cmp = clientv3.Compare(clientv3.Value(key), "=", string(value))

client.Txn(context.Background()).If(cmp).Then(clientv3.OpPut(key, string(current))).Commit()

if err != nil {

return 0, err

}

if !resp.Succeeded {

return 0

}

return value

}优点:

- value格式支持自定义

- 数据有序

- 没有时钟拨回的隐患

缺点

- 引用了数据库依赖,需要一次调用

- 性能瓶颈以及可用性会依赖Etcd

主流开源方案

-

美团leaf

美团leaf支持两种模式:号段模式以及snowFlake模式。

在原生的号段模式上,leaf是采用双buffer优化去做的,相较于上面的实现,leaf每次在号段使用超过10%的时候就会去异步的申请一段号(异步更新)。 -

百度UidGenerator

UidGenerator 是 Java 实现的, 基于 Snowflake 算法的唯一 ID 生成器。Cache的实现是借用未来时间实现的RingBuffer。

时钟拨回问题

传统的snowFlake无法避免时钟回拨问题,常用的解决方案

- 服务端等待一段时间再比较时间

- 直接抛出异常,由客户端进行重试

- 消费未来时间位(利用cache)

- 使用 1~2台关闭NTP时钟的机器做backup

小结

在实际的生产环境中,需要使用哪种分布式ID方案都需要根据实际场景来决定。Snowflake算法可以满足大部分的场景,如果服务本身已经依赖了一些外部数据库不妨可以使用这些数据库来做分布式ID。如果要考虑做一个中间件的话,上面的开源方案都是一些很好的参考。

reference

- https://asktug.com/t/topic/1521

- https://zh.wikipedia.org/wiki/%E9%80%9A%E7%94%A8%E5%94%AF%E4%B8%80%E8%AF%86%E5%88%AB%E7%A0%81https://zh.wikipedia.org/wiki/%E9%80%9A%E7%94%A8%E5%94%AF%E4%B8%80%E8%AF%86%E5%88%AB%E7%A0%81

- https://tech.meituan.com/2017/04/21/mt-leaf.html

- https://github.com/baidu/uid-generator/blob/master/README.zh_cn.md

IOLoop分析

IOLoop

函数说明

__init__

- IOLoop.READ:Available for read

- IOLOOP.WRITE: Available for write

- IOLoop.ERROE: Error condition happened on the assoc. fd

IOLoop声明的时候有三种状态:READ, WRITE, ERROR。

_impl 根据操作系统有三种不同的支持方式,linux2.5.44以上支持epoll,free bsd和mac支持kqueue,windows支持select。__impl_在这里是对事件机制的一个封装,_register_注册事件,_modify_修改事件,_unregister_销毁事件,_poll_轮询事件.

初始化实例的时候添加一个__read_waker_,伪造一次IO事件,这样做的好处是以便事件循环阻塞而没有相应描述符出现,需要在最大timeout时间之前返回,就可以向这个管道发送一个字符,用来终止阻塞在监听阶段的事件循环监听函数。

instance

任意的一条线程共享IOLoop对象

add_handler

_self._handlers_是一个字典,其中fd作为键, handler作为值。对_self._impl_注册fd和events状态。

update_handler

对事件状态进行更新,调用_self.impl.modify

start

一个while循环,将_self._callbacks_里边的callback遍历执行,执行完callback再进行下一次的事件迭代。通过_self._impl.poll_取出事件和相应的handler,执行该事件。

stop

通过_self._read_waker_将_self._stopped_设置为False, 终止while循环。

通过test case 进行流程分析

#!/usr/bin/env python

import unittest

import time

from tornado import ioloop

class TestIOLoop(unittest.TestCase):

def setUp(self):

self.loop = ioloop.IOLoop()

def tearDown(self):

pass

def _callback(self):

self.called = True

self.loop.stop()

def _schedule_callback(self):

self.loop.add_callback(self._callback)

# Scroll away the time so we can check if we woke up immediately

self._start_time = time.time()

self.called = False

def test_add_callback(self):

self.loop.add_timeout(time.time(), self._schedule_callback)

self.loop.start() # Set some long poll timeout so we can check wakeup

self.assertAlmostEqual(time.time(), self._start_time, places=2)

self.assertTrue(self.called)

if __name__ == "__main__":

import logging

logging.basicConfig(level=logging.DEBUG, format='%(asctime)s:%(msecs)03d %(levelname)-8s %(name)-8s %(message)s', datefmt='%H:%M:%S')

unittest.main()

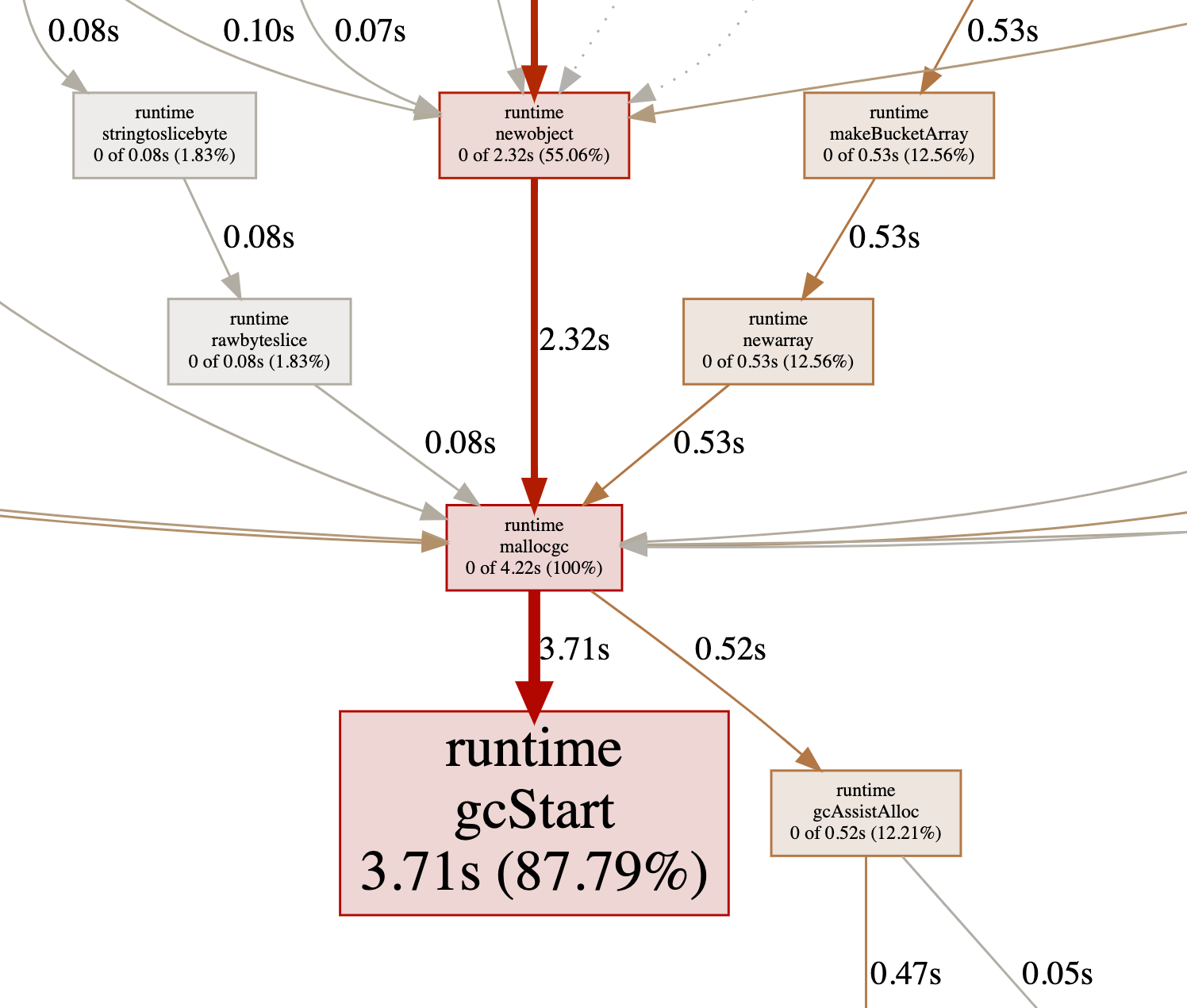

Sync.Pool 源码分析及演进

Sync.Pool 源码分析

定义

A Pool is a set of temporary objects that may be individually saved and

retrieved.

sync.Pool 是一个临时的对象池,对外提供Get和Put的方法。

池化是优化的一种手段,新对象的连续创建和销毁都会给系统带来一定的压力,使用Pool可以有效的优化GC以及减少内存申请开销。

使用

下面写一个简单的例子:

func main() {

p := &sync.Pool{

New: func() interface{} {

// 默认对象,当pool里面没有则返回该默认值

return 0

},

}

// 没有可用对象,返回默认值

a := p.Get().(int)

// Put一个对象进去

p.Put(1)

// 返回值为1

b := p.Get().(int)

}上面的程序逻辑很简单,pool里面有可用对象的时候则返回,没有的话默认调用New方法,并返回。

An example of good use of a Pool is in the fmt package, which maintains a

dynamically-sized store of temporary output buffers. The store scales under

load (when many goroutines are actively printing) and shrinks when

quiescent.

官方的fmt也有在使用sync.Pool, 具体可以看下怎么在使用:

// 初始化pool

var ppFree = sync.Pool{

New: func() interface{} { return new(pp) },

}

type buffer []byte

// pp结构类型,只需关注里面bytes的使用

type pp struct {

buf buffer

arg interface{}

......

}

// newPrinter allocates a new pp struct or grabs a cached one.

func newPrinter() *pp {

// Get 操作

p := ppFree.Get().(*pp)

return p

}

// free saves used pp structs in ppFree; avoids an allocation per invocation.

func (p *pp) free() {

// Proper usage of a sync.Pool requires each entry to have approximately

// the same memory cost. To obtain this property when the stored type

// contains a variably-sized buffer, we add a hard limit on the maximum buffer

// to place back in the pool.

//

// See https://golang.org/issue/23199

if cap(p.buf) > 64<<10 {

return

}

p.buf = p.buf[:0]

p.arg = nil

p.value = reflect.Value{}

ppFree.Put(p)

}这里比较有意思的一个地方是 23199 这个issue。

里面的例子 可以简单总结下,就是pool里面的一个Buffer在Get完之后对其进行一次Grow操作扩大其cap。虽然有很多的空间是没用到的,但是因为Get的操作可能导致之后需要很多个GC cycle才能完全把这部分内存释放掉。所以官方在这里很暴力的加了个64K的大小判断。本质上来说,pool里面的对象都需要差不多大小。

比较优雅的实现可以参考http库里面chunkPools的实现,不同大小的对象使用不同的pool

http2dataChunkPools = [...]sync.Pool{

{New: func() interface{} { return make([]byte, 1<<10) }},

{New: func() interface{} { return make([]byte, 2<<10) }},

{New: func() interface{} { return make([]byte, 4<<10) }},

{New: func() interface{} { return make([]byte, 8<<10) }},

{New: func() interface{} { return make([]byte, 16<<10) }},

}源码分析(基于1.12)

Pool 结构体

// A Pool must not be copied after first use.

type Pool struct {

noCopy noCopy

local unsafe.Pointer // local fixed-size per-P pool, actual type is [P]poolLocal

localSize uintptr // size of the local array

// New optionally specifies a function to generate

// a value when Get would otherwise return nil.

// It may not be changed concurrently with calls to Get.

New func() interface{}

}- noCopy 这里表示的是该对象创建之后,理论上来说不能被其他对象复制,sync里的大多数包都不能被复制(避免指针污染)。这里的实现是实现一个空接口,通过govet来检测。

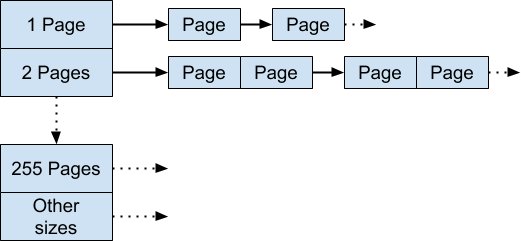

- local 实际上是一个[P]poolLocal的数组,数据类型为指针

- localSize local数组大小

- New 返回对应的数据类型

// Local per-P Pool appendix.

type poolLocalInternal struct {

private interface{} // Can be used only by the respective P.

shared []interface{} // Can be used by any P.

Mutex // Protects shared.

}- private 每个P的对象

- shared 可以给所有P共享的对象列表

- Mutex shared的读取和写入需要加锁(1.13实现了无锁版,后面介绍)

type poolLocal struct {

poolLocalInternal

// Prevents false sharing on widespread platforms with

// 128 mod (cache line size) = 0 .

pad [128 - unsafe.Sizeof(poolLocalInternal{})%128]byte

}- pad 用来防止

false sharing, 大部分的CPU prefetch 的cache line都是64byte,使用128byte整除可以防止多核reload cache line。可以参考24

Get方法

func (p *Pool) Get() interface{} {

if race.Enabled {

race.Disable()

}

l := p.pin()

x := l.private

l.private = nil

runtime_procUnpin()

if x == nil {

l.Lock()

last := len(l.shared) - 1

if last >= 0 {

x = l.shared[last]

l.shared = l.shared[:last]

}

l.Unlock()

if x == nil {

x = p.getSlow()

}

}

if race.Enabled {

race.Enable()

if x != nil {

race.Acquire(poolRaceAddr(x))

}

}

if x == nil && p.New != nil {

x = p.New()

}

return x

}- 忽略race的噪音,分析整个流程,先开始调用pin函数绑定P,具体看下pin函数的执行过程。

- 调用完pin,拿到一个local对象之后,将

l.private赋值为空,解绑P。 - 如果x的对象为空,则会从shared里面去拿出最后一个,然后将shared的长度减一

- 如果shared里面数组也为空,则会去调用

getSlow方法,出现这个场景可能是pool刚初始化或者对象用尽。getSlow这个函数的作用就是从其他P的poolLocal里面拿一个出来。 - 如果上面的流程还是拿不到,会去从默认的New方法里面取出一个新的对象

pin函数流程

func (p *Pool) pin() *poolLocal {

pid := runtime_procPin()

s := atomic.LoadUintptr(&p.localSize) // load-acquire

l := p.local // load-consume

if uintptr(pid) < s {

return indexLocal(l, pid)

}

return p.pinSlow()

}func procPin() int {

_g_ := getg()

mp := _g_.m

mp.locks++

return int(mp.p.ptr().id)

}首先会调用runtime_procPin来将当前的G和一个P进行绑定,因为后续的一些像indexLocal等函数都需要P的ID来进行查找,所以这里需要禁止抢占(preemption)。

s := atomic.LoadUintptr(&p.localSize) 拿到localSize,赋值给s。然后判断pid(0-N), pid的取值范围跟runtime.Maxprocs有关,如果是在local的数组范围内,调用indexLocal 返回一个poolLocal对象。就是根据指针来从list里面下标取值的过程。

func indexLocal(l unsafe.Pointer, i int) *poolLocal {

lp := unsafe.Pointer(uintptr(l) + uintptr(i)*unsafe.Sizeof(poolLocal{}))

return (*poolLocal)(lp)

}当数组不够的时候,再看下最后一个pinSlow方法

func (p *Pool) pinSlow() *poolLocal {

// Retry under the mutex.

// Can not lock the mutex while pinned.

runtime_procUnpin()

allPoolsMu.Lock()

defer allPoolsMu.Unlock()

pid := runtime_procPin()

// poolCleanup won't be called while we are pinned.

s := p.localSize

l := p.local

if uintptr(pid) < s {

return indexLocal(l, pid)

}

if p.local == nil {

allPools = append(allPools, p)

}

// If GOMAXPROCS changes between GCs, we re-allocate the array and lose the old one.

size := runtime.GOMAXPROCS(0)

local := make([]poolLocal, size)

atomic.StorePointer(&p.local, unsafe.Pointer(&local[0])) // store-release

atomic.StoreUintptr(&p.localSize, uintptr(size)) // store-release

return &local[pid]

}pinSlow的流程看起来很有意思,先是unpin掉当前的P,然后对allPoolsMu进行一次加锁,再重新去local

的数组里面拿一次,没有的话就表示是第一次Get或者在GC期间GOMAXPROCS改变了local size,会把当前的p放到一个全局的allPools里面去。

这里加锁创建是因为在并发的环境里面可能会有不同的G去调用pinSlow函数,确保线程安全的情况下,如果一个G成功创建了一个pool,设置了正确的local,另外一个G就需要再去判断一次,然后返回。allPoolsMu是一个全局的大锁,在某些情况下可能会影响性能,在1.13里面已经实现了无锁版,下面会说到如何实现。

Put方法

// Put adds x to the pool.

func (p *Pool) Put(x interface{}) {

if x == nil {

return

}

if race.Enabled {

if fastrand()%4 == 0 {

// Randomly drop x on floor.

return

}

race.ReleaseMerge(poolRaceAddr(x))

race.Disable()

}

l := p.pin()

if l.private == nil {

l.private = x

x = nil

}

runtime_procUnpin()

if x != nil {

l.Lock()

l.shared = append(l.shared, x)

l.Unlock()

}

if race.Enabled {

race.Enable()

}

}忽略race噪音,看Put方法就比较轻松了

- 绑定一个P,拿到对应的poolLocal,给poolLocal的private赋值

- Unpin,然后append对象到shared里面

这里需要理解一下private和shared, 每次Put的时候都会覆盖private, 然后往shared里面追加一个对象。Get的时候会把private重置为nil, 然后shared里面移走一个元素。

clean

上面有Put和Get,另外需要关注的一点就是如何进行clean,可以看代码分析。

func init() {

runtime_registerPoolCleanup(poolCleanup)

}函数在init的时候会去注册一个poolCleanup函数,需要关注下runtime_registerPoolCleanup的实现。具体代码在runtime包里面搜索就可以看到:

func sync_runtime_registerPoolCleanup(f func()) {

poolcleanup = f

}gcStart会在函数里面调用poolcleanup,这就是说每次GC启动的时候都会去清空Pool。

poolCleanup函数很简单,清空allPool里面所有的相关元素,全部设置为nil。

func poolCleanup() {

// This function is called with the world stopped, at the beginning of a garbage collection.

// It must not allocate and probably should not call any runtime functions.

// Defensively zero out everything, 2 reasons:

// 1. To prevent false retention of whole Pools.

// 2. If GC happens while a goroutine works with l.shared in Put/Get,

// it will retain whole Pool. So next cycle memory consumption would be doubled.

for i, p := range allPools {

allPools[i] = nil

for i := 0; i < int(p.localSize); i++ {

l := indexLocal(p.local, i)

l.private = nil

for j := range l.shared {

l.shared[j] = nil

}

l.shared = nil

}

p.local = nil

p.localSize = 0

}

allPools = []*Pool{}

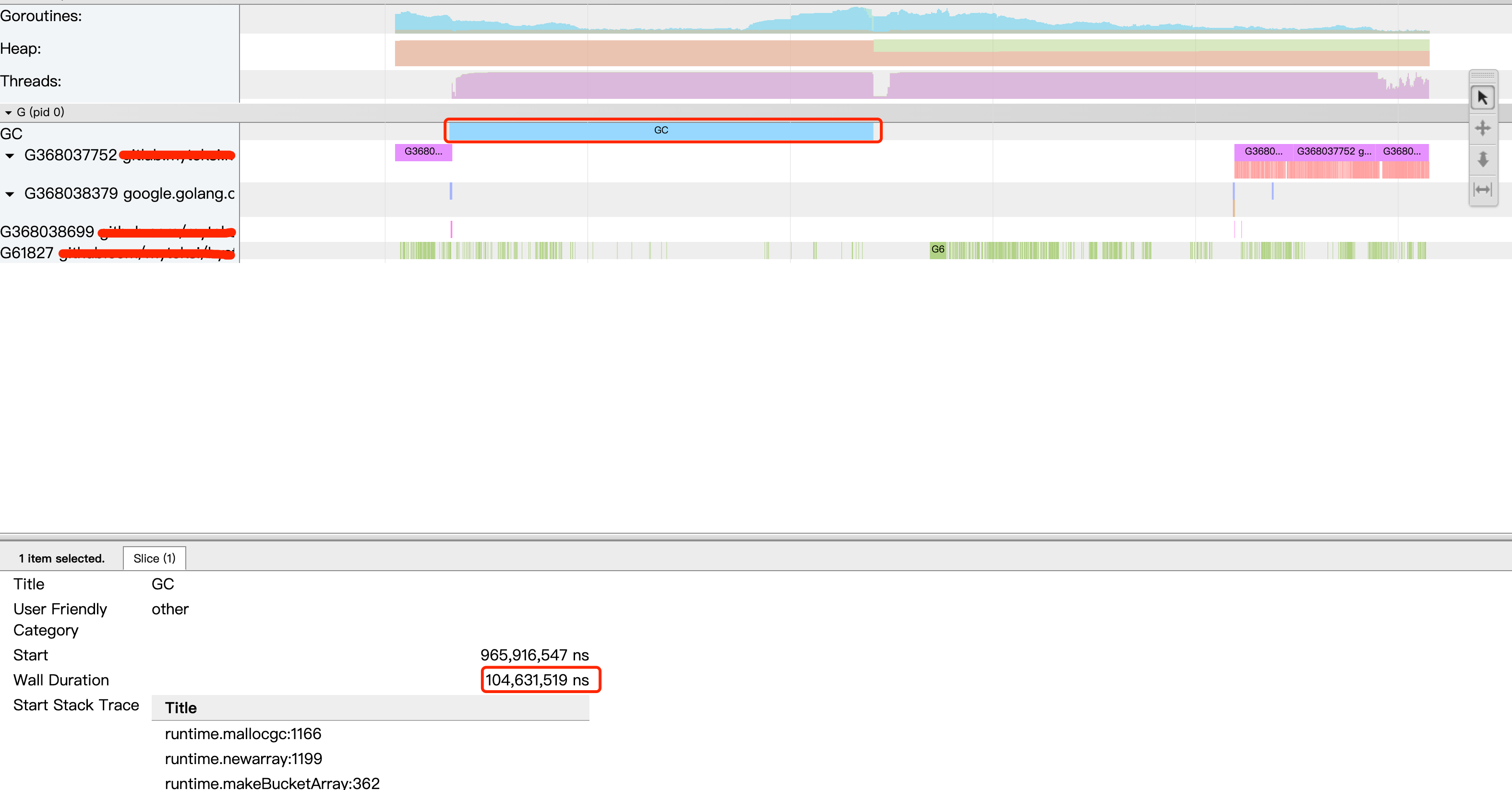

}1.13优化

1.13主要优化的有两个点:

victim cache

所谓受害者缓存(Victim Cache),是一个与直接匹配或低相联缓存并用的、容量很小的全相联缓存。当一个数据块被逐出缓存时,并不直接丢弃,而是暂先进入受害者缓存。如果受害者缓存已满,就替换掉其中一项。当进行缓存标签匹配时,在与索引指向标签匹配的同时,并行查看受害者缓存,如果在受害者缓存发现匹配,就将其此数据块与缓存中的不匹配数据块做交换,同时返回给处理器。 -- 维基百科

在sync.Pool里victim cache的可以定义为次级缓存,每次GC的时候只去删除victim的对象,减少两次GC间Pool冷启动导致的GC抖动,提高Get的命中率。

参照 cleanup的新实现

func poolCleanup() {

for _, p := range oldPools {

p.victim = nil

p.victimSize = 0

}

// Move primary cache to victim cache.

for _, p := range allPools {

p.victim = p.local

p.victimSize = p.localSize

p.local = nil

p.localSize = 0

}

oldPools, allPools = allPools, nil

}每次GC前,都将oldPools重置,allPools里面的内容赋值给oldPools里面的victim(相当于old cache),然后再清空allPools。

Get操作里面会在getSlow里面使用victim cache,说简单点就是当一次GC后,如果Pool里面没有对象可以Get的时候,会从上一次的oldPool里面去拿对象,不会走New再去创建新的对象,如果一次GC后有大量的Get操作,但是Put跟不上,就可以利用oldPool相应的提高命中率,确保一个对象可以活过两个GC。具体可以参考22950这个issue。

locals = p.victim

l := indexLocal(locals, pid)poolChain lock-free structure

去掉了poolLocalInternal 里面的锁。之前锁的作用是在对poolLocal里面的shared进行操作的时候需要加上锁。之前shared字段是一个slice, 在1.13里面变成了poolChain,通过atomic的CompareAndSwapUint64操作来实现无锁。具体可以参考 这次的提交。之前的slice换成了poolDequeue, 里面用atomic实现了一个单生产者多消费者的双向队列,本质上就是利用CPU的CAS原子操作来替换锁。主要的实现代码popHead:

for {

ptrs := atomic.LoadUint64(&d.headTail)

head, tail := d.unpack(ptrs)

if tail == head {

// Queue is empty.

return nil, false

}

// Confirm tail and decrement head. We do this before

// reading the value to take back ownership of this

// slot.

head--

ptrs2 := d.pack(head, tail)

if atomic.CompareAndSwapUint64(&d.headTail, ptrs, ptrs2) {

// We successfully took back slot.

slot = &d.vals[head&uint32(len(d.vals)-1)]

break

}

}本质上就是一个For循环不停的去Get相应的Ptr,然后尝试修改d的指针地址,利用atomic.CompareAndSwapUint64实现CPU的原子操作,成功了就返回,失败了继续for循环,直到成功。

小结

其实从1.12到1.13的pool的优化我们就可以看到一次完整的性能优化,包括去锁和优化GC,多看看release note还是有好处的。几个需要注意的点:

- sync.Pool使用时最好可以根据大小划分不同的Pool

- 如果有优化Mutex的需求,可以考虑使用CAS

- victim cache延长对象的生命周期,提高命中率

- CPU false sharing在一些极度注重性能的地方还是能用就用

参考

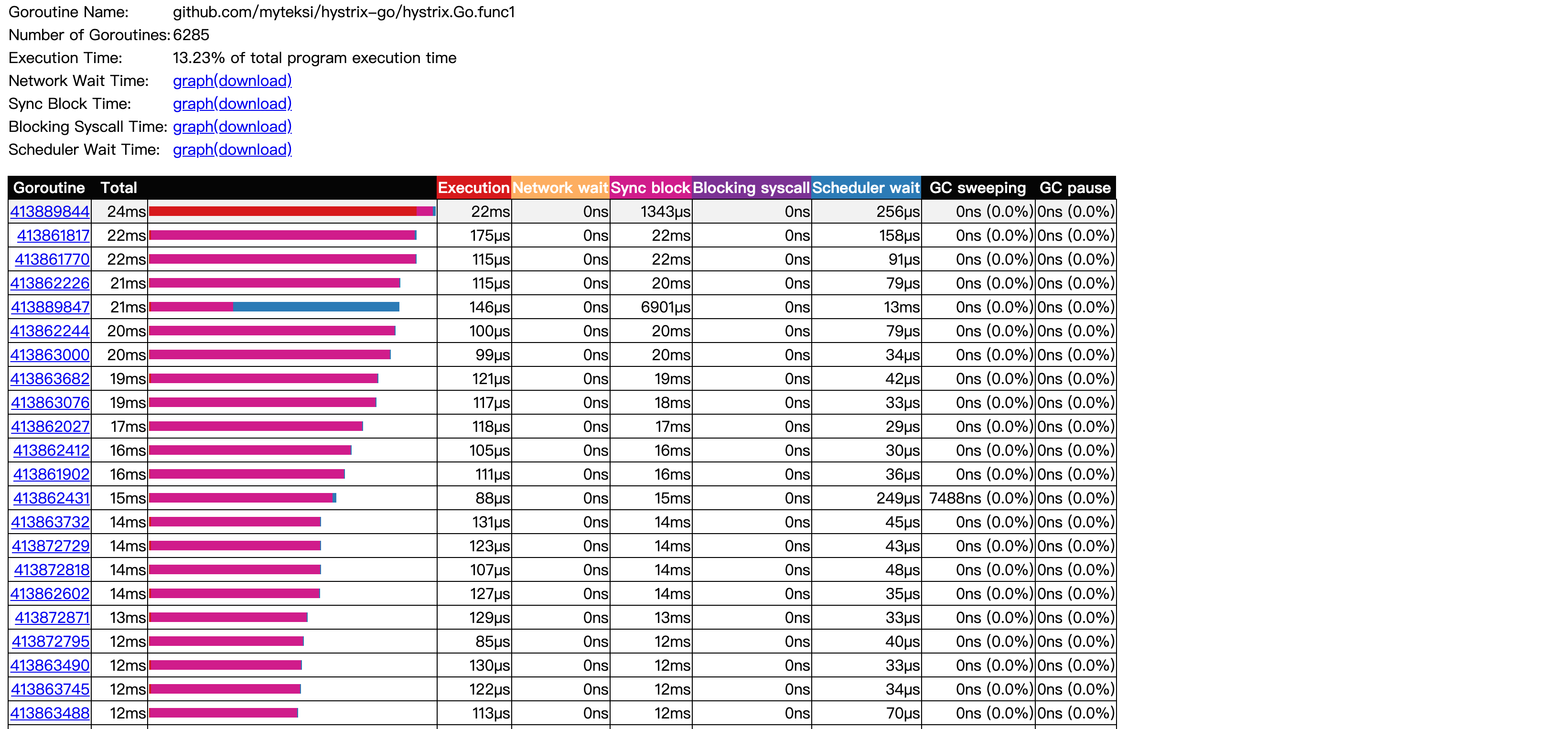

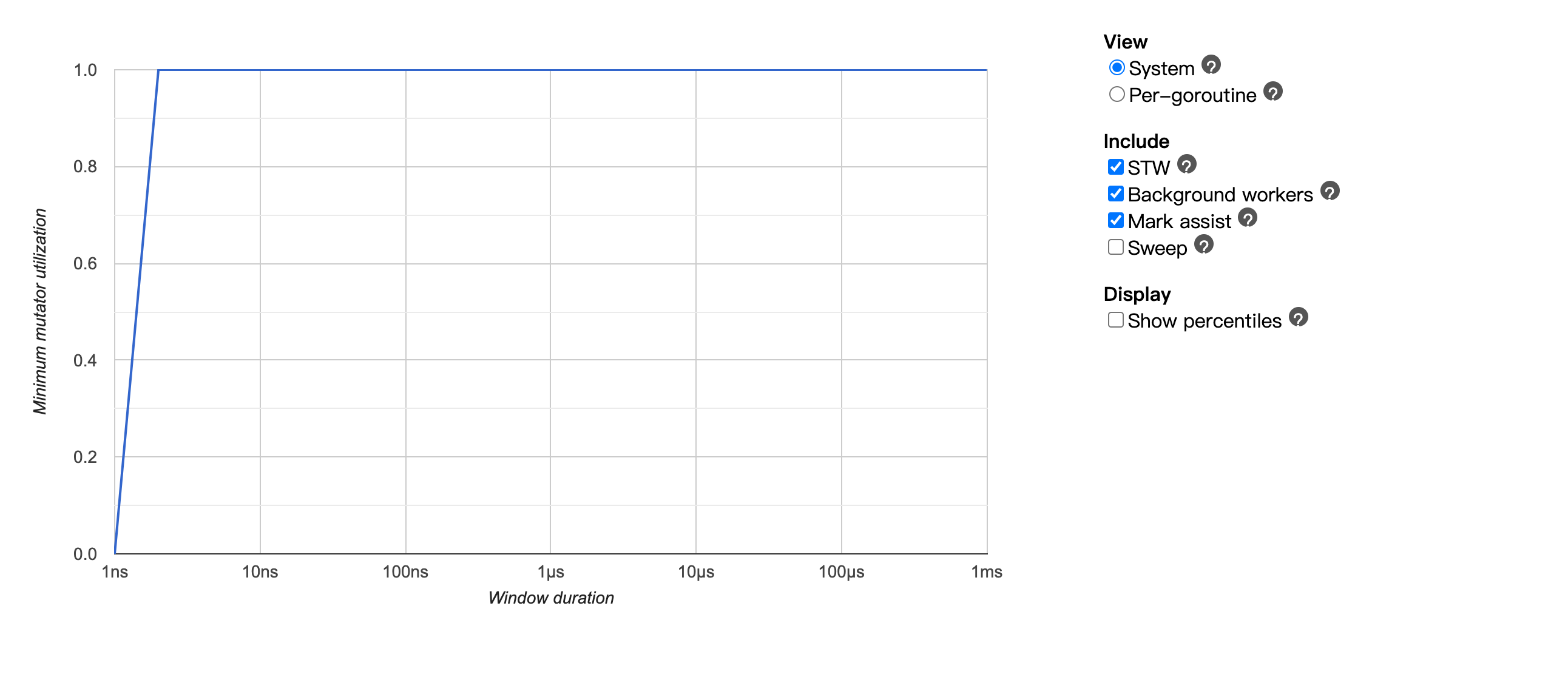

Hystrix Go相关

微服务熔断与隔离

什么是微服务熔断与隔离

微服务熔断(circuit breaker) 可以理解为是一个保护自身服务以及其调用服务的开关。假设我们服务需要调用一个外部服务B,当B不可用的时候如果我们没有这个熔断器,请求本身还会一直打到B,相应自身系统的latency也会增加,从而造成整体服务的不可用,产生雪崩效应。如果加入了熔断机制,这时候有一个可靠的fallback,牺牲系统的部分准确性可以换来整体的可用性提高。

一些更加详细的介绍可以参考。

Hystrix

Circuit breaker的实现有很多种,主流的解决方案大多都是基于Netflix的 Hystrix 来做的。 下面是Hystrix的概念图

一些概念

-

HystrixCommand 和 HystrixObservableCommand:这是Java里面的函数,理解起来就是一个同步一个异步,对应, hystrix.Do 和 hystrix.Go 。

-

Circuit Open, Half Open 以及 close:一个正常的Hystrix 状态有三种,当服务正常运行的时候是close。当服务的错误率到达指定的时候就 Open。当Open之后过去一段时间,Hystrix 会让单独的request通过,测服务是否恢复,这个时候就叫做Half open。

-

Hystrix cache:hystrix 支持将命令的返回结果cache住,但是在Golang的Hystrix官方库并没有支持。

-

FallBack: 当circuit breaker Open之后,或者其他错误发生(queue或者Pool满了),这个时候就可以使用Fallback来兜底这些错误逻辑,fallback还是很有用的。

实现原理

这里以Golang的版本来作为参考,实现起来应该是有几个要点需要注意的: 最大并发的控制(queue实现),同步实现(hystrix.Do),异步实现(Hystrix.Go)。

代码实现并不复杂,先看 Hystrix.Go 的实现,简化的代码如下

go func() {

case cmd.ticket = <-circuit.executorPool.Tickets:

ticketChecked = true

ticketCond.Signal()

cmd.Unlock()

default:

ticketChecked = true

ticketCond.Signal()

cmd.Unlock()

returnOnce.Do(func() {

returnTicket()

cmd.errorWithFallback(ctx, ErrMaxConcurrency)

reportAllEvent()

})

return

}

runStart := time.Now()

runErr := run(ctx)

returnOnce.Do(func() {

defer reportAllEvent()

cmd.runDuration = time.Since(runStart)

returnTicket()

if runErr != nil {

cmd.errorWithFallback(ctx, runErr)

return

}

cmd.reportEvent("success")

})

}()

go func() {

timer := time.NewTimer(getSettings(name).Timeout)

defer timer.Stop()

select {

case <-cmd.finished:

// returnOnce has been executed in another goroutine

case <-ctx.Done():

returnOnce.Do(func() {

returnTicket()

cmd.errorWithFallback(ctx, ctx.Err())

reportAllEvent()

})

return

case <-timer.C:

returnOnce.Do(func() {

returnTicket()

cmd.errorWithFallback(ctx, ErrTimeout)

reportAllEvent()

})

return

}

}()先判断cb状态是否允许请求,然后再尝试从ticketPool里面去拿一个ticket执行对应的命令,执行完就放回ticket。另外一个goroutine用来控制前一个goroutine的生命周期(判断是否超时,ctx结束等)。

Hystrix.Do 的方法较为简单,只有一些简单的逻辑判断就不贴代码了。

Pool的实现很简练,就是一个buffered channel,完整逻辑如下.

package hystrix

type executorPool struct {

Name string

Metrics *poolMetrics

Max int

Tickets chan *struct{}

}

func newExecutorPool(name string) *executorPool {

p := &executorPool{}

p.Name = name

p.Metrics = newPoolMetrics(name)

p.Max = getSettings(name).MaxConcurrentRequests

p.Tickets = make(chan *struct{}, p.Max)

for i := 0; i < p.Max; i++ {

p.Tickets <- &struct{}{}

}

return p

}

func (p *executorPool) Return(ticket *struct{}) {

if ticket == nil {

return

}

p.Metrics.Updates <- poolMetricsUpdate{

activeCount: p.ActiveCount(),

}

p.Tickets <- ticket

}

func (p *executorPool) ActiveCount() int {

return p.Max - len(p.Tickets)

}其他的像包括错误率统计以及allowSingleTest等逻辑,具体可以参考源代码,实现的都不复杂。

小结

基于Hystrix 的circuit breaker功能还是十分强大的,但是需要注意的是每一个请求都会额外产生两个goroutine, 统计错误率等一系列的方法也是比较吃CPU的,当服务对于性能要求较高的时候酌情使用。

在使用cb的时候也需要考虑到 goroutine的生命周期,合理利用Ctx去释放掉相应的资源,不然是会很容易造成goroutine leakd的。

Pyhton 装饰器和闭包

Pyhton 装饰器和闭包

闭包(closure)

了解闭包就先得了解nested function, 所谓嵌套函数从字面上就可以理解,一个简单例子。往简单了说就是返回一个函数,然后再去调用这个函数。

def print_msg(msg):

"""This is the outer enclosing function"""

def printer():

"""This is the nested function"""

print(msg)

return printer # this got changed

# Now let's try calling this function.

# Output: Hello

another = print_msg("Hello")

print another

another()

output

<function printer at 0x10bd9b758>

Hello

使用时有几个注意事项:

- 必须要有一个嵌套函数

- 嵌套函数里边必须要与其封闭函数中的一个变量相关联(否则闭包就没有意义了)

- 封闭函数需要返回嵌套函数

再来一个带参数的例子

def make_inc(x):

def inc(y):

# x is "closed" in the definition of inc

return y + x

return inc

make_3 = make_inc(3)

make_4 = make_inc(4)

print make_3(1)

print make_4(1)

output

4

5

装饰器(decorator)

装饰器说白了就是把一个函数当成参数传到嵌套函数里边去,举个简单的例子

def my_decorator(some_function):

def wrapper():

num = 10

if num == 10:

print("Yes!")

else:

print("No!")

some_function()

print("Something is happening after some_function() is called.")

return wrapper

def just_some_function():

print("Wheee!")

just_some_function = my_decorator(just_some_function)

just_some_function()

output

Yes!

Wheee!

Something is happening after some_function() is called.

当然,Pyhton里边有个语法糖,也可以这么写

def my_decorator(some_function):

def wrapper():

num = 10

if num == 10:

print("Yes!")

else:

print("No!")

some_function()

print("Something is happening after some_function() is called.")

return wrapper

@my_decorator

def just_some_function():

print("Wheee!")

just_some_function()

output

Yes!

Wheee!

Something is happening after some_function() is called.

可以看到输出的结果是一样的。

再来看一看常用的functools.wraps, 还是用上面的例子来测试

def my_decorator(some_function):

def wrapper():

num = 10

if num == 10:

print("Yes!")

else:

print("No!")

some_function()

print("Something is happening after some_function() is called.")

return wrapper

@my_decorator

def just_some_function():

print("Wheee!")

just_some_function()

print just_some_function.__name__

output

Yes!

Wheee!

Something is happening after some_function() is called.

wrapper

可以看到,当我门调用just_some_function时,其函数名称改变了,因为我门在调用时相当于做了这么个转换

just_some_function = my_decorator(just_some_function)

要想保留原始的函数信息需要用到functools.wraps

def my_decorator(some_function):

import functools

@functools.wraps(some_function)

def wrapper():

num = 10

if num == 10:

print("Yes!")

else:

print("No!")

some_function()

print("Something is happening after some_function() is called.")

return wrapper

@my_decorator

def just_some_function():

print("Wheee!")

just_some_function()

print just_some_function.__name__

output

Yes!

Wheee!

Something is happening after some_function() is called.

wrapper

functools.wraps具体信息可参考so

装饰器叠加:

def my_decorator(some_function):

@functools.wraps(some_function)

def wrapper(num):

print("calling my_decorator")

return some_function(num)

return wrapper

def another_decorator(some_function):

@functools.wraps(some_function)

def wrapper(num):

print("calling another_decorator")

return some_function(num)

return wrapper

@my_decorator

@another_decorator

def just_some_function(num):

return num * 2

print just_some_function(1)

output

calling my_decorator

calling another_decorator

2

分布式锁

分布式锁

Background

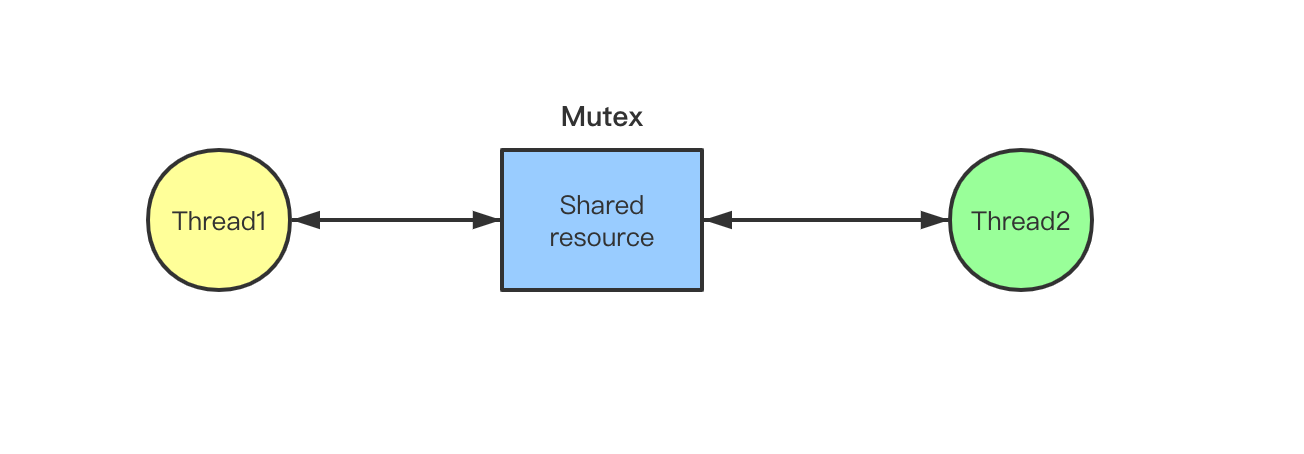

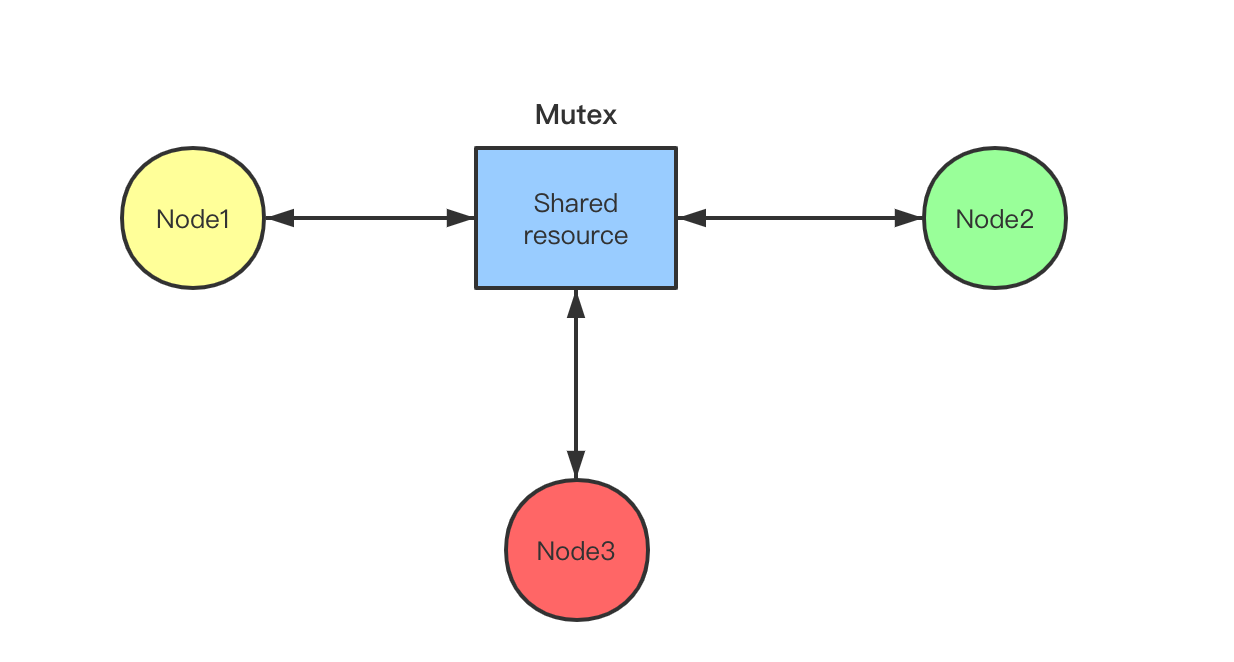

单机锁:

在单一的场景下,锁很好理解,用Golang里面的互斥锁举例:确保在同一时刻只有一个线程可以修改当前的资源。简单的代码示例可以查看 https://play.golang.org/p/7L8oJihNE1G

分布式锁:

当在一个集群里面我们希望在任一时刻只有一台机器可以访问某个共享资源。与单机锁的最大区别就是锁的粒度已经不在一台机器上了,这个时候我们需要引入外部的资源来帮我们解决这个问题了。

CAP理论:

- Consistency: 一致性(强一致性,弱一致性......)

- Availability: 可用性表示服务在正常响应时间内一直可用。

- Partition tolerance: 但凡是分布式系统,则必须满足这点。表示的是分布式系统在某个节点挂点或网络分区之后仍然可以对外提供服务。

常用几种解决方案

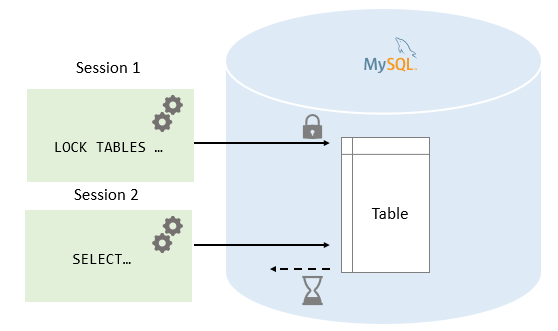

基于数据库的单机锁

Mysql单机实现

Mysql最简单的方法就是使用 select * for update 来操作某一个字段,使用innodb原生的悲观锁进行操作。这里只有一个简单的CAS操作,但是剩下的time-out可能还需要我们自己实现。

另外还可以考虑Mysql原生的函数 get_lock 与 release_lock 来实现。

mysql> SELECT GET_LOCK('abc', 10);

相较于for update的实现,lock原生支持超时设置

可以阅读详细的文档

基于Mysql实现起来的分布式锁十分方便快捷,但是性能可能不如redis,另外由于是单机版,所以当mysql挂掉之后服务将会变得不可用。

Redis单机实现

Redis自身提供了 setnx px 的命令供我们去使用,在拿锁的时候可以使用该命令。

简单的一条命令 SETNX resource value PX 30000

SETNX 表示的是只有这个Key不存在的时候才会去设置value, px表示的是过期时间。

释放锁的时候则可能需要配合lua脚本去使用来确保锁的原子性

if redis.call("get",KEYS[1]) == ARGV[1] then

return redis.call("del",KEYS[1])

else

return 0

end

Redis的单机锁的实现可以满足大部分场景,性能也是比较好的,唯一不足的就是当Redis节点挂掉之后服务也会变得不可用。

基于 Redis集群的解决方案

基于Redis集群的分布式锁方案官方其实给了一个Redlock 算法。大致的实现我简化下:

在 cluster模式下使用 setnx key val px 去拿到锁,key的方案基于 UUID的方式去生存,在集群中如果Quorum(大于一半的节点)同意,则返回该锁。

现在假设有5个Redis主节点(大于3的奇数个),这样基本保证他们不会同时都宕掉,获取锁和释放锁的过程中,客户端会执行以下操作:

- 获取当前Unix时间,以毫秒为单位

- 依次尝试从5个实例,使用相同的key和具有唯一性的value获取锁当向Redis请求获取锁时,客户端应该设置一个网络连接和响应超时时间,这个超时时间应该小于锁的失效时间,这样可以避免客户端死等

- 客户端使用当前时间减去开始获取锁时间就得到获取锁使用的时间。当且仅当从半数以上的Redis节点取到锁,并且使用的时间小于锁失效时间时,锁才算获取成功

- 如果取到了锁,key的真正有效时间等于有效时间减去获取锁所使用的时间,这个很重要

- 如果因为某些原因,获取锁失败(没有在半数以上实例取到锁或者取锁时间已经超过了有效时间),客户端应该在所有的Redis实例上进行解锁,无论Redis实例是否加锁成功,因为可能服务端响应消息丢失了但是实际成功了,毕竟多释放一次也不会有问题

关于redlock算法其实 Martin(DDIA作者)已经批判过了,事后redis的作者antirez也回应了

大致总结下:

- Redis本身是基于系统时钟生产的token(不可避免的会有时钟漂移),这个并不能完整的保障fencing token的线性一致性。

- Redlock太重了,本身的正确性也是无法保障的,大多数场景下,单节点的redis就可以满足大部分场景。

- 如果想使用分布式锁,最好使用线性一致性的系统(Zookeeper/Etcd)

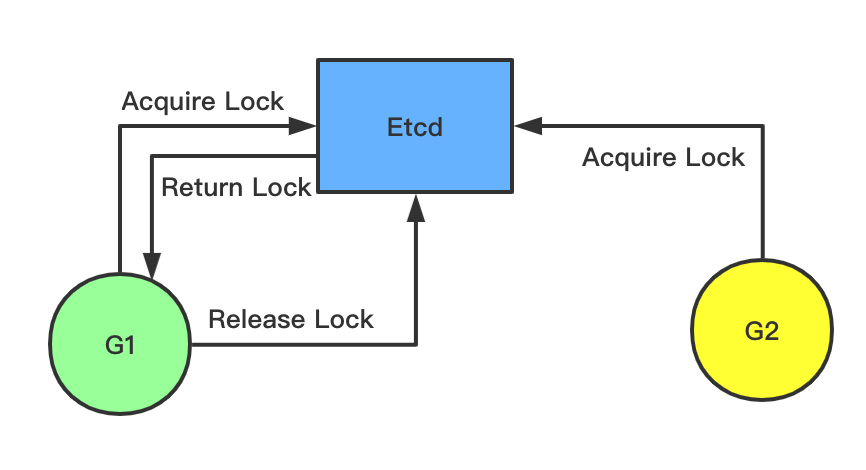

基于Etcd的解决方案

Etcd是基于Raft实现的强一致的KV存储系统,其本身自带的一系列机制也可以很好的帮我们实现分布式锁:

- Lease 租约机制,

etcd本身的租约机制是根据单调时钟实现的,系统时间一直往前,不会出现分布式系统里面系统时钟的GAP。 - Revision 每个key 都有对应的revision,

etcd使用revision来实现的MVCC,本质上来说是一个乐观锁。 - Watch 监听机制,

etcd可以Watch某个key,当key产生变化的时候可以收到具体的消息通知

Etcd 本身提供了一个mutex包供我们使用,可以看个简单的例子

// goroutine 1

go func () {

session, err := concurrency.NewSession(cli)

m := concurrency.NewMutex(session, "test")

// Do something

m.Unlock(context.TODO())

}

// goroutine 2

go func () {

session, err := concurrency.NewSession(cli)

m := concurrency.NewMutex(session, "test")

// wait for lock

m.Unlock(context.TODO())

}上面的goroutine2会等待goroutine1执行完再去执行之后的代码。

具体看可以看实现的代码, etcd里面代码很简练,只看Lock和UnLock

func (m *Mutex) Lock(ctx context.Context) error {

s := m.s

client := m.s.Client()

m.myKey = fmt.Sprintf("%s%x", m.pfx, s.Lease())

cmp := v3.Compare(v3.CreateRevision(m.myKey), "=", 0)

// put self in lock waiters via myKey; oldest waiter holds lock

put := v3.OpPut(m.myKey, "", v3.WithLease(s.Lease()))

// reuse key in case this session already holds the lock

get := v3.OpGet(m.myKey)

// fetch current holder to complete uncontended path with only one RPC

getOwner := v3.OpGet(m.pfx, v3.WithFirstCreate()...)

resp, err := client.Txn(ctx).If(cmp).Then(put, getOwner).Else(get, getOwner).Commit()

if err != nil {

return err

}

m.myRev = resp.Header.Revision

if !resp.Succeeded {

m.myRev = resp.Responses[0].GetResponseRange().Kvs[0].CreateRevision

}

// if no key on prefix / the minimum rev is key, already hold the lock

ownerKey := resp.Responses[1].GetResponseRange().Kvs

if len(ownerKey) == 0 || ownerKey[0].CreateRevision == m.myRev {

m.hdr = resp.Header

return nil

}

// wait for deletion revisions prior to myKey

hdr, werr := waitDeletes(ctx, client, m.pfx, m.myRev-1)

// release lock key if wait failed

if werr != nil {

m.Unlock(client.Ctx())

} else {

m.hdr = hdr

}

return werr

}func (m *Mutex) Unlock(ctx context.Context) error {

client := m.s.Client()

if _, err := client.Delete(ctx, m.myKey); err != nil {

return err

}

m.myKey = "\x00"

m.myRev = -1

return nil

}

代码不复杂,Lock的时候会去通过Txn(etcd事务)尝试创建一个key, 并grant一个TTL。如果key存在的话,会去一直等待上一个Key删除,不存在就会返回,表示抢锁成功。删除的时候直接删除对应的Key就行。

小结

Redis lua单机锁可以满足大部分的使用场景,如果对于一致性和可用性有非常高的要求可以使用Etcd,不太推荐使用redis cluster分布式锁。

参考资料

redis相关

redis相关

数据库

redis默认情况下会创建16个db,并使用0号数据库,可以通过select语句切换数据库。是通过切换redisClient里面的redisDb指针来实现的

- expire key ttl,设置生存时间为ttl秒

- pexipre 同上,设置的粒度是ms

- expireat key timestamp 将key的过期时间设置为时间戳

- pexpireat 同上,粒度为ms

上面的4种都会转化成pexpireat

persist移除过期时间

过期算法有三种:

- 定时删除,根据timer来删除

- 被动删除,取key的时候删除

- 主动删除,每隔一段时间去检查

持久化

RDB

RDB是将数据库状态保存为文件,RDB可以手动执行,也可以在redis定期执行。有两个命令可以保存RDB文件,save和bgsave。save命令会阻塞redis服务进程,直到RDB文件创建完成,在这个期间服务器不能处理其它命令。bgsave会fork一个子进程,子进程负责RDB文件的写入,主线程负责处理请求。

- master执行save的时候不会保存过期的key到RDB文件里面

- slave执行save的时候会保存过期的key,在之后的replication去同步

AOF持久化

AOF持久化是通过保存redis的所执行的写命令来保存数据状态的,包括命令追加,文件写入,文件同步三个步骤

AOF的更新频率比RDB高,所以

- 服务器优先使用AOF

- 只有AOF关闭的时候,服务器才能使用RDB恢复数据库

AOF命令追加

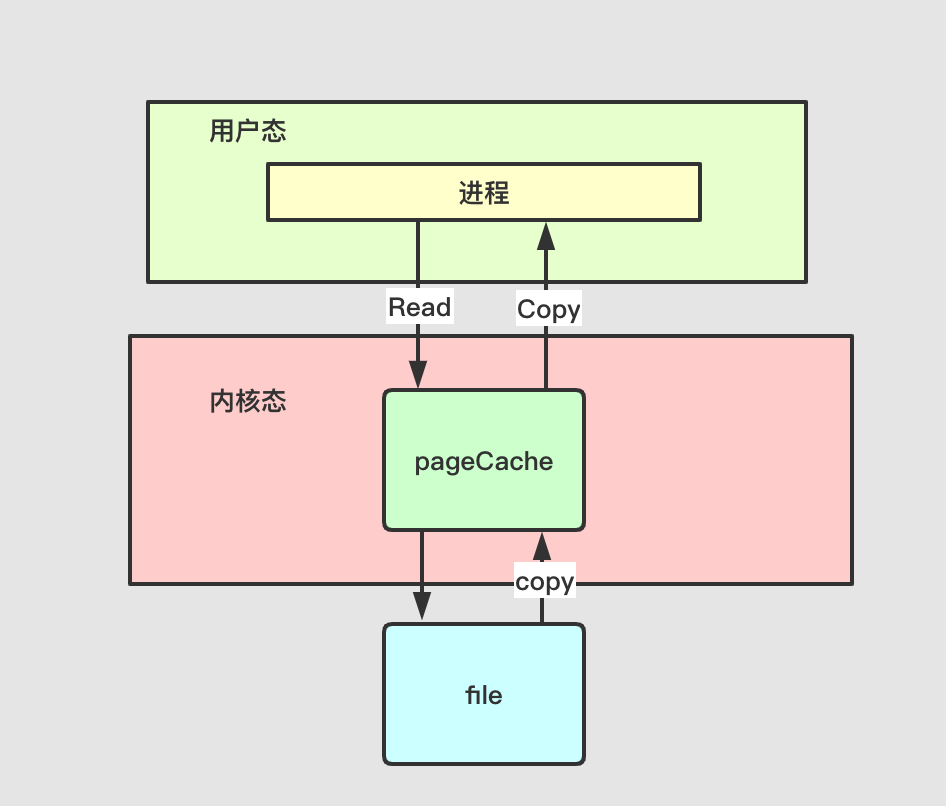

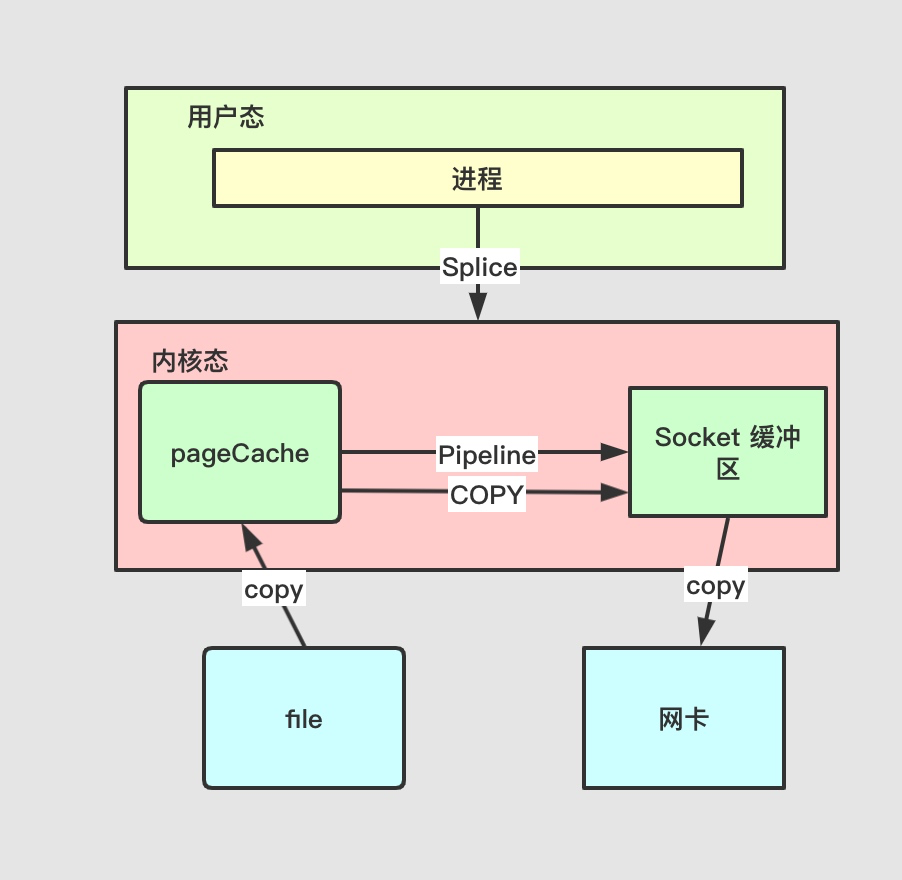

当服务器执行完一个写命令后,会把协议追加到aof_buf的缓冲区里头

AOF写入和同步

redis在eventloop中执行完了写函数之后,都会调用flushAppendOnlyFile考虑是否将aof_buf的内容写到文件中,flushAppendOnlyFile由配置文件中的appendfsync来控制。appendfsync有三个选项

- always 每次都会写入并且同步到aof文件

- everysec 每次都会写入,距离上次写入的时间超过一秒就同步

- no 将aof_buf缓冲区写入文件,何时同步由系统决定

AOF的载入与还原:redis服务端创建一个不带网络连接的伪客户端,从aof文件读取命令,使用伪客户端执行命令

AOF文件写入

当数据库某个键已经过期,AOF不会因为这个过期键产生影响,当被删除之后,会向AOF文件apped一条del命令。在AOF重写的时候的过程中会去检查过期的键,已过期的键不会被写入AOF文件

AOF重写(BGREWRITEAOF)会去除一些冗余的写命令,重写后会用新的AOF文件去覆盖旧的。AOF重写是在子进程中进行的,在服务器处理完写操作后,会把命令同时追加到AOF缓冲区和AOF重写缓冲区。

复制

redis复制的步骤:

- 从服务器向主服务器发送psync命令

- 主服务器收到psync命令,执行bgsave生成RDB文件,并使用一个缓冲区记录从开始到结束所有的写命令

- 主服务器的bgsave执行完成后将RDB发送给从服务器,从服务器更新

- 主服务器发送缓冲区内容给从服务器,从服务器执行并更新

psync有完整同步和部分重同步,完整同步用于初次处理复制情况,部分重同步用来处理断线后的情况

集群

redis集群通过槽节点分片实现,集群的整个数据库被分为16384个槽节点,数据库中每个键都属于这些槽节点中。redis本身并不支持一致性hash,可以用twemproxy方案解决。

在集群中执行命令的时候如果键所在的槽正好指派给了该节点,则该节点执行命令。若不在该节点,节点返回一个moved错误,客户端指引到正确的节点,再次发送该命令。

发布与订阅

redis发布与订阅由publish,subscribe,psubcribe命令组成

psubcribe是用来订阅一个或者多个发布者的,用*作为匹配符

事务

redis通过multi,exec,watch实现事务功能,在事务执行期间,服务器不会中断事务去执行其他客户端的请求。事务由multi开始,exec提交给服务器。

事务执行

当一个客户端处于非事务状态时,发送的命令会被立即执行

当一个客户端处于事务状态时

- 如果客户端发送的是exec,discard,watch,multi命令中的一个,服务器立即执行

- 如果客户端发送的不是上面4个命令中的一个,服务端将命令放到一个事务队列里面,向客户端返回queued命令

当一个处于事务状态的客户端发送exec命令的时候,exec立即执行,服务器便利遍历客户端的事务队列,将执行结果全部返回给客户端。

watch是一个乐观锁,可以在exec执行之前监控任意数量的数据库键,并在exec执行的时候,检查被监控的键是否修改过,如果是的话则拒绝事务

redis的事务是不支持回滚的,事务只会因为语法的错误而失败

IOStream分析

IOStream

socket的非阻塞IO的读写操作封装

函数说明

__init__

初始化的时候将_self._handle_events_作为handler添加到IOLoop中,等待读事件

read_until

接收一个_delimiter_作为分隔符,当读取到_delimiter_的时候,调用_callback_。读取完后更新IOLoop事件,等待读事件。

read_bytes

接收一个_num_bytes_作为分隔符,当读取字节大于_num_bytes_的时候,调用_callback_。读取完后更新IOLoop事件,等待读事件。

write

将需要写的字符添加到_self.write_buffer, 调用__add_io_state_,更新IOLoop事件,等待写事件。

_handle_events

当fd状态发生改变的时候,对fd和相应事件进行处理。有读事件的时候,调用__handle_read_, 有写事件的时候调用__handle_write_。当_self._write_buffer_不为空时更新写事件,当_self._read_delimiter_或者_self._read_bytes_更新写事件。

_handle_read

将读取到的内容加载到_self._read_buffer_中,回调_self.read_bytes,清空_self.read_buffer

_handle_write

将_self._write_buffer_发送,回调_self.write_callback。

通过test case 进行流程分析

import socket

from tornado import ioloop, iostream

s = socket.socket()

s.connect(("baidu.com", 80))

stream = iostream.IOStream(s)

def on_headers(data):

headers = {}

for line in data.split("\r\n"):

parts = line.split(":")

if len(parts) == 2:

headers[parts[0].strip()] = parts[1].strip()

stream.read_bytes(int(headers["Content-Length"]), on_body)

def on_body(data):

print data

stream.close()

ioloop.IOLoop.instance().stop()

stream.write("GET / HTTP/1.0\r\n\r\n")

stream.read_until("\r\n\r\n", on_headers)

ioloop.IOLoop.instance().start()

cpu cache 相关

关于CPU cache

简要

一般来说x86 结构cpu cache line 的大小是64 byte, arm cacheline 是32 byte。

CPU 的 Cache 从上至下可以分为 L1(L1d 数据缓存, L1i指令缓存), L2, L3(多个 core 共享一个) 三层cache. 每层的访问速度由上至下依次递减, 可以使用lscpu命令查看.

L1d cache: 32K

L1i cache: 32K

L2 cache: 1024K

L3 cache: 39424K

CPU从Cache数据的最小单位是字节,Cache从Memory拿数据的最小单位是64Bytes,Memory从硬盘拿数据通常最小是4092Bytes。

CPU Cache 的 prefetch

CPU每次从地址空间拿地址的时候不是按照一个一个地址去拿的,而是有一个 prefetch 的操作,每次会拿一个 cache line(大部分 CPU 的 cache line 是 64 byte)的数据加载。

下面可以测试一下 prefetch 命中和没命中的情况:

本机测试环境 MBP

CPU: Intel(R) Core(TM) i7-8850H CPU @ 2.60GHz

内存: 16 GB 2400 MHz DDR4

代码测试

func main() {

a := make([][]int, 1024)

r := 0

for i := 0; i < 1024; i++ {

a[i] = make([]int, 1024)

}

fmt.Printf("address of a[0][0] %p a[0][1] %p a[1][0] %p a[0][1023] %p \n", &a[0][0], &a[0][1], &a[1][0], &a[0][1023])

for i := 0; i < 1023; i++ {

for j := 0; j < 1023; j++ {

r += a[i][j]

//r += a[j][i]

}

}

fmt.Println(r)

}

a[i][j] 赋值的时间

➜ time go run slice.go

go run slice.go 0.34s user 0.29s system 54% cpu 1.166 total

a[j][i] 赋值的时间

go run slice.go 0.29s user 0.23s system 51% cpu 0.998 total

从上面的测试可以看到 a[i][j] 的花费时间为0.29s, 但是a[j][i]的花费时间为 0.34s. 因为我们在声明二维数组的时候可以发现其在内存里面连续分配的,代码输出地址a[0][0] 与 a[0][1] 相差一个int。但是a[0][0]与 a[1][0] 相差 1024 个int。 当我们从j开始从小到大依次便利的时候,CPU会一直从 cache line 里面去拿数据,如果是从i 开始的时候每次的cache line都会reload。从下面打印的数组地址也可以看出来:

address of a[0][0] 0xc000114000 a[0][1] 0xc000114008 a[1][0] 0xc000116000 a[0][1023] 0xc000115ff8

CPU Cache 的 false sharing

True sharing: 多核竞争的,是同一份将要访问的数据,比如全局变量的修改。

False sharing:

当一组相邻变量被多个核共享的时候(与true sharing不同的是访问的不是同一变量),其中一个core 改变了里面的值就会导致另外一个 core 里面的cache line reload,造成cache miss。

贴一下相关的代码以及本机的测试

type MyAtomic interface {

IncreaseAllEles()

GetEles() uint64

}

type NoPad struct {

a uint64

b uint64

c uint64

}

func (myatomic *NoPad) IncreaseAllEles() {

atomic.AddUint64(&myatomic.a, 1)

atomic.AddUint64(&myatomic.b, 1)

atomic.AddUint64(&myatomic.c, 1)

}

func (myatomic *NoPad) GetEles() uint64 {

return myatomic.a + myatomic.b + myatomic.c

}

type Pad struct {

a uint64

_p1 [8]uint64

b uint64

_p2 [8]uint64

c uint64

_p3 [8]uint64

}

func (myatomic *Pad) IncreaseAllEles() {

atomic.AddUint64(&myatomic.a, 1)

atomic.AddUint64(&myatomic.b, 1)

atomic.AddUint64(&myatomic.c, 1)

}

func (myatomic *Pad) GetEles() uint64 {

return myatomic.a + myatomic.b + myatomic.c

}

func testParallelAtomicIncrease(myatomic MyAtomic) {

paraNum := 1000

addTimes := 1000

var wg sync.WaitGroup

wg.Add(paraNum)

for i := 0; i < paraNum; i++ {

go func() {

for j := 0; j < addTimes; j++ {

myatomic.IncreaseAllEles()

}

wg.Done()

}()

}

wg.Wait()

}

测试结果

➜ test go test -bench=.

goos: darwin

goarch: amd64

BenchmarkNoPad-12 20 61637165 ns/op

BenchmarkPad-12 50 27061445 ns/op

PASS

解决false sharing的办法就是加padding,增加一些无意义的变量(64byte), 让原本相邻的变量不相邻,这样prefetch的时候就不会更改相应的 cache line , 产生cache reload 的现象。具体可以参考篇文章

TLB的影响

TLB是Translation Lookaside Buffer的简称, 为了避免CPU每次取页表的时候都访问MMU,所以引入了TLB这一层的cache。

所以在写程序的时候需要注意TLB的reload,Page的大小一般为4KB, 假设TLB的最大limit数是x, 当程序的内存使用超过 4xKb之后就会开始影响性能

由于手头上只有MAC,GCP上的虚拟机对perf的支持不是太友好,所以这边只贴一下perf的相关命令, 具体的测试结果可以参看下面的文章

perf stat -e dTLB-load,dTLB-load-misses,LLC-load,LLC-load-misses,LLC-prefetches,LLC-prefetch-misses,L1-dcache-loads,L1-dcache-misses,cycles:u,instructions:u -p PROCID sleep 10

相关测试可以参考

小结

在写代码的时候,同时注意到上面的东西很困难,但是我们也需要知道在代码里面发生了什么。

一般从cpu cache line reload -> cpu cache miss -> TLB miss -> page fault -> disk cache miss,这里面的每一层的miss其实都会带来损耗。所以实际上在写业务代码的时候需要根据各个方面去做trade-off.

Tornado之gen.engine

Tornado之gen.engine

这个模块是用来在Tornado里边写异步回调的,具体用法可以参考Tornado之gen.enegine

分析:

先看示例代码

class GenAsyncHandler(RequestHandler):

@asynchronous

@gen.engine

def get(self):

http_client = AsyncHTTPClient()

response = yield gen.Task(http_client.fetch, "http://example.com")

do_something_with_response(response)

self.render("template.html")

函数入口为gen.engine,是一个装饰器:

def engine(func):

@functools.wraps(func)

def wrapper(*args, **kwargs):

gen = func(*args, **kwargs)

if isinstance(gen, types.GeneratorType):

Runner(gen).run()

return

assert gen is None, gen

# no yield, so we're done

return wrapper

这里gen = func(*args, **kwargs)结合示例代码代码来看,返回一个可迭代对象。继续跟进Runner类的run方法。

def run(self):

"""Starts or resumes the generator, running until it reaches a

yield point that is not ready.

"""

if self.running or self.finished:

return

try:

self.running = True

while True:

if self.exc_info is None:

try:

if not self.yield_point.is_ready():

return

next = self.yield_point.get_result()

except Exception:

self.exc_info = sys.exc_info()

try:

if self.exc_info is not None:

exc_info = self.exc_info

self.exc_info = None

yielded = self.gen.throw(*exc_info)

else:

yielded = self.gen.send(next)

except StopIteration:

self.finished = True

if self.pending_callbacks:

raise LeakedCallbackError(

"finished without waiting for callbacks %r" %

self.pending_callbacks)

return

except Exception:

self.finished = True

raise

if isinstance(yielded, list):

yielded = Multi(yielded)

if isinstance(yielded, YieldPoint):

self.yield_point = yielded

self.yield_point.start(self)

else:

self.exc_info = (

BadYieldError(

"yielded unknown object %r" %

yielded),)

finally:

self.running = False

逐行进行分析,Runner类在__init__方法里边接收一个gen及迭代器作为参数,将self.yield_point设置为_NullYieldPoint。看一下_NullYieldPoint定义了三种方法:

class _NullYieldPoint(YieldPoint):

def start(self, runner):

pass

def is_ready(self):

return True

def get_result(self):

return None

主要看run方法, 先是进行一些列条件判断,然后进入while循环,self.exc_info里边存取系统报错信息。next = self.yield_point.get_result()这里的next为None,yielded = self.gen.send(next)开始迭代,这里结合示例代码,程序执行到第一个yield之前。即response = yield gen.Task(http_client.fetch, "http://example.com")。

class Task(YieldPoint):

def __init__(self, func, *args, **kwargs):

assert "callback" not in kwargs

self.args = args

self.kwargs = kwargs

self.func = func

def start(self, runner):

self.runner = runner

self.key = object()

runner.register_callback(self.key)

self.kwargs["callback"] = runner.result_callback(self.key)

self.func(*self.args, **self.kwargs)

def is_ready(self):

return self.runner.is_ready(self.key)

def get_result(self):

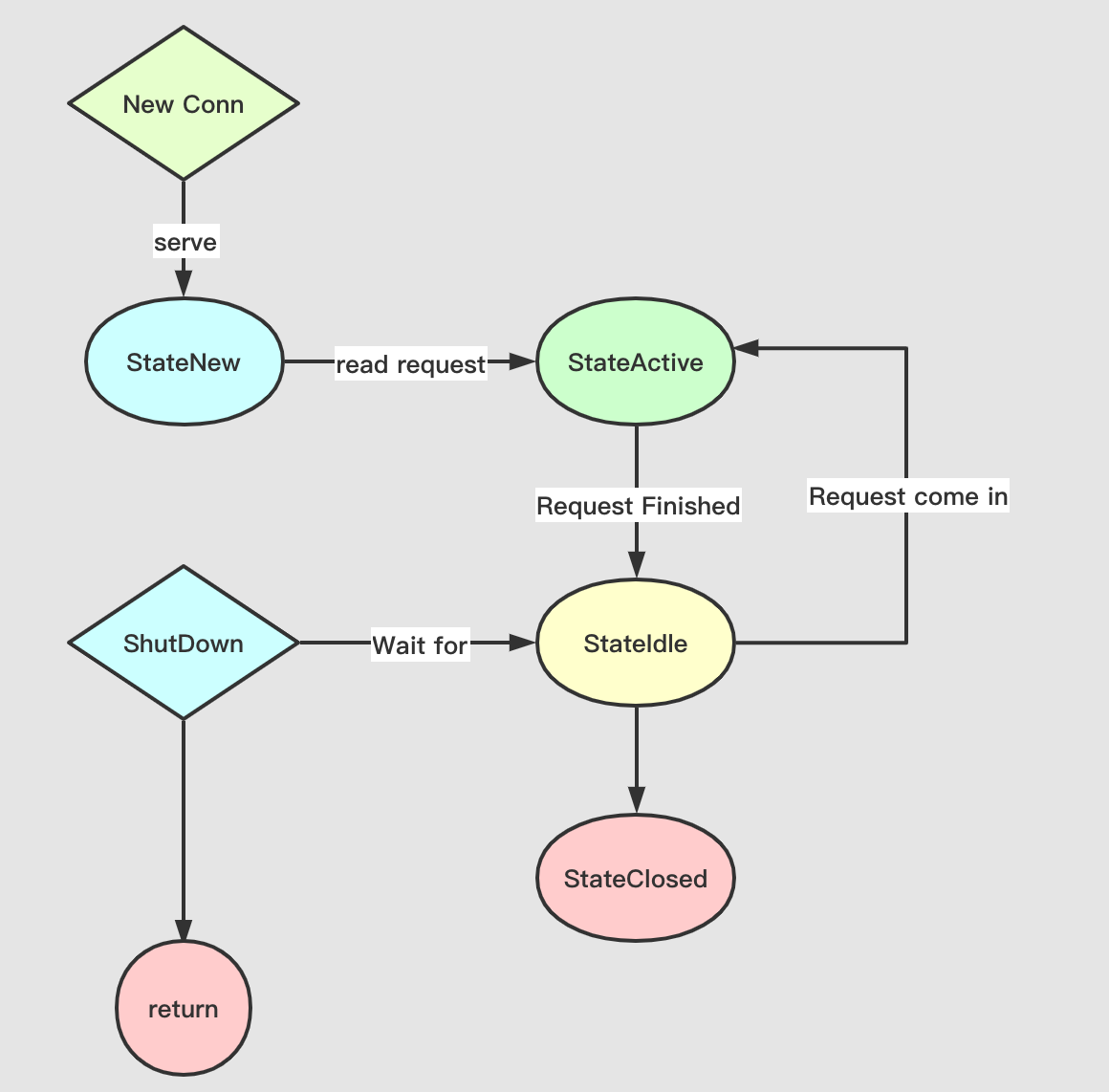

return self.runner.pop_result(self.key)

生成一个Task对象,回到Runner的run方法, self.yield_point = yielded这里的self.yield_point为Task对象,调用self.yield_point.start(self)。在start方法里边runner.register_callback(self.key)这里将当前的这个异步任务进行注册,添加到Runner的pending_callbacks中。self.kwargs["callback"] = runner.result_callback(self.key),这应该是整个回调的核心,将异步函数中的callback设置为result_callback。这就意味着我们在生成Task的时候,**kwargs中是不允许传callback进去的,并将异步函数中的回调设置为result_callback中的inner,当回调完成后调用set_result,继续进行迭代。

用简单的demo进行说明:

from tornado import gen

@gen.engine

def test():

print "start"

yield gen.Task(test_callback)

print "end"

def test_callback(callback=None):

print callback

print "start end!"

callback()

test()

其中test_callback必须要接受一个callback参数,当调用callback()后,设置Runner中self.results[key] = result,调用run进行下一次迭代,结束。

看另一个示例代码:

class GenAsyncHandler2(RequestHandler):

@asynchronous

@gen.engine

def get(self):

http_client = AsyncHTTPClient()

http_client.fetch("http://example.com",

callback=(yield gen.Callback("key"))

response = yield gen.Wait("key")

do_something_with_response(response)

这里的yield gen.Wait("key")为Runner.run(gen)第一次yield的值,并将gen.Callback("key")作为回调。当fetch完成后,再回调进行下一次yield。

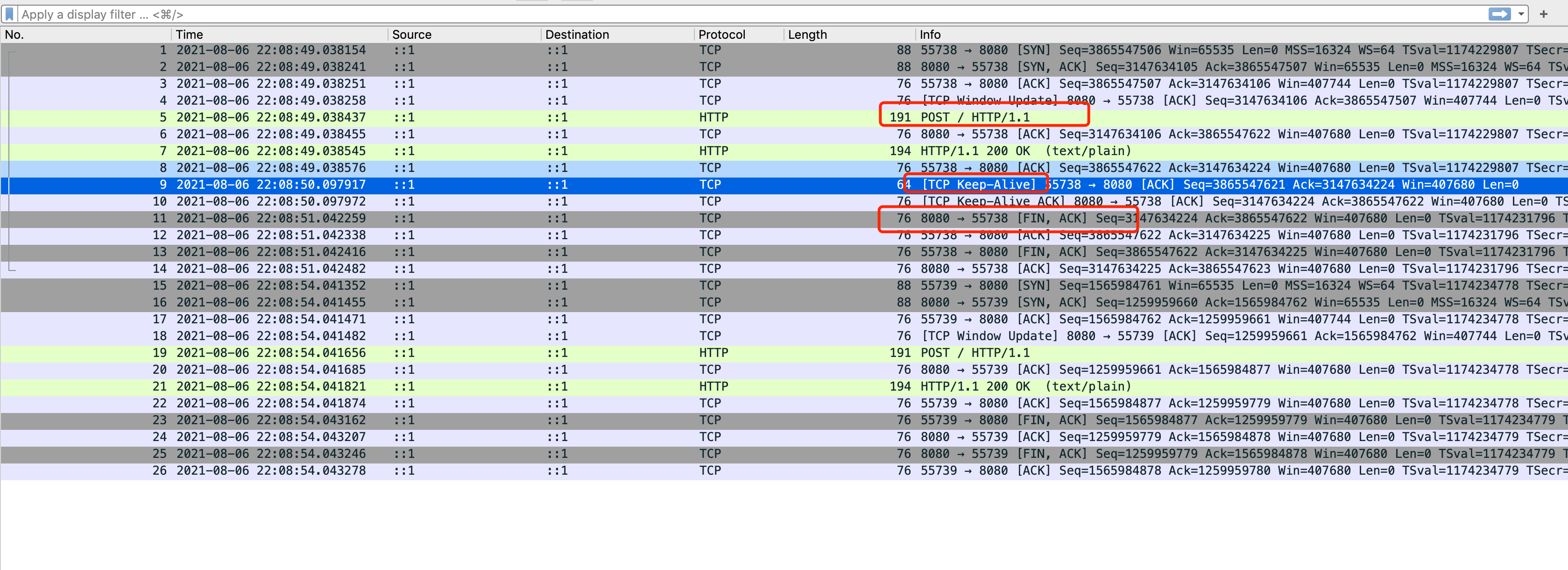

烦人的线上TCP HOL

一次烦人的线上TCP 重传

Background

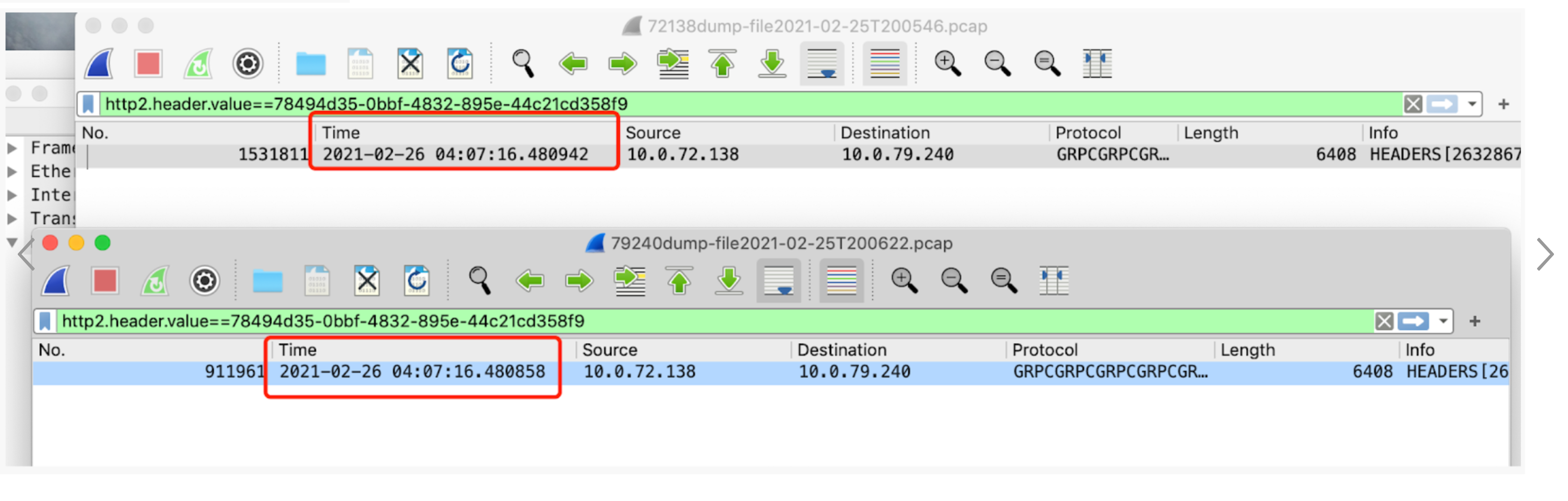

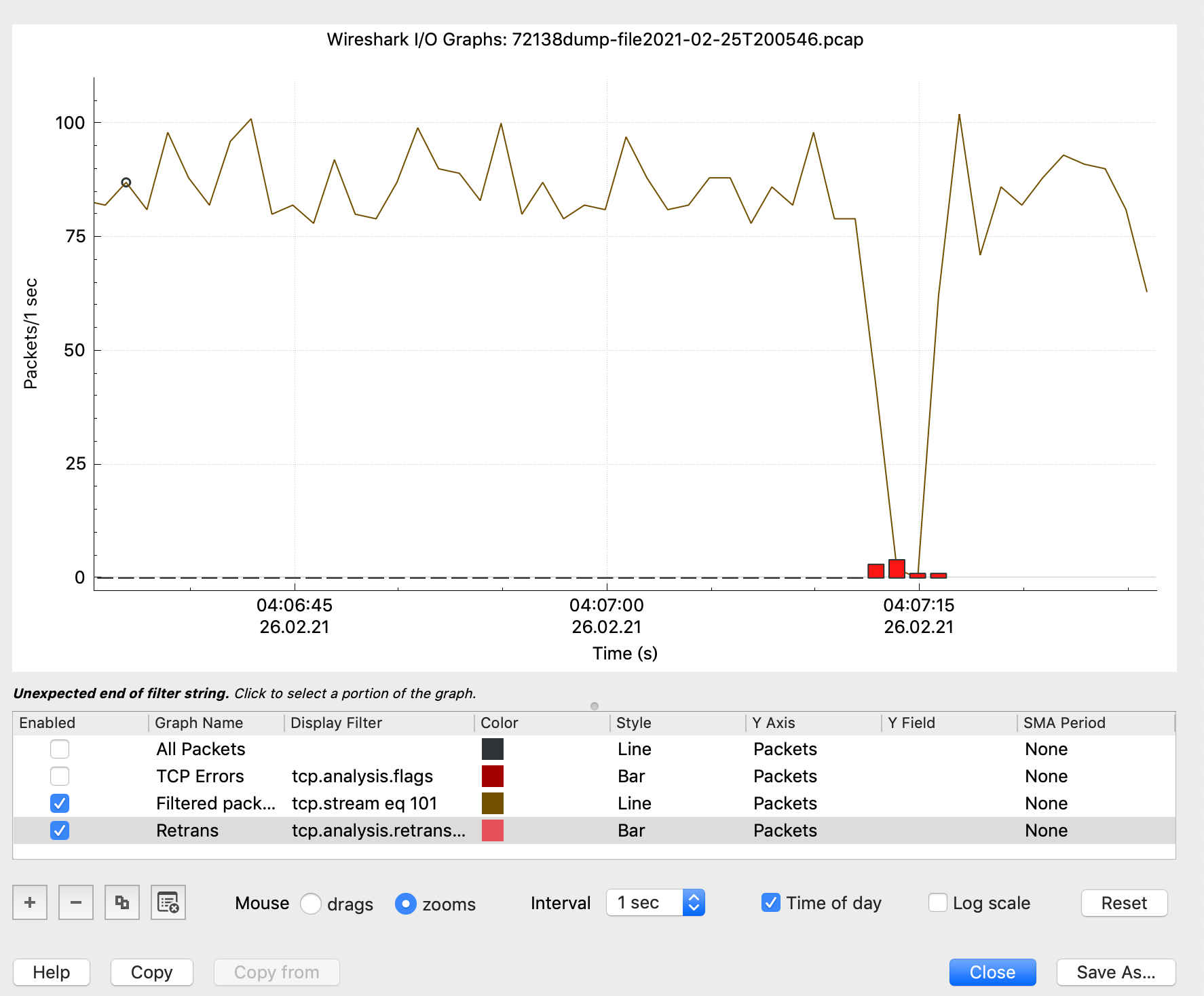

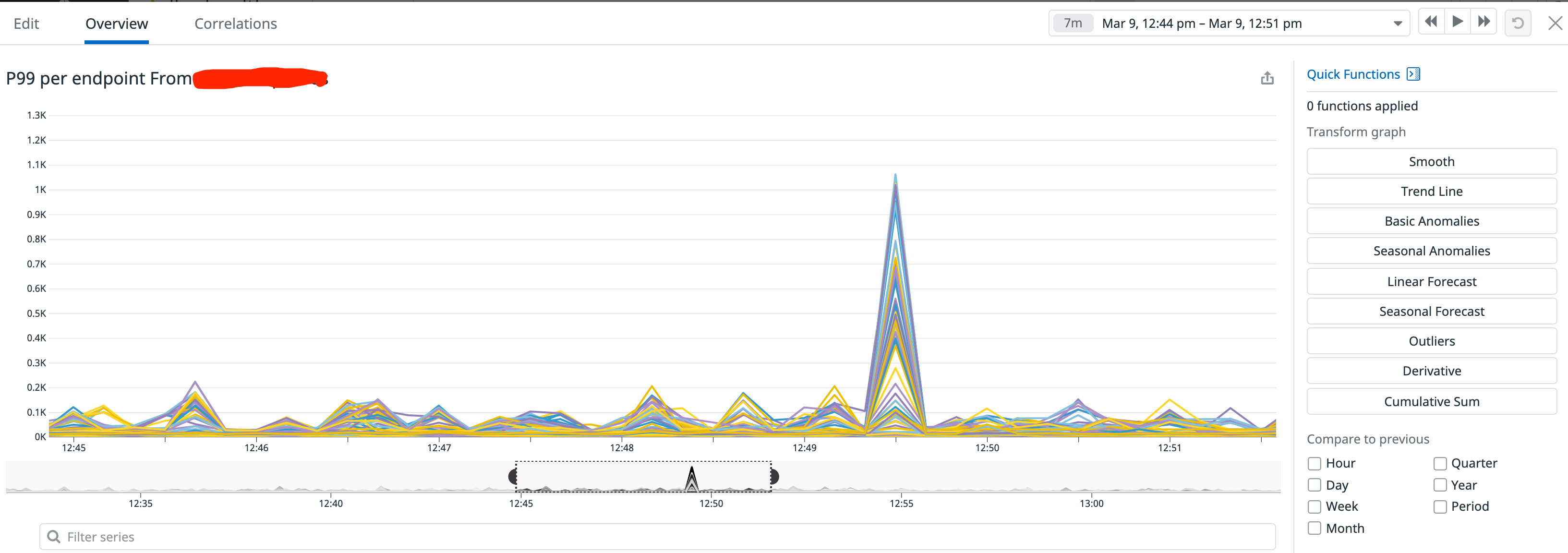

之前线上有段时间P99不太正常,于是跟同事开始排查原因。业务上的表现是每隔一段时间,线上的SLA就会出现一个毛刺,latency增加到800ms。发生的时间点不固定,可能出现在集群的任何机器上。

在对业务代码进行一一排除之后,发现可能出问题的只有grpc的调用链路了,于是我们打印了全量的grpc日志,但是发现并没有报错信息。于是最后只能在线上开启tcpdump抓取报文进行分析。

分析

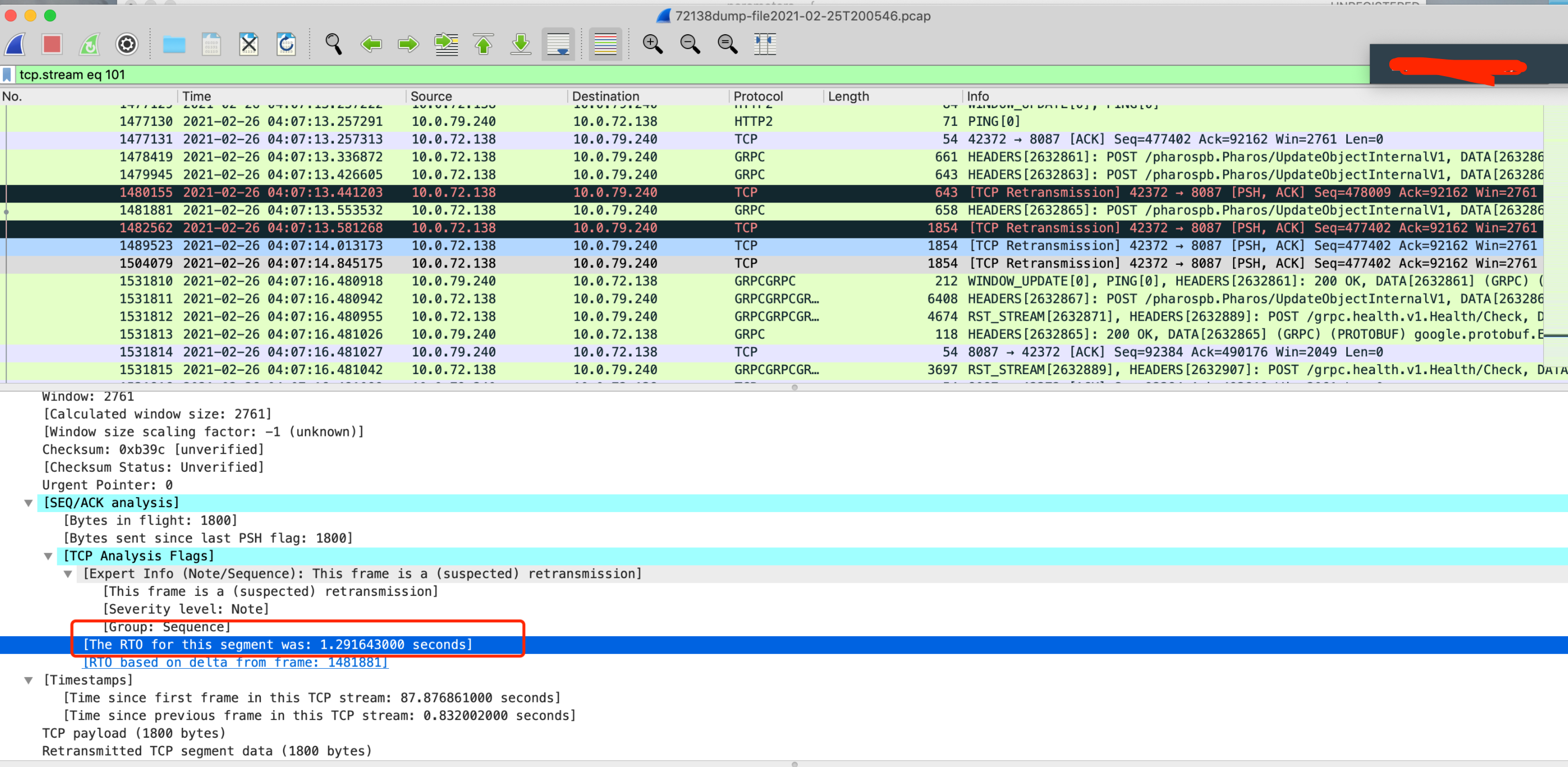

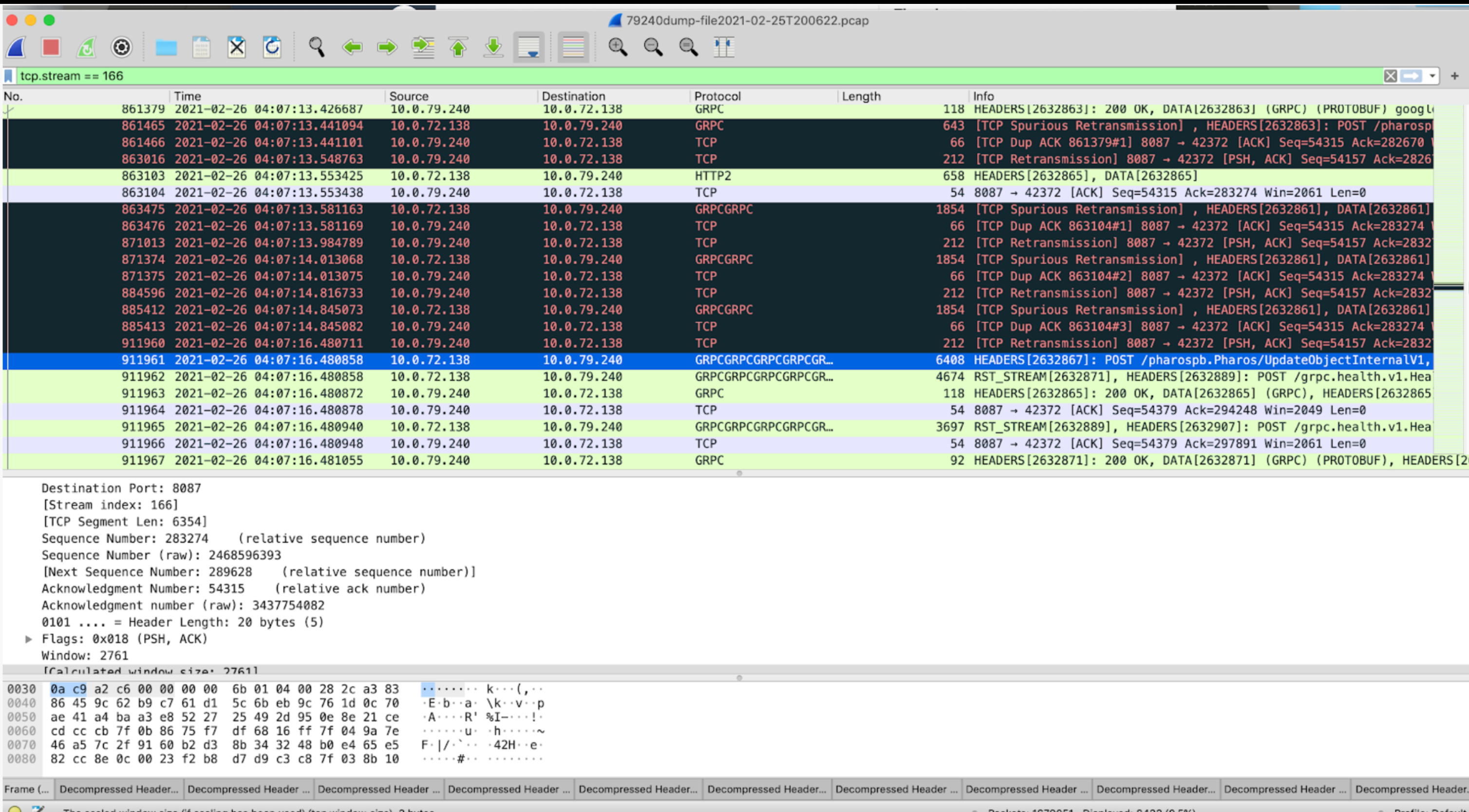

抓到的报文有很多个case,不过大多都是类似的场景。我用其中一个进行举例:

时间点

- Client ip: 10.0.72.138

- Server ip: 10.0.79.240

业务侧日志时间点:

Client侧发送请求的时间点 04:07:14.28,Server侧收到请求的时间点 04:07:16.48,中间大概有两秒左右的时间差

tcpdump的时间点:

client侧发送的时间点 04:07:16.48, 基本与server侧业务代码收到的时间点吻合。server侧收到的时间点04:07:16.48,与发送的时间点几乎一致,于是可以断定是request阻塞在client侧。

TCP Stream分析

光看一个报文没有太多的有效信息,需要结合整个TCP的连接来进行分析,这里就用stream表示。

能够看到的现象是发生问题的时间点有TCP重传。但是整个tcp stream只有极少数的重传,占比很少。

先看Client侧的问题,length为1854的包在事故的时间点重传了三次,RTO时间指数增加,从200ms->400ms->1200ms,client侧的request全部block住了。

再看Server侧的,可以看到1854这个包Server是回复了ACK的,每次都很及时的回复了ACK。说明Server->client侧的连接出了问题,导致client侧收不到ACK, 于是触发超时重传,开始进行指数退避,所有的request都会被block在客户端。

HOL

关于HOL的分析网上现在其实很多文章,这里就不再详细介绍了。关于TCP的这个HOL之前一直有个误解点,就是是否会阻塞整条链路,之前理解的是不会阻塞整条链路。只会在下次send的时候把缺失的包带上,结合实际拥塞控制算法来看,每当超时重传发生的时候,实际的CWND都会变成1开始进行传送,意味着只有一个发送窗口,如果对端不能及时返回,则会阻塞所有请求。

所以可以看到:如果能收到对端回复的ACK表示只是丢包,但是RTO超时就意味着网络情况及其糟糕,CWND重置为1开始进行发送。

网络

我们的服务是跑在AWS虚拟机上的,所以后面的整个网络链路对于我们来说几乎都是黑盒。如果这种情况只发生一两次,我们可以理解为网络抖动,但是时常会发生的情况显得不太可接受。

小结

其实上面的场景就是一个典型的http2的 HOL(Head of line blocking),从业务侧的角度来看,一次重传是可以接受的。但是如果开始发生指数级别的多次退避,就会对这条链路带来一定的影响。从提高服务高可用的角度来看,有几个点可以优化:

- 业务侧开启retry,尽可能保证业务方不受影响

- 建立多条连接,提高容错性(grpc内部就是这么做的)

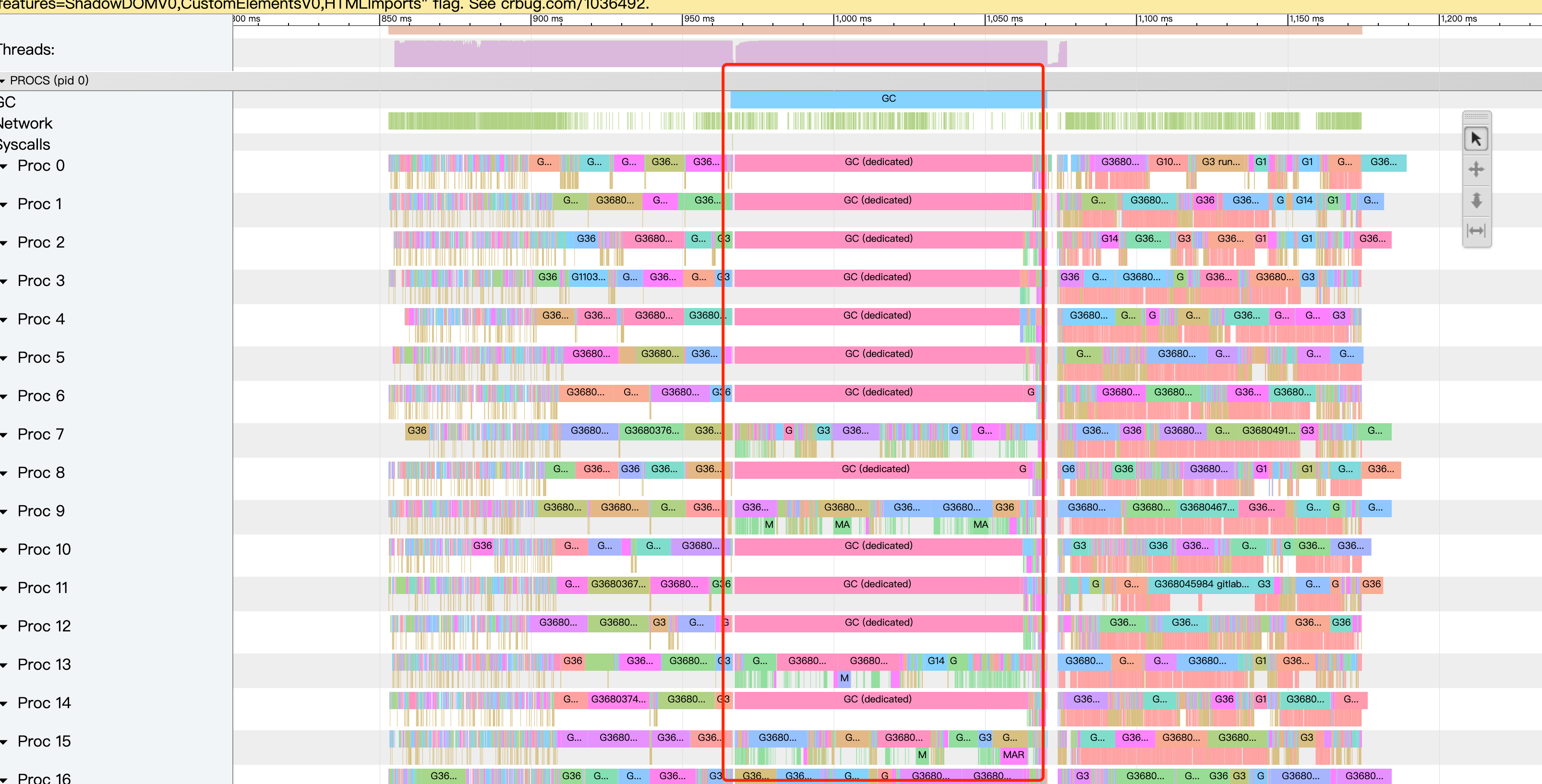

一次优化线上TIME_WAIT过多的connection leak案例

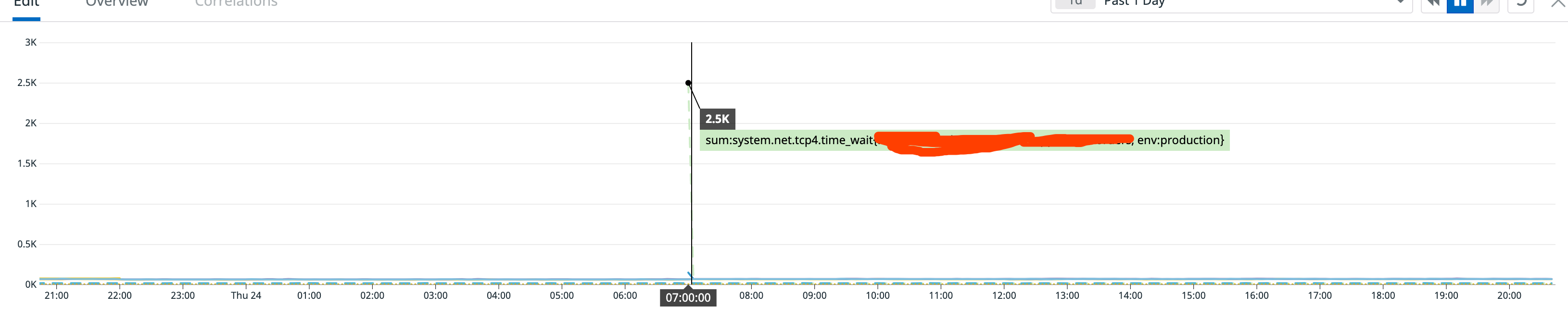

一次优化线上TIME_WAIT过多的connection leak案例

Background

一次观察系统指标的时候发现某个生产环境的TIME_WAIT连接状态异常,线上观察使用的指标是来自DataDog Agent收集的system.net.tcp4.time_wait,但是system.net.tcp4.established的连接数量并没有太大变化,可以观察到的现象大概就是图片所显示的。

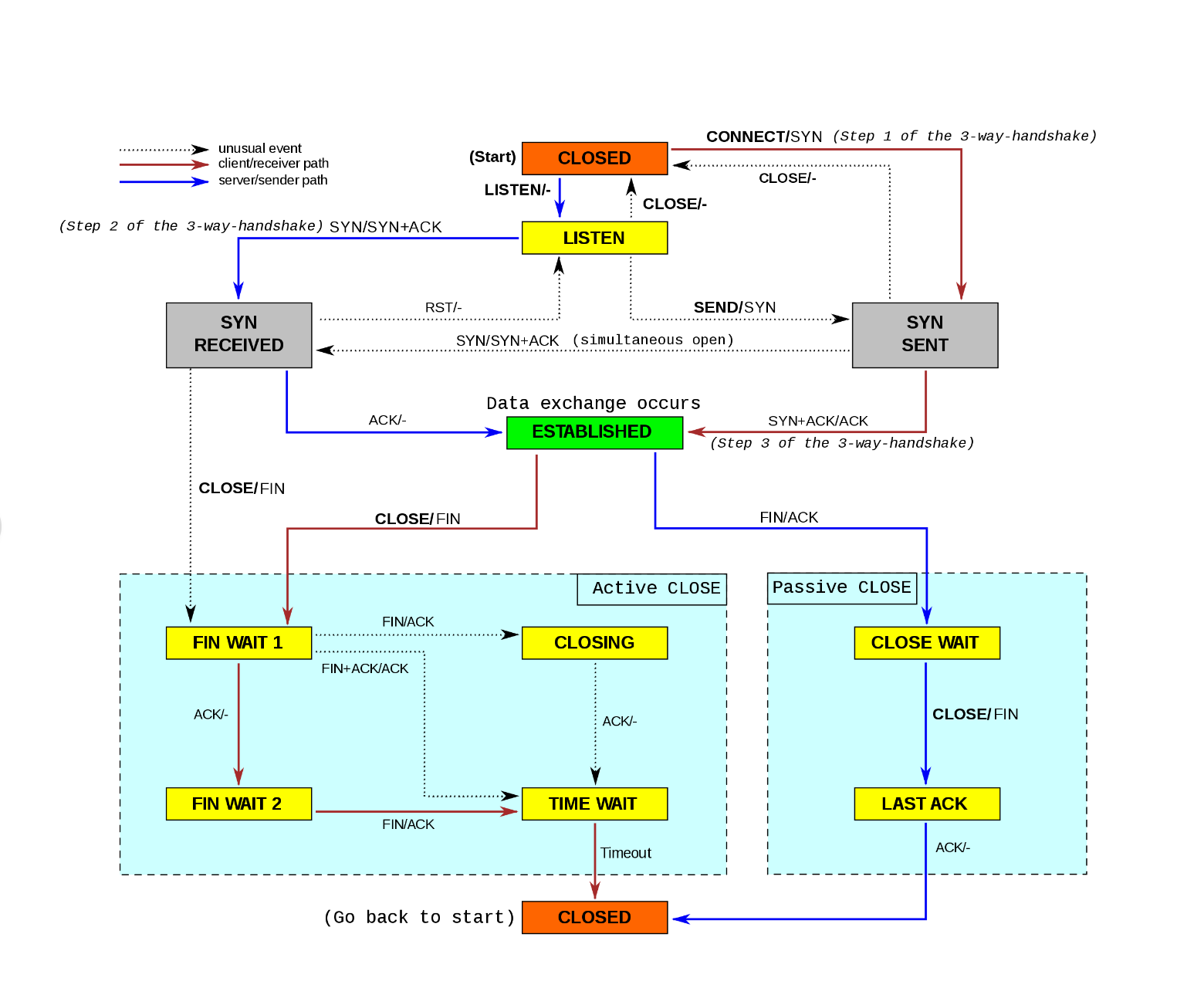

TIME_WAIT这一指标是主动关闭的一方进入的,理论上来说无论如何都需要先进行establish,这一现象太诡异了,于是开始查找原因。

Trace

网络状况

先进行复现,因为程序出现上面的现象是发生在程序启动的时候,所以先在测试环境跑下netstat看下现场:

~$ netstat -an | grep 6379 | awk '{print $1, $6}' | sort | uniq -c | sort -k 1

10 tcp ESTABLISHED

1794 tcp TIME_WAIT

可以 看到确实是ESTABLISHED比TIME_WAIT要少很多, 回忆下TCP的状态机, 能够进入TIME_WAIT的只有FIN_WAIT1, FIN_WAIT2以及CLOSING

再去看下ESTABLISHED里面的四元组情况,发现里面的四元组一直在变化

➜ netstat -an | grep 6379 | grep 'ESTABLISHED' | awk '{print $4, $5, $6}' | sort | uniq -c | sort -k 1

1 ::1.62320 ::1.6379 ESTABLISHED

1 ::1.62346 ::1.6379 ESTABLISHED

1 ::1.62359 ::1.6379 ESTABLISHED

1 ::1.62360 ::1.6379 ESTABLISHED

1 ::1.62365 ::1.6379 ESTABLISHED

1 ::1.62373 ::1.6379 ESTABLISHED

1 ::1.62375 ::1.6379 ESTABLISHED

1 ::1.62376 ::1.6379 ESTABLISHED

所以上面那张图就可以解释了,因为TIME_WAIT状态需要2msl的等待,并且ESTABLISHED里面的连接是不断创建的新连接,所以TIME_WAIT就会大量堆积。

代码分析

上面的结论已经发现是redis的连接导致的,并且是在客户端的连接堆积,代码里面使用的是redigo的pool。

package main

var (

Pool *redis.Pool

)

import (

"fmt"

"time"

"github.com/garyburd/redigo/redis"

)

func init() {

redisHost := os.Getenv("REDIS_HOST")

if redisHost == "" {

redisHost = ":6379"

}

Pool = newPool(redisHost)

cleanupHook()

}

func newPool(server string) *redis.Pool {

return &redis.Pool{

MaxIdle: 10,

MaxActive: 80,

Wait: False,

IdleTimeout: 0,

Dial: func() (redis.Conn, error) {

c, err := redis.Dial("tcp", server)

if err != nil {

return nil, err

}

return c, err

},

TestOnBorrow: func(c redis.Conn, t time.Time) error {

_, err := c.Do("PING")

return err

},

}

}

func worker(id int, jobs <-chan int, results chan<- int) {

for j := range jobs {

conn := Pool.Get()

defer conn.Close()

// pool get

data, _ := redis.Bytes(conn.Do("GET", key))

// 简化下,输出一个长度,模拟redis操作

results <- len(data)

}

}

func main() {

const numJobs = 100000

jobs := make(chan int)

results := make(chan int)

// 30个goroutine并发去读大概14w条redis数据

for w := 1; w <= 30; w++ {

go worker(w, jobs, results)

}

for j := 1; j <= numJobs; j++ {

jobs <- j

}

close(jobs)

for a := 1; a <= numJobs; a++ {

<-results

}

}一般来说,使用了pool的话应该是不会出现connection leak额现象,但是netstat观察到的并发远远不止80,于是只能去读源码。

redigo的Pool几个参数的意义:

type Pool struct {

// 创建新连接的函数

Dial func() (Conn, error)

// TestOnBorrow is an optional application supplied function for checking

// the health of an idle connection before the connection is used again by

// the application. Argument t is the time that the connection was returned

// to the pool. If the function returns an error, then the connection is

// closed.

TestOnBorrow func(c Conn, t time.Time) error

// 最大空闲连接,我理解的是可复用的连接.

MaxIdle int

// 允许的最大的连接,这里需要与wait配合使用.

MaxActive int

// 超过这个时间的空闲连接会被系统回收.

IdleTimeout time.Duration

// 这里是个关键,如果设置为True,Get操作才会阻塞,MaxActive才有意义,如果是false,达到限制后就会一直创建新的连接.

Wait bool

chInitialized uint32 // set to 1 when field ch is initialized

mu sync.Mutex // mu protects the following fields

closed bool // set to true when the pool is closed.

active int // the number of open connections in the pool

ch chan struct{} // limits open connections when p.Wait is true

idle idleList // idle connections

}Get操作的

func (p *Pool) get(ctx interface {

Done() <-chan struct{}

Err() error

}) (Conn, error) {

// Wait 配合 MaxActive 使用, 来保证 Get() 将要等待一个连接放到 Pool中, 才会返回一个连接给使用方.

if p.Wait && p.MaxActive > 0 {

p.lazyInit()

if ctx == nil {

<-p.ch

} else {

select {

case <-p.ch:

case <-ctx.Done():

return nil, ctx.Err()

}

}

}

p.mu.Lock()

// 循环idleList, 关闭空闲队列中连接时长大于 IdleTimeout 的连接.

if p.IdleTimeout > 0 {

n := p.idle.count

for i := 0; i < n && p.idle.back != nil && p.idle.back.t.Add(p.IdleTimeout).Before(nowFunc()); i++ {

c := p.idle.back.c

p.idle.popBack()

p.mu.Unlock()

c.Close()

p.mu.Lock()

p.active--

}

}

// 从idle list里面获取连接.

for p.idle.front != nil {

ic := p.idle.front

p.idle.popFront()

p.mu.Unlock()

if p.TestOnBorrow == nil || p.TestOnBorrow(ic.c, ic.t) == nil {

return ic.c, nil

}

ic.c.Close()

p.mu.Lock()

p.active--

}

// 检查pool是否已经关闭.

if p.closed {

p.mu.Unlock()

return nil, errors.New("redigo: get on closed pool")

}

// 检查是否到达pool的极限,当active大于p.MaxActive时候会报错.

if !p.Wait && p.MaxActive > 0 && p.active >= p.MaxActive {

p.mu.Unlock()

return nil, ErrPoolExhausted

}

// 创建新的连接

p.active++

p.mu.Unlock()

c, err := p.Dial()

if err != nil {

c = nil

p.mu.Lock()

p.active--

if p.ch != nil && !p.closed {

p.ch <- struct{}{}

}

p.mu.Unlock()

}

return c, err

}整个代码流程有几个地方需要注意:

- 并发workNum为30

- rerdigo pool 的wait为false

- rerdigo pool 的MaxActive为80

- rerdigo pool 的MaxIdle 为10

因为线上的连接数超高,所以打了下p.activeLog,发现p.active的活跃数量一直是维持在10左右,并没有达到PoolExhausted, 说明整个流程还是符合预期的在work。那么重点就需要放在MaxIdle这个参数里面了,回忆了下抓包的现象:ESTABLISHED的连接是一直变化,只有10个左右是一直不变的,根据代码来看说明pool复用的是idle里面的连接,当idle满了之后就会一直create new connection。

验证:

调整MaxIdle以及MaxActive的连接数量进行再次测试,由于并发的goroutine为30,所以调整MaxIdle为40,MaxActive 为200.

func newPool(server string) *redis.Pool {

return &redis.Pool{

MaxIdle: 40,

MaxActive: 200,

Wait: False,

IdleTimeout: 0,

Dial: func() (redis.Conn, error) {

c, err := redis.Dial("tcp", server)

if err != nil {

return nil, err

}

return c, err

},

TestOnBorrow: func(c redis.Conn, t time.Time) error {

_, err := c.Do("PING")

return err

},

}

}测试完发现这次没有connection leak了,线上的TIME_WAIT 也是在一个正常的数量级。另外也可以选择设置Wait为true,这样就会强制要求pool等待idle 里面的conn,也不会产生connection leak的现象。

小结

其实一开始比较疑惑的是为什么TIME_WAIT会比ESTABLISHED多这么多,一开始进入了死胡同,没有考虑到TIME_WAIT是一个逐渐堆积的状态,而ESTABLISHED会很快就释放掉。

另外线上并发数量和连接池的设置也是一个需要考虑的点,刚好踩了redigo的一个坑,线上出于性能考虑设置的wait为false,但是并发量又比较高,所以就悲剧了。

Raft 实现(MIT6.824 Lab)

Raft 实现(MIT6.824 Lab)

Background

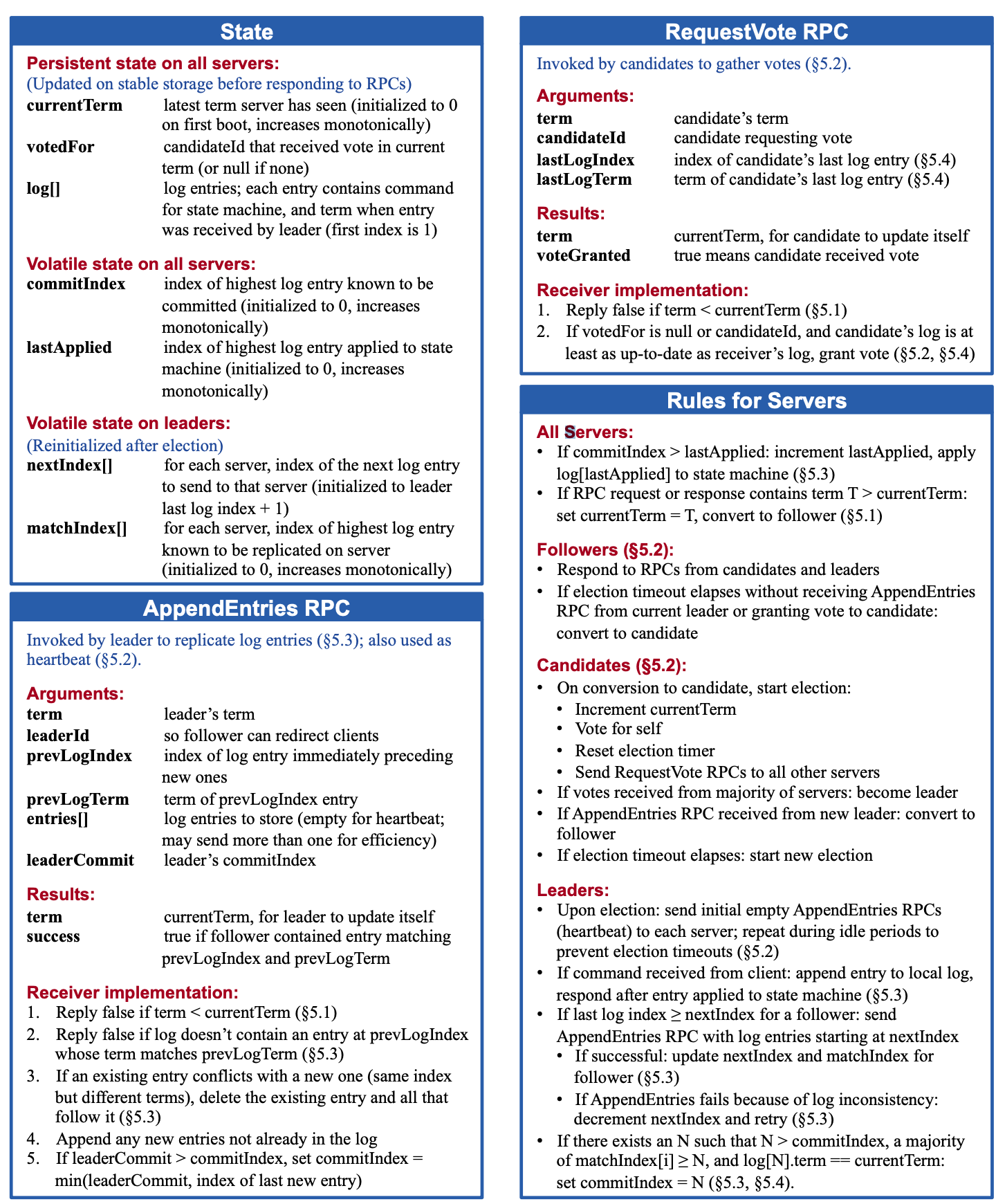

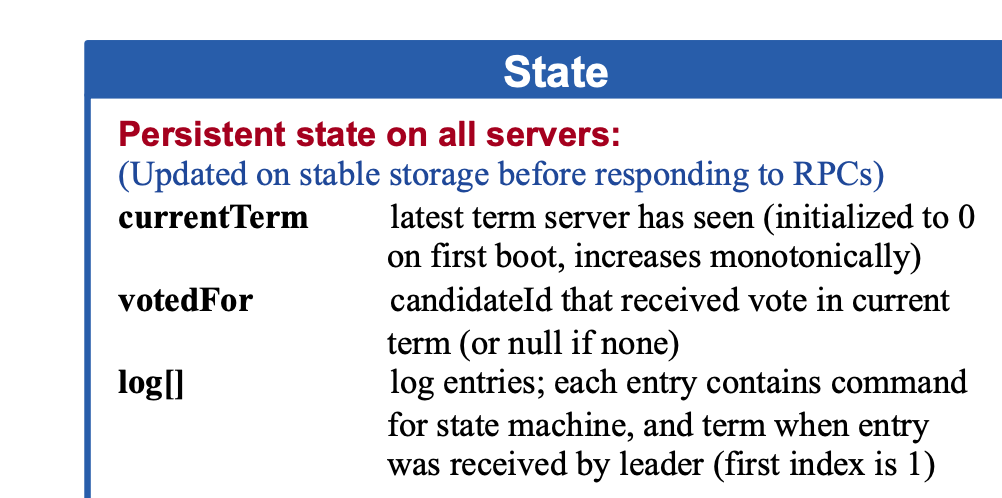

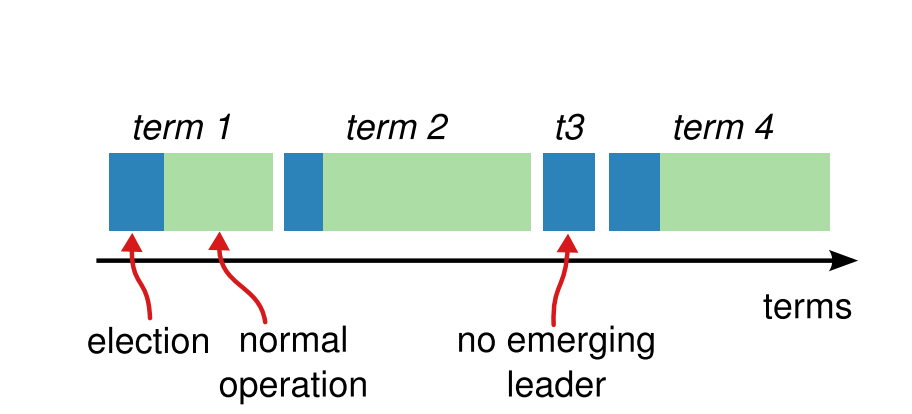

本篇是基于MIT6.824课后实践实现的一个简单Raft,包括三个部分:Leader选举,日志复制,持久化。整篇的核心在raft paper里面的figure2中,这张图可以直接理解为编程语言了,是整个raft的核心。

Leader选举

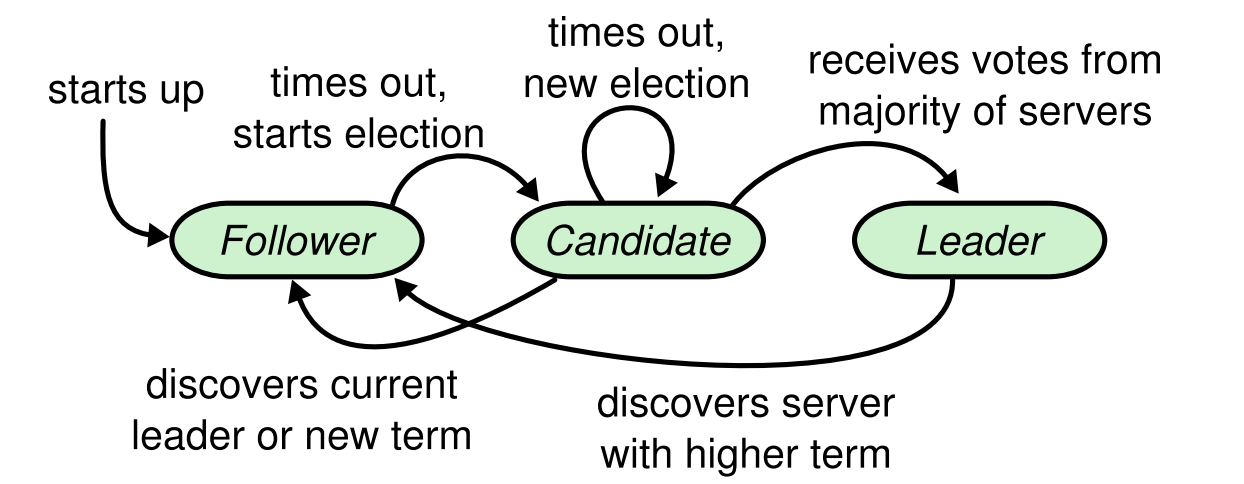

状态机

先理清楚两个timeout:electionTimeout以及heartbeatTimeout。

- 每个Follower节点初始化的时候都会随机设置一个electionTimeout,到达这个时间点就会变成Candidate发起投票请求。

- Leader需要维持心跳包,每隔一段时间即heartbeat timeout就会发送一个heart beat。

状态机的变化对照figure 2即可进行转化,这里我们只关注leader选举的部分。

Follower:

- 响应candidate的投票请求和leader的心跳请求

- 在electionTimeout时间内若没有收到心跳包或者投票请求则转化为candidate

Candidate:

- 变成Candidate后需要的操作

- 将自身的currentTerm自增

- 给自己投一票

- 重置electionTimeout

- 给其他节点发送投票请求

- 收到大多数响应就变成leader

- 如果收到心跳包就变成follower

- 如果electionTimeout超时,则再进行重试

Leader:

- 每间隔heartbeatTimeout则发送心跳包

Raft 结构体:

type Raft struct {

mu sync.RWMutex // Lock to protect shared access to this peer's state

peers []*labrpc.ClientEnd // RPC end points of all peers

persister *Persister // Object to hold this peer's persisted state

me int // this peer's index into peers[]

dead int32 // set by Kill()

// Your data here (2A, 2B, 2C).

// Look at the paper's Figure 2 for a description of what

// state a Raft server must maintain.

currentTerm int

votedFor int

logs []LogEntry

// Volatile state on all servers

commitIndex int

lastApplied int

// Volatile state on leaders

nextIndex []int

matchIndex []int

voteCount int

state uint64

granted chan struct{}

AppendEntries chan struct{}

electWin chan struct{}

applyCh chan ApplyMsg

}状态机里面的electionTimout设置为随机值是为了避免选举 split vote 情况。

func (rf *Raft) run() {

for {

switch rf.state {

case StateCandidate:

// vote

select {

// 超时,再重试一遍

case <-time.After(time.Millisecond * time.Duration(rand.Intn(200)+300)):

rf.mu.Lock()

rf.becomeCandidate()

rf.mu.Unlock()

case <-rf.AppendEntries:

rf.mu.Lock()

rf.becomeFollower("candidate receive heart beat")

rf.mu.Unlock() case <-rf.electWin:

rf.mu.Lock()

rf.becomeLeader()

rf.mu.Unlock()

}

case StateFollower:

select {

// 收到投票请求

case <-rf.granted:

// 收到心跳请求

case <-rf.AppendEntries:

case <-time.After(time.Millisecond * time.Duration(rand.Intn(200)+300)):

rf.mu.Lock()

rf.becomeCandidate()

rf.mu.Unlock()

}

case StateLeader:

go rf.sendAppendEntries()

time.Sleep(time.Millisecond * 100)

}

}

}

func (rf *Raft) becomeLeader() {

rf.debug("changed to Leader, id %d , term %d, logs %v", rf.me, rf.currentTerm, rf.logs)

rf.state = StateLeader

rf.nextIndex = make([]int, len(rf.peers))

rf.matchIndex = make([]int, len(rf.peers))

for i := range rf.peers {

rf.nextIndex[i] = rf.getLastIndex() + 1

}

}

func (rf *Raft) becomeFollower(reason string) {

rf.debug("changed to Follower, id %d, term %d, reason %s", rf.me, rf.currentTerm, reason)

rf.state = StateFollower

}

func (rf *Raft) becomeCandidate() {

rf.debug("changed to Candidate, id %d, term %d, logs %v", rf.me, rf.currentTerm, rf.logs)

rf.state = StateCandidate

rf.currentTerm++

rf.votedFor = rf.me

rf.voteCount = 1

rf.persist()

go rf.sendAllVotesRequests()

}为了调式方便,写了一个带时间戳的Log,输出的日志看的比较方便

func (rf *Raft) debug(msg string, a ...interface{}) {

if debug < 1 {

return

}

selfMsg := fmt.Sprintf(" [me:%d term:%d, state: %d, log: %d] ", rf.me, rf.currentTerm, rf.state, len(rf.logs))

fmt.Println(strconv.Itoa(int(time.Now().UnixNano())/1000) + selfMsg + fmt.Sprintf(msg, a...))

}投票请求 RequestVote

RequestVote接口是发起投票用的RPC接口,只能由candidate发起。默认理解为每个Raft 集群的Node上都会这么一个接口用来接收candidate发起的投票请求。

Candidate给其他节点发送请求,处理response也在这个函数里面。

func (rf *Raft) sendAllVotesRequests() {

rf.mu.Lock()

// 投票的参数

args := &RequestVoteArgs{}

args.Term = rf.currentTerm

args.CandidateId = rf.me

// args.LastLogIndex = rf.getLastIndex()

// args.LastLogTerm = rf.getLastTerm()

rf.mu.Unlock()

var wg sync.WaitGroup

for p := range rf.peers {

if p != rf.me {

wg.Add(1)

go func(p int) {

defer wg.Done()

ok := rf.sendRequestVote(p, args, &RequestVoteReply{})

if !ok {

rf.debug("send request to p: %d, ok: %v", p, ok)

}

}(p)

}

}

wg.Wait()

rf.mu.Lock()

// 等待结果返回,如果符合quorum协议,则投票成功

win := rf.voteCount >= len(rf.peers)/2+1

// make sure the vote request is valid

if win && args.Term == rf.currentTerm {

rf.electWin <- struct{}{}

}

rf.debug("vote finished, voteCount: %d, win: %v", rf.voteCount, win)

rf.mu.Unlock()

}sendRequestVote里面加入了RPC的timeout,是因为测试用例里面会模拟网络不可达的情况,如果一个请求一直hang下去,系统会更加复杂。虽然paper上说的是可以无限重试,但是实际生产环境中外部RPC调用都是需要加上一个timeout来保护资源泄漏。

func (rf *Raft) sendRequestVote(server int, args *RequestVoteArgs, reply *RequestVoteReply) bool {

respCh := make(chan bool)

ok := false

go func() {

respCh <- rf.peers[server].Call("Raft.RequestVote", args, reply)

}()

select {

case <-time.After(time.Millisecond * 60): // 1s

return false

case ok = <-respCh:

}

if !ok {

return false

}

rf.mu.Lock()

defer rf.mu.Unlock()

defer rf.persist()

if rf.state != StateCandidate || args.Term != rf.currentTerm {

return ok

}

// 当前term较小了

if reply.Term > rf.currentTerm {

rf.becomeFollower("candidate received large term")

rf.currentTerm = args.Term

rf.votedFor = -1

}

if reply.VoteGranted {

rf.voteCount++

}

return ok

}心跳维持 AppendEntries

心跳包的维持是每隔一段时间(heartbeat timeout)去发送的,函数名为AppendEntries,因为log之后的数据每次同步也都是在这里面发送的。

func (rf *Raft) sendAppendEntries() {

var wg sync.WaitGroup

rf.mu.RLock()

for p := range rf.peers {

if p != rf.me {

args := &RequestAppendEntriesArgs{}

// 发送leader term

args.Term = rf.currentTerm

// leader ID

args.LeaderID = rf.me

// 日志同步需要用到的 leader 选举暂时用不到

args.PrevLogIndex = rf.nextIndex[p] - 1

args.LeaderCommit = rf.commitIndex

if args.PrevLogIndex >= 0 {

args.PrevLogTerm = rf.logs[args.PrevLogIndex].Term

}

// 发送空数据

if rf.nextIndex[p] <= rf.getLastIndex() {

args.Entries = rf.logs[rf.nextIndex[p]:]

}

//rf.debug("send Entries is: %v, index is: %d", args.Entries, p)

wg.Add(1)

go func(p int, args *RequestAppendEntriesArgs) {

defer wg.Done()

ok := rf.sendRequestAppendEntries(p, args, &RequestAppendEntriesReply{})

if !ok {

rf.debug("send %d AppendEntries result:%v", p, ok)

}

}(p, args)

}

}

rf.mu.RUnlock()

wg.Wait()

}Leader在发送RPC请求的时候也需要带上一个timeout,这样方便控制整个流程。

func (rf *Raft) sendRequestAppendEntries(server int, args *RequestAppendEntriesArgs, reply *RequestAppendEntriesReply) bool {

respCh := make(chan bool)

ok := false

go func() {

respCh <- rf.peers[server].Call("Raft.RequestAppendEntries", args, reply)

}()

select {

case <-time.After(time.Millisecond * 60): // 100ms

return false

case ok = <-respCh:

}

rf.mu.Lock()

defer rf.mu.Unlock()

if !ok || rf.state != StateLeader || args.Term != rf.currentTerm {

return ok

}

if reply.Term > rf.currentTerm {

rf.becomeFollower("leader expired")

rf.currentTerm = reply.Term

rf.persist()

return ok

}

return ok被调用方收到的请求处理流程

func (rf *Raft) RequestAppendEntries(args *RequestAppendEntriesArgs, reply *RequestAppendEntriesReply) {

rf.mu.Lock()

defer rf.mu.Unlock()

defer rf.persist()

if args.Term < rf.currentTerm {

reply.Term = rf.currentTerm

return

}

// 发送channel表示收到心跳包,重置timeout

rf.AppendEntries <- struct{}{}

if args.Term > rf.currentTerm {

rf.currentTerm = args.Term

if rf.state != StateFollower {

rf.becomeFollower("request append receive large term")

rf.votedFor = -1

}

}

reply.Success = true日志复制

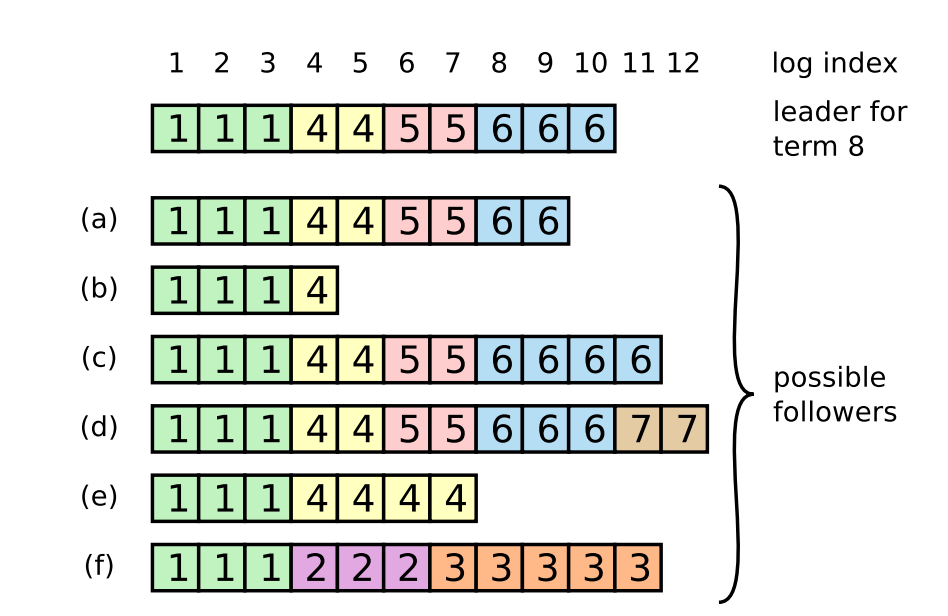

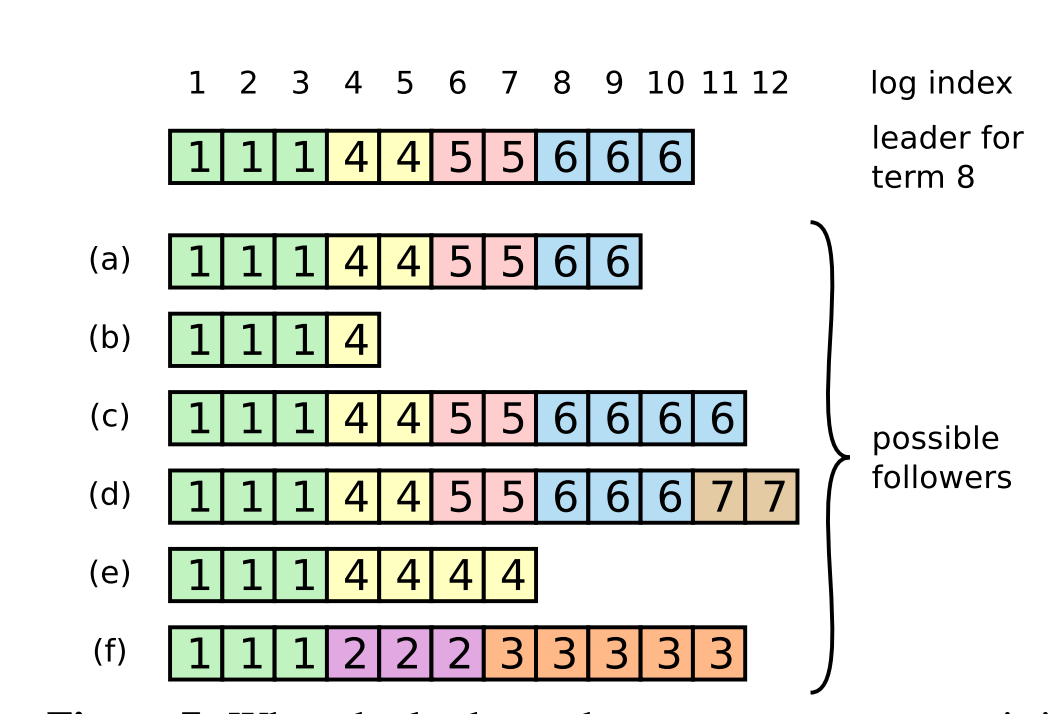

日志复制应该算是整个Lab里面最复杂的一部分,先简单回顾下paper内容。

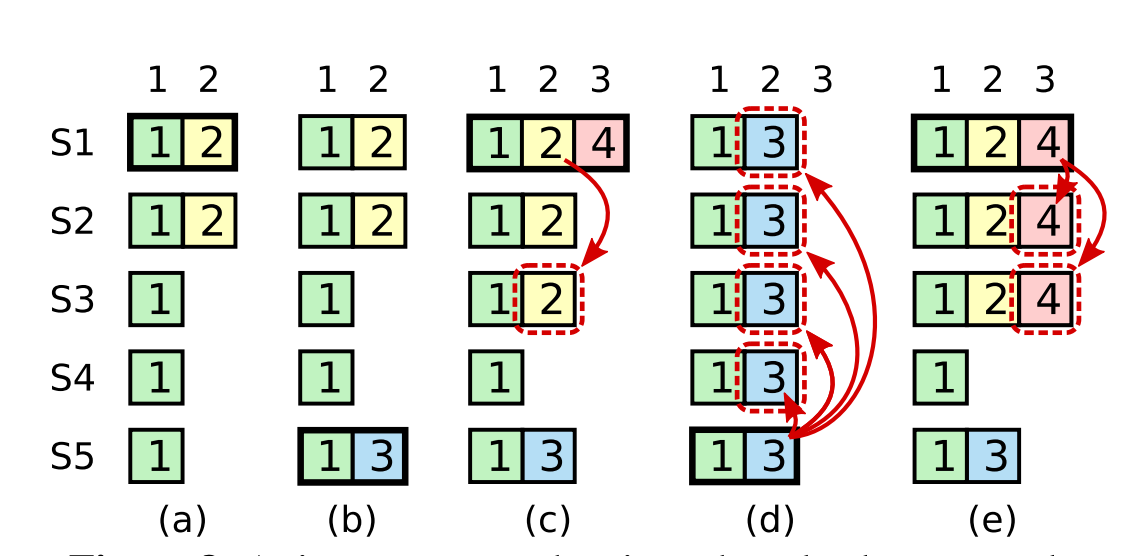

当Leader被选出来后,就可以接受客户端发来的请求了,每个请求包含一条需要被replicated state machines执行的命令。leader会把它作为一个log entry append到日志中,然后给其它的server发AppendEntriesRPC请求。当Leader确定一个log entry被safely replicated了(大多数副本已经将该命令写入日志当中),就apply这条log entry到状态机中然后返回结果给客户端。如果某个Follower宕机了或者运行的很慢,或者网络丢包了,则会一直给这个Follower发AppendEntriesRPC直到日志一致。

当一条日志是commited时,Leader才可以将它应用到状态机中。Raft保证一条commited的log entry已经持久化了并且会被所有的节点执行。

因此,需要有一种机制来让leader和follower对log达成一致,leader会为每个follower维护一个nextIndex,表示leader给各个follower发送的下一条log entry在log中的index,初始化为leader的最后一条log entry的下一个位置。leader给follower发送AppendEntriesRPC消息,带着(term_id, (nextIndex-1)), term_id即(nextIndex-1)这个槽位的log entry的term_id,follower接收到AppendEntriesRPC后,会从自己的log中找是不是存在这样的log entry,如果不存在,就给leader回复拒绝消息,然后leader则将nextIndex减1,再重复,知道AppendEntriesRPC消息被接收。

初始化,nextIndex为11,leader给b发送AppendEntriesRPC(6,10),b在自己log的10号槽位中没有找到term_id为6的log entry。则给leader回应一个拒绝消息。接着,leader将nextIndex减一,变成10,然后给b发送AppendEntriesRPC(6, 9),b在自己log的9号槽位中同样没有找到term_id为6的log entry。循环下去,直到leader发送了AppendEntriesRPC(4,4),b在自己log的槽位4中找到了term_id为4的log entry。接收了消息。随后,leader就可以从槽位5开始给b推送日志了。

相较于leader选举,根据figure2可以知道会增加几个变量,先解释几个参数的意义:

type raft struct {

logs []LogEntry

commitIndex int

lastApplied int

nextIndex []int

matchIndex []int

applyCh chan ApplyMsg

}- commitIndex 表示的是当前节点已经commit的位置

- lastApplied 表示的是上次apply的位置

- nextIndex 里面是一个数组,只有leader的nextIndex才有意义,表示的是希望与对应的peer下次同步日志的位置,初始化的时候是当前最长log的位置

- matchIndex 是用来表示已经同步过log的位置,初始化的时候位置为0,这个也是只有leader才有意义

- applyCh 在commit之后可以进行apply操作的channel

Log可以定义为[]LogEntry, 里面的command是Lab所需要的,这么一来Log的定义就完成了。

type LogEntry struct {

Term int

Command interface{}

}RequestVoteArgs 里面会新增LastLogIndex和LastLogTerm,用来判断当前leader是否是最新的。

type RequestVoteArgs struct {

LastLogIndex int

LastLogTerm int

}另外RequestAppendEntriesArgs里面也有所改变

type RequestAppendEntriesArgs struct {

// Your data here (2A, 2B).

PrevLogIndex int

PrevLogTerm int

Entries []LogEntry

}PrevLogIndex对应的Leader中的nextIndex数组减去一,PrevLogTerm同理。

接受写请求 Start

这里唯一需要注意的一点就是Lab与raft paper不同,每次是直接在append之后就返回,没有等待其他Leader的append。

func (rf *Raft) Start(command interface{}) (int, int, bool) {

rf.mu.Lock()

defer rf.mu.Unlock()

defer rf.persist()

if rf.state != StateLeader {

return 0, 0, false

}

index := rf.getLastIndex() + 1

term := rf.currentTerm

isLeader := true

// Your code here (2B).

// append to current logs

rf.logs = append(rf.logs, LogEntry{term, command})

rf.debug("receive start command, logs is :%v", rf.logs)

return index, term, isLeader

}Log发送 AppendEntries

相较于上次的Leader选举,新的AppendEntries会去同步日志,主要需要构建 PrevLogIndex以及Entries,Entries为空的话发送一个心跳包即可。

func (rf *Raft) sendAppendEntries() {

var wg sync.WaitGroup

rf.mu.RLock()

for p := range rf.peers {

if p != rf.me {

args := &RequestAppendEntriesArgs{}

args.Term = rf.currentTerm

args.LeaderID = rf.me

args.PrevLogIndex = rf.nextIndex[p] - 1

args.LeaderCommit = rf.commitIndex

if args.PrevLogIndex >= 0 {

args.PrevLogTerm = rf.logs[args.PrevLogIndex].Term

}

// send empty data if index are same

if rf.nextIndex[p] <= rf.getLastIndex() {

args.Entries = rf.logs[rf.nextIndex[p]:]

}

//rf.debug("send Entries is: %v, index is: %d", args.Entries, p)

wg.Add(1)

go func(p int, args *RequestAppendEntriesArgs) {

defer wg.Done()

ok := rf.sendRequestAppendEntries(p, args, &RequestAppendEntriesReply{})

if !ok {

rf.debug("send %d AppendEntries result:%v", p, ok)

}

}(p, args)

}

}

rf.mu.RUnlock()

wg.Wait()

}在看具体发送逻辑, 在每次成功响应后都会去提交日志, 更新Leader本地的rf.nextIndex以及rf.matchIndex。RetryIndex是用来优化的一个点,下个函数会讲到。

func (rf *Raft) sendRequestAppendEntries(server int, args *RequestAppendEntriesArgs, reply *RequestAppendEntriesReply) bool {

respCh := make(chan bool)

ok := false

go func() {

respCh <- rf.peers[server].Call("Raft.RequestAppendEntries", args, reply)

}()

select {

case <-time.After(time.Millisecond * 60): // 100ms

return false

case ok = <-respCh:

}

rf.mu.Lock()

defer rf.mu.Unlock()

if !ok || rf.state != StateLeader || args.Term != rf.currentTerm {

return ok

}

if reply.Term > rf.currentTerm {

rf.becomeFollower("leader expired")

rf.currentTerm = reply.Term

rf.persist()

return ok

}

//rf.debug("rf matchIndex is %v", rf.matchIndex)

if reply.Success {

rf.matchIndex[server] = args.PrevLogIndex + len(args.Entries)

//rf.debug("reply success, server is %d, matchIndex is %d", server, rf.matchIndex[server])

rf.nextIndex[server] = rf.matchIndex[server] + 1

go rf.commit()

} else {

rf.nextIndex[server] = reply.RetryIndex

}

return ok

}Commit的逻辑也很简单,遍历peers,如果超过半数以上的matchIndex都等于当前Leader Log的结尾,则认为这是一次有效的Append,进行提交。

func (rf *Raft) commit() {

majority := len(rf.peers)/2 + 1

for i := rf.getLastIndex(); i > rf.commitIndex; i-- {

count := 1

if rf.logs[i].Term == rf.currentTerm {

for j := range rf.peers {

if j == rf.me {

continue

}

// 当前的Leader的Log得到认可

if rf.matchIndex[j] >= i {

count++

}

}

}

if count >= majority {

rf.commitIndex = i

go rf.applyLog()

break

}

}

}

func (rf *Raft) applyLog() {

rf.mu.Lock()

defer rf.mu.Unlock()

// apply changes

for i := rf.lastApplied + 1; i <= rf.commitIndex; i++ {

msg := ApplyMsg{CommandIndex: i, Command: rf.logs[i].Command, CommandValid: true}

rf.debug("send msg is: %v, lastApplied is %d, commitIndex is %d", msg, rf.lastApplied, rf.commitIndex)

rf.applyCh <- msg

}

rf.lastApplied = rf.commitIndex

}接受方的逻辑,使用retry index进行优化,当收到的request是有效之后,覆盖有冲突的Logs,直接从rf.logs[:args.PrevLogIndex+1]开始,然后进行提交。

func (rf *Raft) RequestAppendEntries(args *RequestAppendEntriesArgs, reply *RequestAppendEntriesReply) {

rf.mu.Lock()

defer rf.mu.Unlock()

defer rf.persist()

if args.Term < rf.currentTerm {

reply.Term = rf.currentTerm

return

}

rf.AppendEntries <- struct{}{}

if args.Term > rf.currentTerm {

rf.currentTerm = args.Term

if rf.state != StateFollower {

rf.becomeFollower("request append receive large term")

rf.votedFor = -1

}

}

// which means the request need to decrease the index and send request again

if args.PrevLogIndex > rf.getLastIndex() {

reply.RetryIndex = rf.getLastIndex() + 1

return

}

// 这里使用retry index 其实是一个优化点

// paper 里面是每次自减,回复一个false,这里直接找到下一个term的位置

// 减少了心跳包的发送次数

if args.PrevLogIndex > 0 && rf.logs[args.PrevLogIndex].Term != args.PrevLogTerm {

for reply.RetryIndex = args.PrevLogIndex - 1;

reply.RetryIndex > 0 && rf.logs[reply.RetryIndex].Term == rf.logs[args.PrevLogIndex].Term;

reply.RetryIndex-- {

}

return

}

rf.logs = append(rf.logs[:args.PrevLogIndex+1], args.Entries...)

//rf.debug("args.LeaderCommit is :%d, PrevLogIndex %d, commitIndex: %d", args.LeaderCommit, args.PrevLogIndex, rf.commitIndex)

if args.LeaderCommit > rf.commitIndex {

rf.commitIndex = min(rf.getLastIndex(), args.LeaderCommit)

go rf.applyLog()

}

reply.Success = true

}持久化

根据Paper的内容,需要持久化的内容有三个:currentterm, votedFor, log[]

这就意味着每次当raft结构体内上诉三个变量发生改变的时候我们都需要将其持久化。persisth和readPersist都很简单。

func (rf *Raft) persist() {

// Your code here (2C).

// Example:

w := new(bytes.Buffer)

e := labgob.NewEncoder(w)

e.Encode(rf.currentTerm)

e.Encode(rf.votedFor)

e.Encode(rf.logs)

data := w.Bytes()

rf.persister.SaveRaftState(data)

}

//

// restore previously persisted state.

//

func (rf *Raft) readPersist(data []byte) {

if data == nil || len(data) < 1 { // bootstrap without any state?

return

}

r := bytes.NewBuffer(data)

d := labgob.NewDecoder(r)

d.Decode(&rf.currentTerm)

d.Decode(&rf.votedFor)

d.Decode(&rf.logs)

}至于Persist调用的地方只要完成了前面两个实现,添加也很简单,这里就不再贴代码了。

小结

在调测试的时候其实是很懵的,需要仔细看看测试代里面的内容,然后在调试的时候带上时间戳以及当前节点的信息,这样看起来就会容易许多。实现部分的代码其实没有多少,最精华的部分应该是这部分的测试代码,从模拟分区再到split over,再到节点的网络失效,有兴趣的可以仔细看下实现。

reference

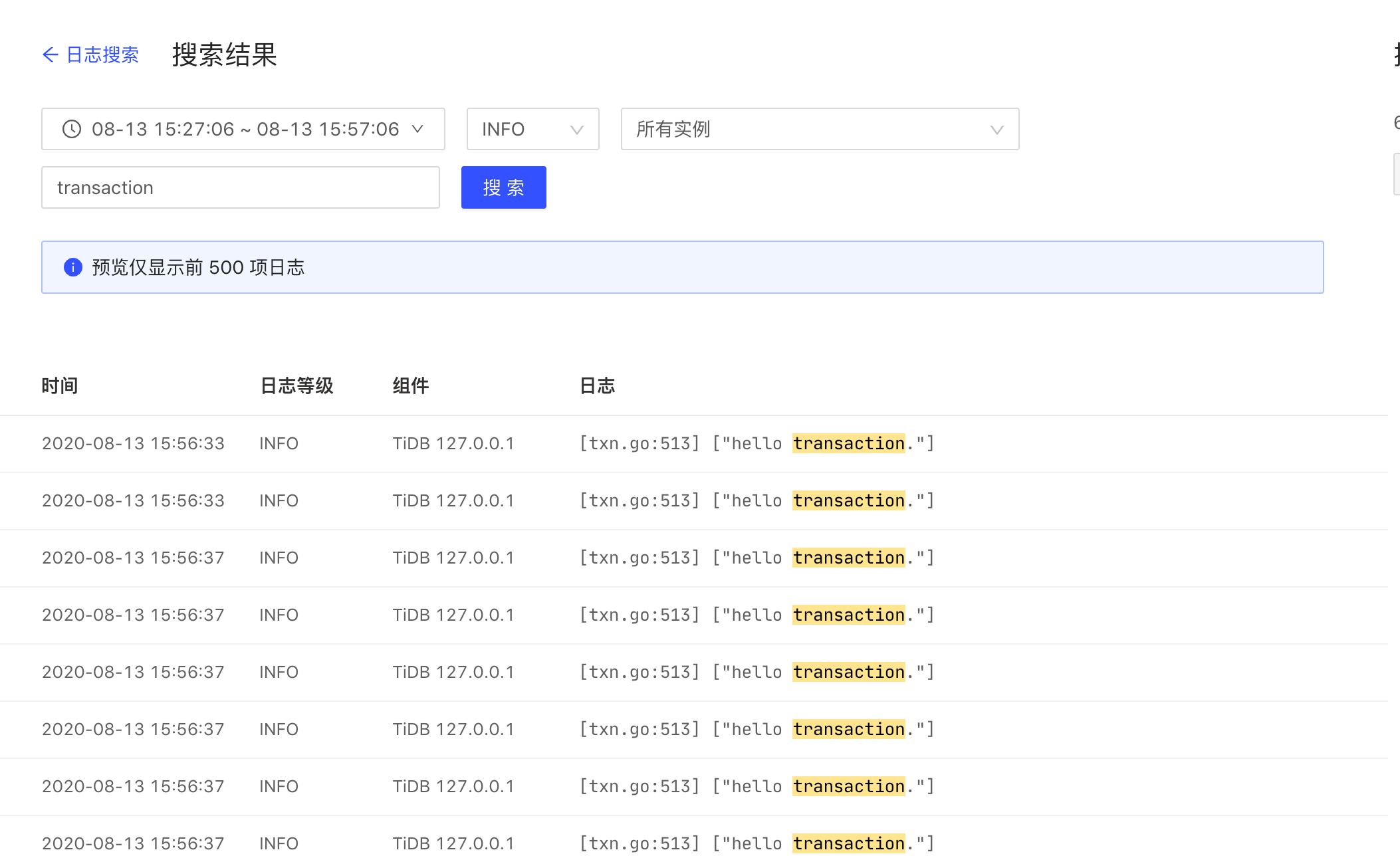

TiDB HomeWork-1

TiDB HomeWork-1

目标

下载编译 TiDB/PD/TiKV 并修改源代码,使得事物启动时输出hello transaction的日志。

本机器环境MBP:

CPU: Intel(R) Core(TM) i7-8850H CPU @ 2.60GHz

内存: 16 GB 2400 MHz DDR4

步骤

Clone 项目到本地

- Clone

TiDB项目git clone [email protected]:pingcap/tidb.git - Clone

TiKV项目git clone [email protected]:tikv/tikv.git - Clone

pd项目git clone [email protected]:pingcap/pd.git

修改代码

在 tidb 目录下全文search transaction 相关的内容,在tidb/store/tikv/txn里面可以找到startTS 函数,对其进行修改即可。

func (txn *tikvTxn) StartTS() uint64 {

logutil.Logger(context.Background()).Info("hello transaction.")

return txn.startTS

}编译

Clone完成项目后发现tidb里面 go.mod 最低的环境要求是1.13,小于1.13版本的请先升级本地的Go环境,每个项目里面都有Makefile,所以我们直接make进行编译就好:

➜ tidb git:(v4.0.4) ✗ make

CGO_ENABLED=1 GO111MODULE=on go build -tags codes -ldflags '-X "github.com/pingcap/parser/mysql.TiDBReleaseVersion=v4.0.4-dirty" -X "github.com/pingcap/tidb/util/versioninfo.TiDBBuildTS=2020-08-13 09:10:26" -X "github.com/pingcap/tidb/util/versioninfo.TiDBGitHash=c61fc7247e9f6bc773761946d5b5294d3f2699a5" -X "github.com/pingcap/tidb/util/versioninfo.TiDBGitBranch=heads/v4.0.4" -X "github.com/pingcap/tidb/util/versioninfo.TiDBEdition=Community" ' -o bin/tidb-server tidb-server/main.go

Build TiDB Server successfully!然后再以相同的命令依次编译tikv以及pd即可。编译的时候要等的时间比较长,rust的编译速度确实慢。

编译完成后,三个文件夹的二进制文件默认未知分别位于tidb/bin/tidb-server, pd/bin/pd-server, tikv/target/release/tikv-server。

这里需要注意如果都用线上master的编译可能不是稳定版本,出来的界面可能有一点问题,所以需要用一个统一的版本去编译。我这里统一checkout 到了 v4.0.4

启动

官方推荐用tiup进行管理集群,docker-compose 方式已废弃,直接看文章介绍即可

Flags:

--db int 设置集群中的 TiDB 数量(默认为1)

--db.binpath string 指定 TiDB 二进制文件的位置(开发调试用,可忽略)

--db.config string 指定 TiDB 的配置文件(开发调试用,可忽略)

--db.host host 指定 TiDB 的监听地址

--drainer int 设置集群中 Drainer 数据

--drainer.binpath string 指定 Drainer 二进制文件的位置(开发调试用,可忽略)

--drainer.config string 指定 Drainer 的配置文件

-h, --help 打印帮助信息

--host string 设置每个组件的监听地址(默认为 127.0.0.1),如果要提供给别的电脑访问,可设置为 0.0.0.0

--kv int 设置集群中的 TiKV 数量(默认为1)

--kv.binpath string 指定 TiKV 二进制文件的位置(开发调试用,可忽略)

--kv.config string 指定 TiKV 的配置文件(开发调试用,可忽略)

--monitor 是否启动监控

--pd int 设置集群中的 PD 数量(默认为1)

--pd.binpath string 指定 PD 二进制文件的位置(开发调试用,可忽略)

--pd.config string 指定 PD 的配置文件(开发调试用,可忽略)

--pump int 指定集群中 Pump 的数量(非 0 的时候 TiDB 会开启 TiDB Binlog)

--pump.binpath string 指定 Pump 二进制文件的位置(开发调试用,可忽略)

--pump.config string 指定 Pump 的配置文件(开发调试用,可忽略)

--tiflash int 设置集群中 TiFlash 数量(默认为0)

--tiflash.binpath string 指定 TiFlash 的二进制文件位置(开发调试用,可忽略)

--tiflash.config string 指定 TiFlash 的配置文件(开发调试用,可忽略)

所以最后我们的启动命令就是

➜ pingcap tiup playground --db.binpath ./tidb/bin/tidb-server --pd.binpath ./pd/bin/pd-server --kv.binpath ./tikv/target/release/tikv-server --db 1 --pd 1 --kv 3

Starting component `playground`: --db.binpath ./tidb/bin/tidb-server --pd.binpath ./pd/bin/pd-server --kv.binpath ./tikv/target/release/tikv-server --db 1 --pd 1 --kv 3

Use the latest stable version: v4.0.4

Specify version manually: tiup playground <version>

The stable version: tiup playground v4.0.0

The nightly version: tiup playground nightly

Playground Bootstrapping...

Start pd instance...

Start tikv instance...

Start tikv instance...

Start tikv instance...

Start tidb instance...

........

Waiting for tikv 127.0.0.1:20160 ready

Waiting for tikv 127.0.0.1:20161 ready

Waiting for tikv 127.0.0.1:20162 ready

Start tiflash instance...

Waiting for tiflash 127.0.0.1:3930 ready ...

CLUSTER START SUCCESSFULLY, Enjoy it ^-^

To connect TiDB: mysql --host 127.0.0.1 --port 4000 -u root

To view the dashboard: http://127.0.0.1:2379/dashboard

To view the Prometheus: http://127.0.0.1:9090

To view the Grafana: http://127.0.0.1:3000

然后登陆http://127.0.0.1:2379/dashboard 查看日志结果,正常输出hello, transaction.

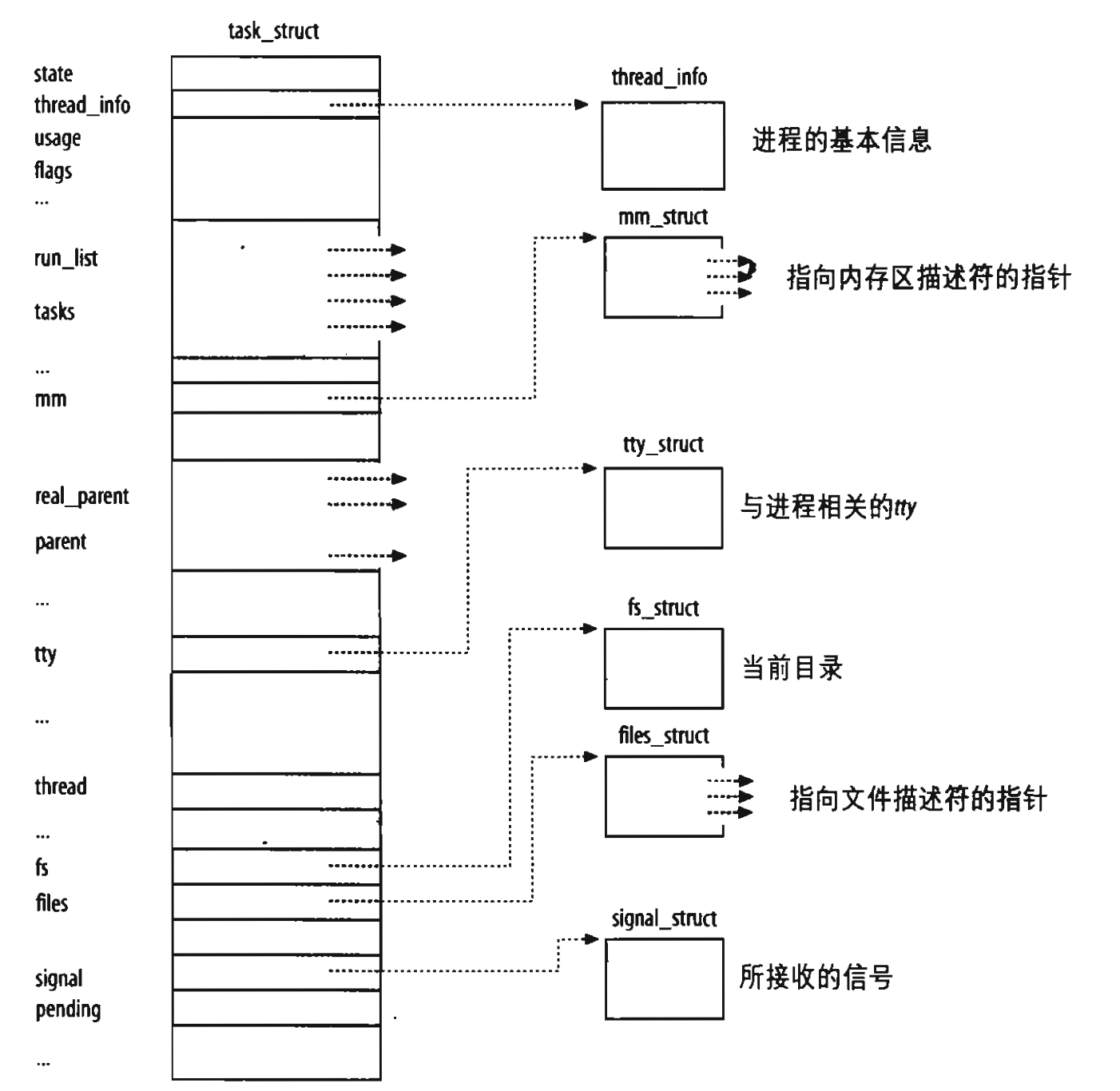

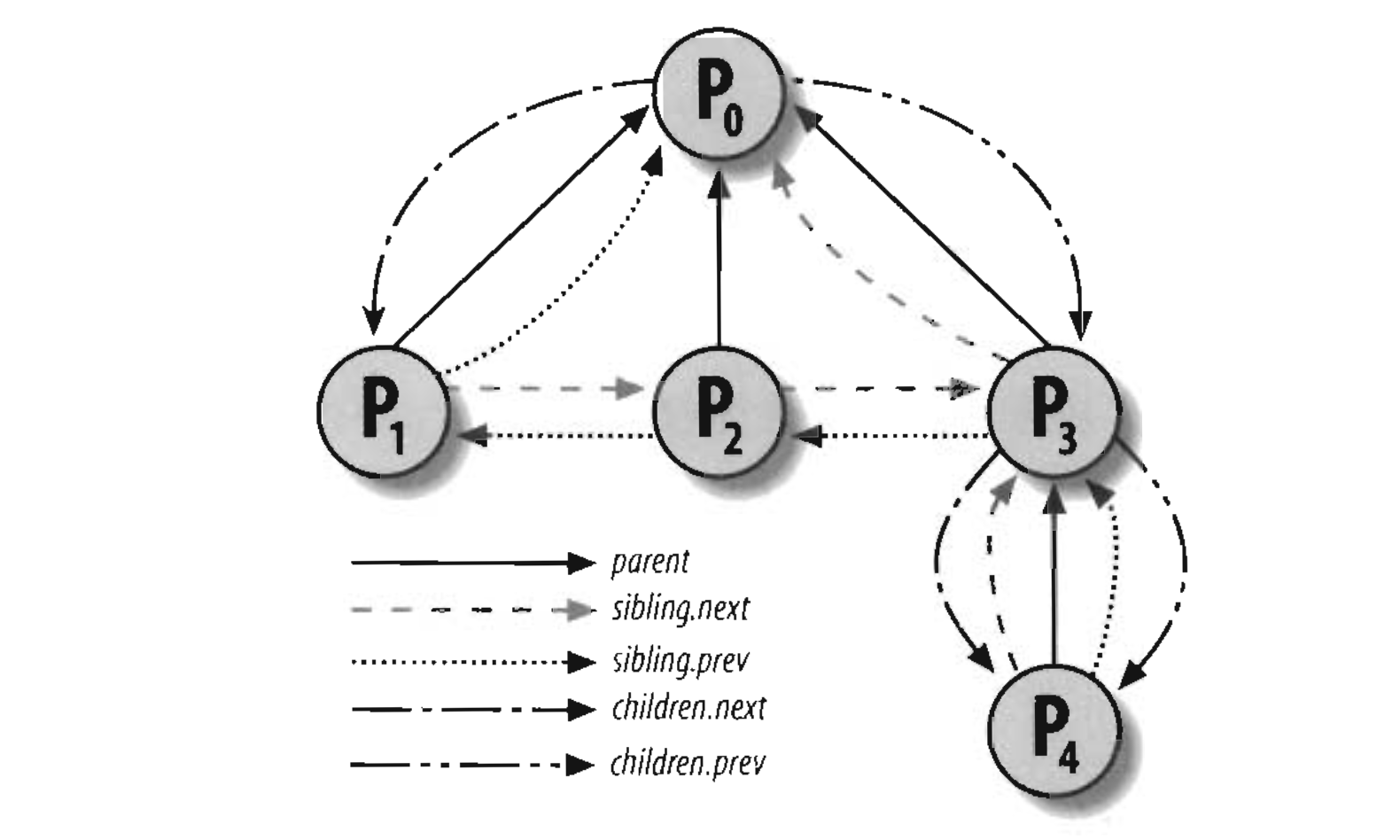

《深入理解linux内核》笔记-内核同步

#《深入理解linux内核》笔记-内核同步

定义

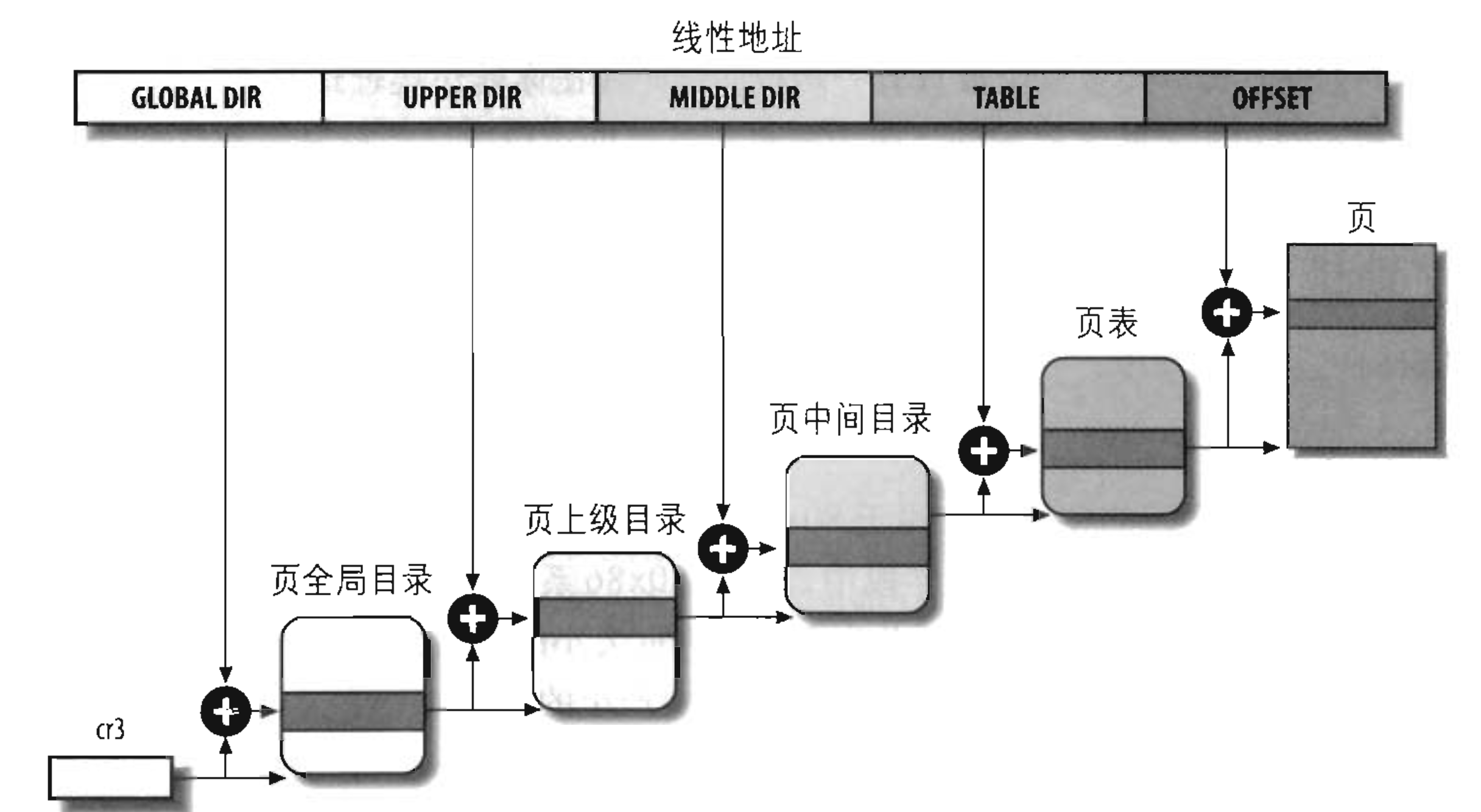

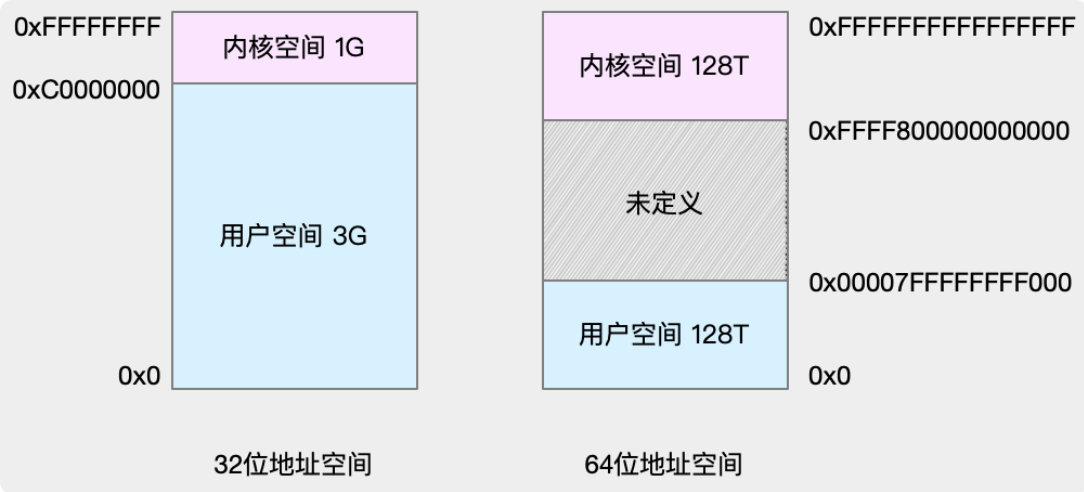

在现代操作系统里,同一时间可能有多个内核执行流在执行,因此内核其实象多进程多线程编程一样也需要一些同步机制来同步各执行单元对共享数据的访问。尤其是在多处理器系统上,更需要一些同步机制来同步不同处理器上的执行单元对共享的数据的访问。

原子操作

原子操作可以保证指令以原子的方式执行一执行过程不被打断。 众所周知,原子原本指的是不可分割的微粒,所以原子操作也就是不能够被分割的指令。我们熟知的Atomic一系列操作就是原子操作。

内核提供了两组原子操作接口一-组针对整 数进行操作,另一组针对单独的位进行操作。在Linux支持的所有体系结构上都实现了这两组接口。大多数体系结构会提供支持原子操作的简